Die vergangene Woche der Online-Marketing-Welt wurde durch den Rücktritt von Larry Page als Google-Vorstand und Sergey Brin als Google-Präsident geprägt. Darüber hinaus hat Google das „Nov. 2019 Local Search Update“ bestätigt. Die größten SEO-Schlagzeilen blieben aus unserer Sicht aber aus. Aus diesem Grund wollen wir uns einem allgemeineren SEO-Thema widmen: der Indexbereinigung. Erfahrt in unserem Top-Thema, wie Ihr eine Indexaufblähung identifizieren könnt. In einem künftigen Wochenrückblick werden wir Euch dann erklären, wie Ihr Seiten aus dem Index entfernen könnt. Wir wünschen Euch viel Spaß beim Lesen!

So identifiziert Ihr eine Indexaufblähung

Eigentlich sollte man im ersten Moment als Webmaster davon ausgehen, dass je mehr Seiten im Index von Suchmaschinen auftauchen, desto größeren Erfolg kann eine Website haben, was beispielsweise den Search Traffic anbelangt. Diese Aussage mag per se nicht falsch sein, aber sie trifft auch nicht pauschal zu. Somit widmen wir uns einem großen SEO-Thema, das ein Problem für sehr viele Seiten darstellt – dem sogenannten „Index Bloat“, was im Deutschen so viel wie Indexaufblähung bedeutet.

Wann kann von einer Indexaufblähung gesprochen werden?

Eine Aufblähung tritt dann ein, wenn der Index einer Suchmaschine Seiten beinhaltet, die nicht suchrelevant sind und somit keinen Mehrwert für den Nutzer bieten. Ein sehr gängiger Aspekt ist Duplicate Content. Google kann zwar selbst oft schon Duplikate erkennen und schließt diese von einer Indexierung aus. Nichtsdestotrotz sollte dieses Thema immer bei der Betrachtung eines Index eine wichtige Rolle einnehmen. Hier sind einige von Search Engine Journal zusammengefasste Beispiele, die für eine Indexaufblähung sorgen können:

- Parameterseiten verursacht durch beispielsweise unterschiedliche Filterkombinationen

- Archivseiten

- paginierte Seiten

- veraltete Inhalte

- Seiten aus der internen Suchfunktion

Ein Thema, welches hier nicht explizit genannt wurde, mit Duplicate Content aber eng verwandt ist, ist Keyword-Kannibalisierung. Dieser Zustand liegt vor, wenn Seiten für identische Suchanfragen zu ähnlichen Positionen ranken, weil sie inhaltlich eng miteinander verwandt sind. Die Suchmaschine hat folglich Schwierigkeiten zu entscheiden, welche Seite dem Nutzer den relevantesten Content zur jeweiligen Suchanfrage liefern kann. Die Seiten konkurrieren also zu identischen Keywords. Alles in allem wirkt sich dies negativ auf die Ranking-Fähigkeit der Seiten aus.

Mit welchen Methoden könnt Ihr eine Indexaufblähung identifizieren?

Grundlegend gibt es zwei Ansätze, wie Ihr eine Indexaufblähung gut aufspüren könnt:

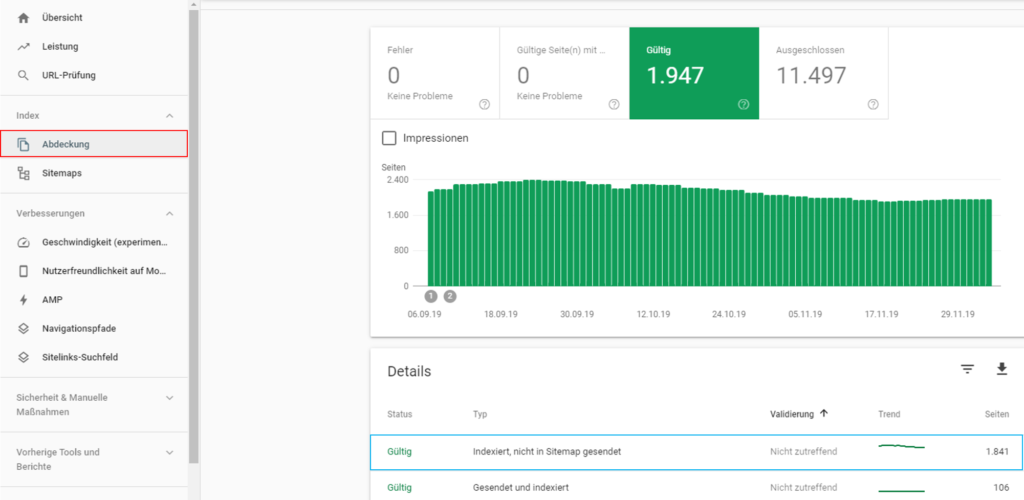

1. Eine sehr gute Möglichkeit ist, einen Blick in die Google Search Console zu werfen. Hier wird im Abdeckungsbericht (siehe Grafik, rote Markierung) angezeigt, wie viele URLs sich aktuell von einer Domain im Index befinden. Klickt Ihr auf „Gültig“, werden Euch unter Details sämtliche indexierte URLs angezeigt, die sich entweder in der von Euch hinterlegten XML-Sitemap befinden oder solche, die nicht aufgenommen wurden (siehe Grafik, blaue Markierung). Generell dient eine XML-Sitemap dazu, es Crawlern wie dem Google Bot zu erleichtern, sich auf Eurer Seite zurechtzufinden. Häufig vereinfacht dies auch den Indexierungsprozess. Habt Ihr Eure XML-Sitemap optimiert, befinden sich ausschließlich SEO-relevante Seiten in dem Dokument. Es handelt sich hierbei um Seiten, die folglich nicht zu einer Indexaufblähung führen können (siehe Beispiel oben von Search Engine Journal). Bei einer gepflegten XML-Sitemap enthält die Rubrik „Indexiert, nicht in Sitemap gesendet“ also URLs, die nicht SEO-relevant sind. Aus diesem Grund könnt Ihr Euch fragen, mit welcher Berechtigung sich diese Seiten im Index befinden.

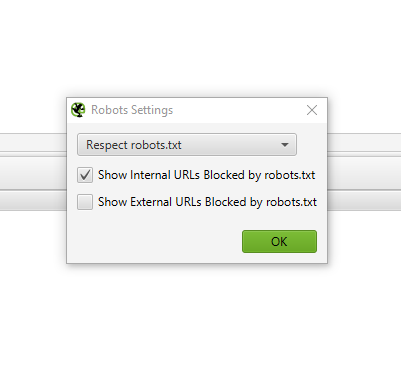

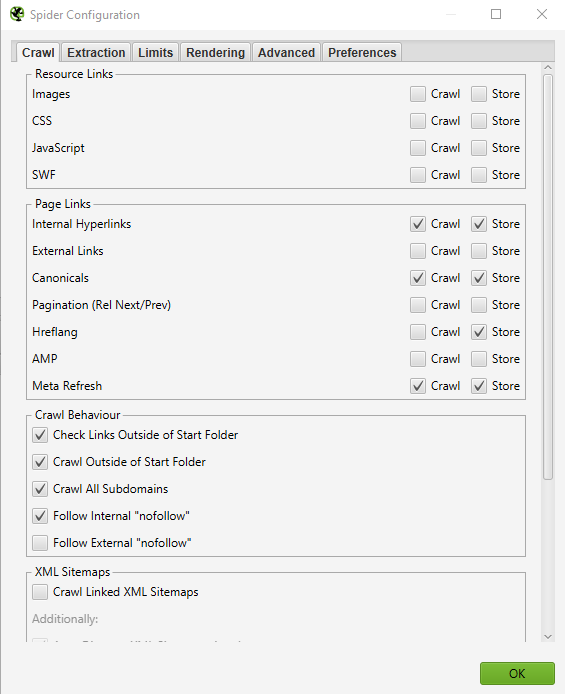

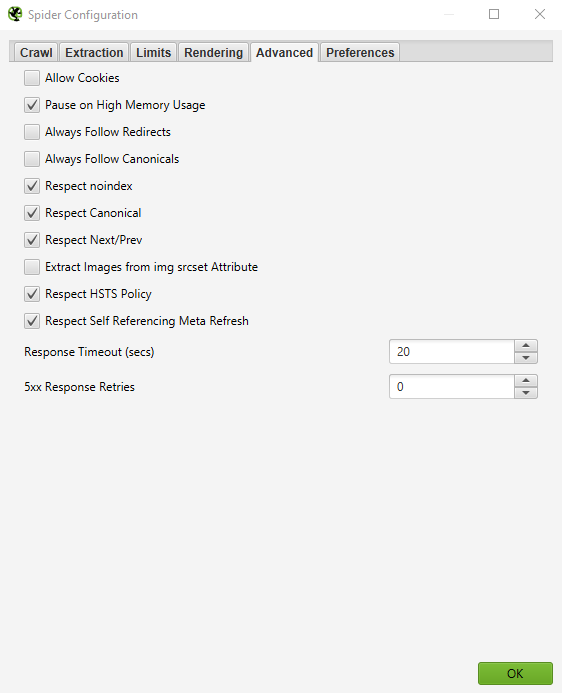

2. Solltet Ihr keine optimierte XML-Sitemap haben (Google empfiehlt dies in vielen Fällen) gibt es einen alternativen Lösungsweg. Lasst Eure Seite von einem Crawling Tool wie beispielsweise Screaming Frog SEO Spider crawlen. Sollte die Anzahl indexierter URLs in der Google Search Console höher sein als die der gecrawlten URLs im Screaming Frog, ist es sehr wahrscheinlich, dass Eure Seite von einer Indexaufblähung betroffen ist. Bezieht hierbei nur gecrawlte HTML-Seiten in Eure Betrachtung ein. Wir empfehlen in jedem Fall, dass Ihr Euch den Crawl nochmals im Detail anschaut, ob wirklich alle unrelevanten Seiten ausgeschlossen sind. Alles in alles könnt Ihr aber schon ein gutes Gefühl dafür bekommen, ob es ein großes Problem gibt oder Feinjustierungen durchgeführt werden müssten. Nun gibt es viele Crawling-Voreinstellungen, die die Anzahl von gecrawlten URLs beeinflussen können. Wir empfehlen folgende Voreinstellungen, um einen Vergleich durchzuführen:

Schaut Euch nach einer Identifizierung Leistungswerte an

Habt Ihr nun Seiten ausfindig gemacht, die nicht suchrelevant sind und somit auch nicht in den Index gehören, gilt es, die Leistungswerte dieser Seiten zu überprüfen. Versichert Euch, am besten in der Google Search Console (Klicks und Impressions) und zusätzlich bei Google Analytics (Sitzungen), welchen Traffic einzelne Seiten anteilig am Gesamt-Traffic ausmachen. Fallen diese Leistungswerte nicht ins Gewicht, kommt nun der nächste Schritt, den wir in einem weiteren Wochenrückblick für Euch aufarbeiten werden: die Deindexierung von Seiten.

Fazit

Ein aufgeblähter Index kann nicht nur dazu führen, dass Nutzer sich auf Eurer Seite schlechter zurechtfinden. Das Gleiche gilt für Crawler wie beispielsweise den Google Bot. Dies kann unter anderem dazu führen, dass Seiten mit geringer Qualität indexiert werden. Die Folge ist, dass wertvolles Crawl Budget verschwendet wird, welches für jede Seite begrenzt ist. Zudem besteht die Gefahr, das relevante Seiten nicht vom Crawler berücksichtigt werden.

Google News

Larry Page nicht länger Google-Vorstand: Auch Sergey Brin tritt als Alphabet-Präsident zurück. Bereits seit 2015 liegt die eigentliche Führung des Tech-Konzerns bei dem heutigen CEO Sunar Pichai. Die beiden einstigen Gründer von Google behalten aber einen Sitz im Verwaltungsrat. Im Google Blog wurde ein gemeinsamer Abschiedsbrief von Larry Page und Sergey Brin veröffentlicht.

Google bestätigt Update für lokale Suchergebnisse: Bereits in unserem Wochenrückblick der KW 46 haben wir darüber berichtet, dass massive Ranking-Schwankungen in den lokalen Suchergebnissen beobachtet werden können. Nun hat Google Anfang der Woche über Twitter eine Stellungnahme abgegeben und das sogenannte „Nov. 2019 Local Search Update“ bestätigt. Google erklärte, dass seit dem Update das Konzept „Neural Matching“ für Local Search verwendet werde. Es handelt sich dabei um maschinelles Lernen, das Google dafür benutzt, einen besseren Zusammenhang zwischen einzelnen Wörtern und Suchanfragen herzustellen.

In early November, we began making use of neural matching as part of the process of generating local search results. Neural matching allows us to better understand how words are related to concepts, as explained more here: https://t.co/ShQm7g9CvN

— Google SearchLiaison (@searchliaison) December 2, 2019

In summary:

— Google SearchLiaison (@searchliaison) March 21, 2019

— RankBrain helps Google better relate pages to concepts

— Neural matching helps Google better relate words to searches.

And there’s nothing special searchers or webmasters need to do. These are part of our core systems designed to naturally increase understanding.

Neue übersichtlichere Benachrichtigungen in der Google Search Console: In einem Blog-Beitrag gab Google am 4. Dezember bekannt, dass die Benachrichtigungen der Google Search Console, die zuvor ausschließlich per Mail an Nutzer verschickt wurden, nun direkt in der Console eingesehen werden können. Die Nachrichten sind zudem nach Themengebieten wie beispielsweise Abdeckungen oder Performance sortiert.

Thema Deindexierung: Google macht keinen Unterschied zwischen 404- und 410-HTTP-Statuscodes: SEO-Suedwest berichtete am 5. Dezember über dieses Thema. Das SEO-Nachrichtenportal bezieht sich auf einen Tweet von John Mueller, der auf eine Nutzerfrage antwortete. Demnach spielt es für Google keine Rolle, ob Seiten aus dem Index mit einem 404- (Bedeutung: „not found“) oder 410-HTTP-Statuscode (Bedeutung: „gone“) entfernt werden.

Vermischtes

Sistrix Optimizer nutzt nun auch Google Chrome, um JavaScript zu lesen. JavaScript ist sehr beliebt, um auf Seiten beispielsweise interaktive Elemente zu implementieren. Vor ein paar Monaten hat Google bekannt gegeben, dass der Google Bot eine serverbasierte Version von Chrome zurückgreift, um JavaScript-Inhalte zu nutzen. Der Sistrix Optimizer ist nun ebenfalls auf die gleiche Technologie umgestiegen. Weitere Details könnt Ihr auf Sistrix.de nachlesen.

Tagesschau knackt 100.000 Follower-Marke bei TikTok in nur elf Tagen. Head of Social Media bei der Tagesschau Patrick Weinhold gab auf LinkedIn bekannt, dass der Tagesschau-Account auf TikTok nur elf Tage nach Erstellung des Accounts 100.000 Follower zählte. Ebenfalls erstaunlich sei die hohe durchschnittliche Wiedergabezeit der News-Videos sowie eine weibliche Nutzerschaft von fast drei Vierteln.

Die erfolgreichsten YouTube-Videos, -Kanäle und Musikvideos in Deutschland. Zum Ende des Jahres 2019 veröffentlicht der GoogleWatchBlog diverse Top 10 Rankings der deutschen YouTube-Szene. Hier findet Ihr unter anderem die erfolgreichsten deutschen Videos, Musikvideos sowie die Aufsteiger des Jahres 2019. Die vollständigen Rankings könnt Ihr hier nachlesen.

Unsere Tipps der Woche

Divide & Conquer Sparaktion im entwickler.kiosk. Im neuen entwickler.kiosk findet Ihr über 10.000 Experten-Beiträge zu top-aktuellen Themen und Trends rund um Software und Technologie. Derzeit läuft die Divide & Conquer Sparaktion, welche sich an Teams ab drei Personen richtet: Wer sich bis zum 17. Dezember 2019 mit seinem Team anmeldet, zahlt im ersten Jahr nur die Hälfte. Mit unserem Rabatt-Code KIOSK-DC-100 spart Ihr sogar noch weitere 10 %. Hier geht es zur Aktion.

3 Tricks für zuverlässige Online-Marketing-Maßnahmen. Vor ein paar Tagen ist die Konferenz Marketing Underground in Berlin zu Ende gegangen. Hier hat der Rechtsanwalt Dr. Martin Schirmbacher einen sehr interessanten Vortrag zu dem Thema Online-Marketing-Maßnahmen gehalten und diese Präsentation für die Öffentlichkeit zur Verfügung gestellt. Das wollen wir Euch natürlich nicht vorenthalten. Definitiv ein Lese-Tipp zum Wochenende. Die Präsentation findet Ihr auf Online-Marketing-Recht.de.

Google Play Store Best of 2019. So wie YouTube feiert auch der Google Play Store den besten Content des Jahres. Die Rankings reichen von „Best App“ über „Best Game“ bis zu „Top-Selling Audiobook“. In den Rankings könnt Ihr schonmal ein paar Inspirationen sammeln, mit denen Ihr die Langeweile überbrücken könnt. Hier geht es zu den Rankings.

Nikolaus-Gewinnspiel: Gasthörerschaft an der afs-Akademie. Ihr möchtet Euer SEO-Wissen vertiefen? Dann nehmt bis zum 10. Dezember an unserem Gewinnspiel teil. Zu gewinnen gibt es eine Gasthörerschaft an der afs-Akademie in Berlin zu einem Modul Eurer Wahl. Unser Gewinnspiel gibt Euch die Chance, einen neuen Berufsweg in der SEO-Welt aufzubauen. Weitere Details und wie Ihr an dem Gewinnspiel teilnehmen könnt, erfahrt Ihr hier.

Ein schönes Wochenende wünschen Euch

Janek und die Trainees.

Eine Antwort

Man lernt nie aus bei SEO. Ich hätte nicht gedacht, das der Index Einfluss auf die Bot-Suche und somit auch dem Ranking haben kann! Danke für die ganzen guten Tipps die du uns frei zur Verfügung stellst! „Thumbs up“