„Rummel, rummel, reister – wir sind die bösen Geister“ – das habe ich mir auch immer gedacht, wenn von robots.txt, robots meta tag oder dem rel-Attribut die Rede war. Dank eines schon etwas in die Jahre gekommenen Artikels auf dem SEOmoz Blog, haben nun auch diese Gespenster ihren Schrecken verloren. Aus gegebenem Anlass möchte ich mit süßen Informationen rund um das Robots Exclusion Protocol rausrücken und das Geheimnis um den X-Robots-Tag entzaubern, damit es auch in eurem Hinterstübchen aufhört zu spuken. 😉

Robots Exclusion Protocol (REP)

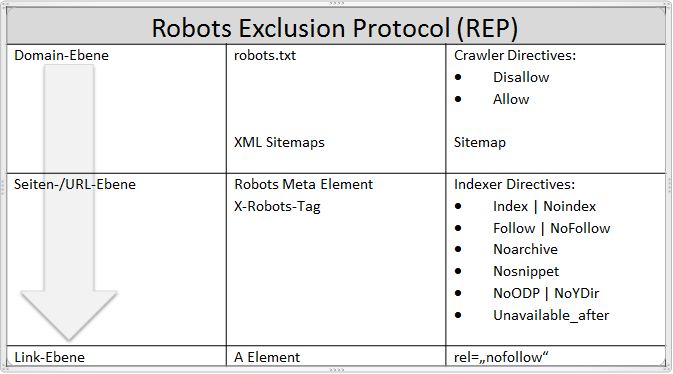

Das Robots Exclusion Protocol (REP) umfasst Normen, die das Verhalten von Webcrawlern und die Indizierung durch Suchmaschinen regulieren. Webmaster können mithilfe des REP spezifizieren, wie Suchmaschinen auf ihre Seite zugreifen – beispielsweise wenn sie gewisse Seiten von der Indexierung ausschließen wollen. Das Robots Exclusion Protocol wurde 1994 eingeführt und besteht nach Erweiterungen von 1997 und 2005 aus:

• robots.txt

• (XML) Sitemaps

• REP tags

• Mikroformaten z. B. „rel=nofollow“

robots.txt

Gemäß des Robots-Exclusion-Protokolls liest ein Crawler beim Auffinden einer Website zuerst die robots.txt, die sich im Stammverzeichnis („root“) einer Domain befindet. Diese Datei ist quasi der Pförtner für die gesamte Website und legt fest, ob und wie sie von einem Bot besucht werden darf. Die großen Suchmaschinen (Google, Yahoo!, Bing) halten sich in der Regel an diese Anweisungen.

(XML) Sitemaps

Sitemaps sind suchmaschinenlesbare Dateien, die die Seiten (URLs) einer Website einschließlich einiger Metadaten (Datum der letzten Aktualisierung, Änderungshäufigkeit, Relevanz etc.) auflisten. Sie geben dem Webmaster die Möglichkeit, Suchmaschinen zu informieren, welche URLs einer Website gecrawlt werden sollen. So kann der Crawler beispielsweise Seiten finden, die ohne den Hinweis in der Sitemap vermutlich unentdeckt geblieben wären.

Sitemaps bieten sich besonders für umfangreiche Internetauftritte an, da viele Suchmaschinen nur einer bestimmten Anzahl von Links innerhalb einer Website folgen. Bei großen Websites stellt eine Sitemap also sicher, dass die Crawler alle relevanten und wichtigen Seiten finden. Auch für Websites, die zum Teil mit JavaScript oder Adobe Flash generiert sind, ist eine Sitemap ratsam.

REP tags

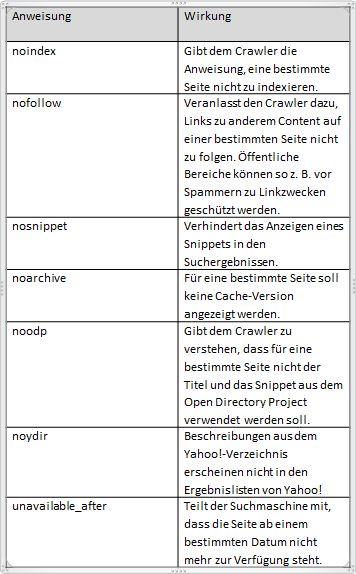

Mithilfe der REP tags – besser bekannt als Metadaten – wie u. a. noindex, nofollow und unavailable_after können dem Indexer einer Suchmaschine spezielle seitenspezifische Anweisungen gegeben werden. Wenn man z. B. möchte, dass eine Seite für den Googlebot ab einem bestimmten Datum (tt.mm.jjjj) nicht mehr erreichbar sein soll, benutzt man die REP-Anweisung unavailable_after.

Die REP-Anweisungen können entweder in den Head-Bereich einer HTML-Seite oder in den HTTP Header für Nicht-HTML-Content (Bilder und Dokumententypen wie PDFs) eingebunden werden. Dazu wird der X-Robots-Tag verwendet. Wie genau das funktioniert, könnt ihr im folgenden Abschnitt zum X-Robots-Tag nachlesen. 😀 Kommen wir der Vollständigkeit halber erst einmal zu den Mikroformaten.

Mikroformate

Eine Website besteht gemeinhin aus den Auszeichnungssprachen HTML oder XHTML. Da letztere semantisch leider unvollständig ist – es gibt mehr Bedeutungen als Auszeichnungsmöglichkeiten – bedarf es sogenannter Mikroformate, die X/HTML-Dokumente durch zusätzliche, suchmaschinenlesbare Semantik erweitern, ohne deren Inhalte zu verändern. Mikroformate sind demnach Formate zur Feinstrukturierung von Webseiten. Es gibt u. a. Auszeichnungen für Events, Visitenkarten und lizensierten Inhalt. Dabei kommen die Attribute class, rev oder – das uns SEOs nur allzu gut bekannte – rel-Attribut zum Einsatz. „rel=nofollow“ gibt Suchmaschinen die Anweisung, einen bestimmten Link auf einer Seite zu entwerten.

Aus der obenstehenden Grafik, in der noch einmal anschaulich dargestellt ist, aus welchen Komponenten das Robots Exclusion Protocol besteht, wird auch ersichtlich, dass die REP-Anweisungen für unterschiedliche Ebenen definiert sind. Dieser Hierarchie folgen auch Suchmaschinen beim Crawlen, Indexieren und Ranken einer Website.

Crawler selbst indexieren den Inhalt einer Website nicht. Sie holen sich lediglich Informationen von Webservern, mit denen sie einen Daten-Pool füttern, von dem sich anschließend Indexer nähren.

Crawler directives & indexer directives

Allein die robots.txt enthält die sogenannten crawler directives. Sie geben den Robots der Suchmaschinen Empfehlungen, welche Seiten sie crawlen sollen (“allow”) und welche nicht (“disallow”). Zusätzlich verweist die robots.txt auf die Sitemap.

Neben den crawler directives gibt es die indexer directives (das Mikroformat „rel=nofollow“, das robots meta tag sowie das X-Robots-Tag), für die das Crawlen Voraussetzung ist. Bislang gibt es keine indexer directives auf Domain-Ebene, deshalb müssen Robots eine Seite erst crawlen, um zu den darin enthaltenen indexer directives, wie beispielsweise einem mit dem rel-Attribut ausgezeichneten Link, zu gelangen.

X-Robots-Tag

Der Gebrauch des robots meta tag dürfte wohl jedem SEO geläufig sein – es wird in den Head-Bereich einer Seite eingebaut und gibt einer Suchmaschine Auskunft darüber, ob eine einzelne Seite indiziert werden soll. Das sieht dann in etwa so aus:

<!DOCTYPE html> <html><head> <meta name="robots" content="noindex, follow" /> (…) </head> <body>(…)</body> </html>

Doch was passiert, wenn in einer Datei gar kein Head-Bereich vorhanden ist? Wie schließt man PDFs und Bilder aus dem Index aus, ohne für diese Dateien einen eigenen Ordern anzulegen, der durch die robots.txt gesperrt wird?

Man benutzt das X-Robots-Tag. Jede Anweisung, die Suchmaschinen bisher über ein robots meta tag in der HTML-Seite bekommen konnten, können auch innerhalb des HTTP Headers mittels X-Robots-Tag über die .htaccess angegeben werden.

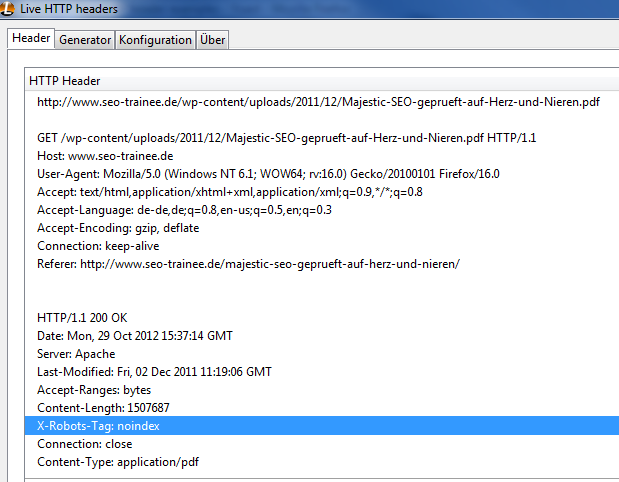

HTTP Header

Der HTTP Header ist für den Besucher, der die Seite händisch analysieren möchte, schwieriger aufzufinden als der Head-Bereich einer HTML-Seite. Während man, um den Head-Bereich zu betrachten, nur die Quelltextansicht des Browsers aufrufen muss, benötigt man für den HTTP Header externe Plugins – für Firefox z. B. das Add-on Live HTTP headers.

Beispiel zu Verwendung des X-Robots-Tag

Um alle PDF-Dateien einer Webseite von der Indexierung auszuschließen, weil sie beipielsweise Duplicate Content verursachen, kann beim Apache Webserver folgender Code-Schnipsel über die .htaccess in den HTTP Header geschrieben werden:

<ifModule mod_headers.c>

<FilesMatch "\.pdf$">

Header set X-Robots-Tag "noindex"

</FilesMatch>

Wir haben das Ganze mal anhand unserer eigenen Seite seo-trainee.de ausprobiert. Zu den Artikeln „Majestic SEO geprüft auf Herz und Nieren“ und „Einführung: WordPress SEO Plugin by Yoast“ bieten wir als besonderes Schmankerl für unsere Leser PDF-Dateien zum Download an. Diese haben bislang Duplicate Content verursacht. Durch die Verwendung des X-Robots-Tag haben wir das Problem nun gelöst.

Sollten wir in Zukunft PDFs mit einzigartigem Inhalt zur Verfügung stellen, müssen wir diese Datei gesondert behandeln und eine „index“-Anweisung in den HTTP Header schreiben.

Weitere Code-Schnipsel findet ihr in einem sehr lesenswerten Artikel von Yoast. Wenn ihr euch weitere Beispiele zur Verwendung des robots meta tag und des X-Robots-Tag anschauen möchtet, klickt hier. Für weitere Informationen zum Robots Exclusion Protocol empfehle ich euch Googles Artikelserie (Part 1, Part 2 & Part 3).

Noch Fragen? 😉 Dann scheut euch nicht, uns einen Kommentar zu hinterlassen.

Sandra und die SEO Trainees.

6 Antworten

Hallo,

ihr habt einen Fehler drin:

Header set X-Robots-Tag „noindex“

In der ersten Zeile muss es FileSMatch sein, nicht FileMatch.

Grüße

Hallo Kevin,

vielen Dank für dein aufmerksames Auge, ist ausgebessert 😉

Guten Abend,

danke für die Erläuterung des X-Robots Tags. Genau das habe ich gesucht. Ich möchte nicht das Pdf´s doppelten Content verursachen. Dankeschön.

Liebe Grüße

Ben

Danke für diesen Artikel. Habe aktuell ein Problem mit der robot.txt-Datei und weiß die Lösung nicht. Im Ergebnis wird keine meiner Seiten offensichtlich von Google erkannt. Der PR von 3 ist weg. Grrr…

Schöne Übersicht, was ich allerdings vermisse ist der Hinweis, dass die Erweiterungen der robots.txt Standards (z.B. Allow) nur von den „Drei Großen“ interpretiert werden. Man sollte also vorsichtig sein was die Benutzung davon anbelangt, je nachdem welches Ziel man erreichen will.

Da gibts leider sehrsehrsehr viele Fehlerquellen, die man leicht übersehen kann… :/

Ach was, ich wusste gar nicht, dass es so einen „Pförtner“ gibt! Das ist ja ziemlich cool, das mal zu hören! Ich finde es gut, dass es soetwas gibt und danke, dass du dir so viel Arbeit gemacht hast, alle Infos dazu zusammenzutragen! LG =))