Im März wurde ein neues Core Update für den Google-Algorithmus eingeführt. Damit verbunden sind auch ein Spam Update und neue Richtlinien für Website-Betreiber*innen. Ziel ist es, Seiten zu reduzieren, die nur auf Klicks aus sind und keine nützlichen Inhalte mit Mehrwert für die Nutzer*innen bieten. Während das Core Update aufgrund seiner Komplexität noch nicht vollständig ausgerollt ist, wurde das Spam Update bereits am 20. März abgeschlossen.

Wir wünschen euch viel Spaß beim Lesen!

Google Core und Spam Updates

Im März wurde ein neues Core Update für den Google-Algorithmus eingeführt. Damit verbunden sind auch ein Spam Update und neue Richtlinien für Website-Betreiber*innen. Ziel ist es, Seiten zu reduzieren, die nur auf Klicks aus sind und keine nützlichen Inhalte mit Mehrwert für die Nutzer*innen bieten. Während das Core Update aufgrund seiner Komplexität noch nicht vollständig ausgerollt ist, wurde das Spam Update bereits am 20. März abgeschlossen.

#1 Core Update

Wie bereits erwähnt, legt Google seinen Fokus nun noch stärker auf Inhalte mit echtem Mehrwert. Aus diesem Grund ist Helpful Content nun Teil des Kernalgorithmus. Inhalte, die nur für ein möglichst schnelles, gutes Ranking anstatt für die Nutzer*innen gemacht sind, werden es zukünftig schwer haben. Inhaltlich irrelevante Seiten mit minderwertigen Inhalten werden ebenfalls schlechter gerankt.

Anders als früher werden nun mehrere Kernsysteme verwendet, um die wirklich nützlichen Seiten zu ermitteln. Dies macht das Update laut Google zum bisher komplexesten. Dies erklärt auch die lange Ausrollzeit. Weitere Informationen zum Verlauf des Core Updates gibt es im nächsten Monatsrückblick.

#2 Die neuen Richtlinien im Rahmen des Spam Updates

Im Rahmen des Spam Updates wird gegen folgende drei Praktiken vorgegangen:

- Expired Domain Abuse: Hierbei handelt es sich um die Praxis, abgelaufene Domain-Namen mit guter Reputation zu nutzen, um eigene minderwertige und irreführende Inhalte zu veröffentlichen. Google nennt zur Verdeutlichung ein Beispiel. In diesem wird eine Domain, die bisher von einer Seite zu medizinischen Themen betrieben wurde, aufgekauft, um darauf qualitativ schlechten Casino-Inhalt zu veröffentlichen, in der Hoffnung von den bisher guten Rankings profitieren zu können.

- Scaled Content Abuse: Bei diesem Verfahren werden viele Seiten mit minderwertigem Inhalt erstellt, um die Chance zu erhöhen, weiter oben in der Suche zu erscheinen. Oft werden diese Inhalte automatisiert mit Hilfe von KI erstellt. Aber auch von Menschen erstellte Inhalte, die z. B. Antworten auf Suchanfragen versprechen, aber keine hilfreichen Informationen liefern, fallen darunter.

- Site Reputation Abuse (Parasite SEO): Damit ist das Erstellen von Third Party Content auf einer First Party Site (meist mit höherer Autorität und Bekanntheit) gemeint. Dieser wurde nur deshalb eingerichtet, damit der besagte Content vom Erfolg der First Party Site profitieren kann. Dabei stehen die Inhalte der Third Party Page nicht unter der Kontrolle der First Party Site. Problematisch sind jedoch nicht alle Third Party Pages, sondern nur solche, die auf eine Manipulation des Rankings abzielen.

In seinem Artikel auf Search Engine Journal weist Roger Montti auch auf mögliche Änderungen der Regeln für Links hin. Er interpretiert die Aussagen in den neuen Spam-Richtlinien von Google so, dass Links für das Ranking an Bedeutung verlieren. Strengere Regelungen könnten in Zukunft auch für Inhalte gelten, die ausschließlich zum Zweck der manipulativen Verlinkung erstellt wurden. Und auch manipulative Links auf externe Seiten werden wohl noch stärker beobachtet werden. So führt Google diese nun explizit als einen vom Algorithmus beobachteten Aspekt auf.

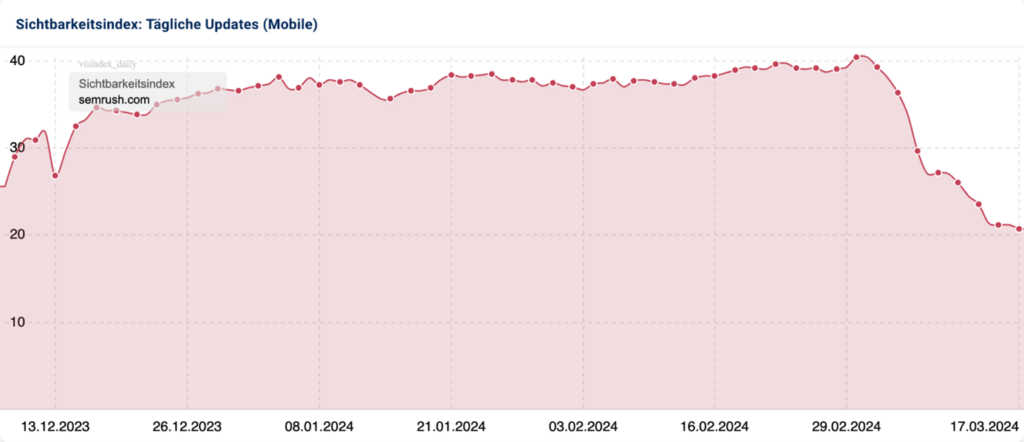

#3 Änderungen in der Sichtbarkeit

Laut SISTRIX zeigen sich die Auswirkungen von Updates auf folgende Weisen:

- Die Sichtbarkeit ändert sich plötzlich von einem Tag auf den anderen: Dies kann ein Zeichen dafür sein, dass Google sein Vertrauen in die betroffene Seite neu evaluiert und einen neuen Wert ermittelt hat.

- Die Sichtbarkeit ändert sich kontinuierlich seit Beginn des Updates: Laut SISTRIX bewertet Google die betroffene Seite bei jedem Crawling neu. Häufig verlieren Seiten, die viele Inhalte von geringer Qualität veröffentlichen.

- Verlust der Sichtbarkeit von KI-generierten Inhalten: Betroffen sind in erster Linie Inhalte, die ausschließlich zu SEO-Zwecken generiert wurden. In Zukunft wird es noch schwieriger werden, mit diesen ein gutes Ranking zu erzielen.

- De-Indexierung ganzer Domains: Diese Maßnahme wurde bisher nur im englischsprachigen Raum angewendet. Sie zeigt aber, wie ernst es Google ist, Platz für bessere Suchergebnisse zu schaffen.

#4 Welche Websites beim Core Update bisher verloren haben

Die Verlierer bieten, wie bei einer Aktualisierung im Rahmen von Helpful Content zu erwarten, keinen oder nur unzureichenden nützlichen Inhalt. Dazu gehören:

- Seiten mit irrelevanten Informationen und schlechter UX

- Seiten von Autor*innen ohne (erkennbare) Expertise auf dem entsprechenden Themengebiet

- Falsche und/oder veraltete Inhalte

- (KI-generierte) Seiten mit unoriginellen Inhalten

Es ist wichtig zu erwähnen, dass Google KI-Inhalte nicht per se ablehnt. Vielmehr werden Inhalte, die nicht hilfreich und repetitiv sind, schlechter bewertet, unabhängig davon, ob sie von einem Menschen oder einer KI verfasst wurden.

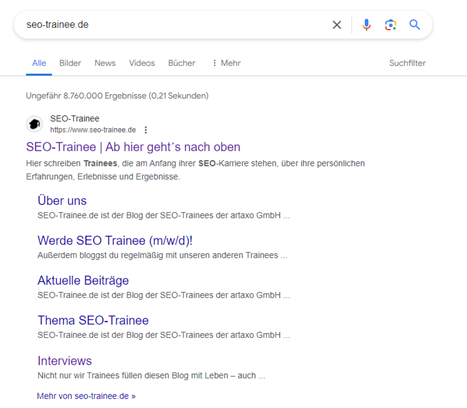

Um die Sichtbarkeit eurer Website zu schützen, ist es wichtiger denn je, eure Erfahrung, Expertise, Autorität und Vertrauenswürdigkeit gegenüber Google unter Beweis zu stellen. Das bedeutet, Inhalte zu erstellen, die den E-E-A-T-Prinzipien entsprechen. Um zu überprüfen, ob euer Content von dem Update betroffen ist, solltet ihr einen Blick auf die Entwicklung der Sichtbarkeit eurer Seite werfen. (z. B. mit Tools wie SISTRIX) Außerdem solltet ihr eure Performance-Kennzahlen in der Google Search Console überprüfen. Des Weiteren könnt ihr mittels einer Site-Abfrage testen, ob ihr noch in den Suchergebnissen vertreten seid. Dazu gebt ihr in der Google-Suche Folgendes ein: site:eurewebsite.de.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Weitere InformationenGoogle-News

#1 Wann KI-Inhalte als Low Quality Content eingestuft werden

Wie bereits im Artikel zu den Core und Spam Updates erwähnt, geht Google derzeit gegen massenhaft produzierte, qualitativ minderwertige Inhalte vor. Im Zuge dessen wurden auch die Google Quality Rater Guidelines angepasst, ein Dokument mit dem von Google angestellte Quality Rater Inhalte bewerten. Nun werden durch KI generierte Inhalte, für deren Qualität Website-Betreiber*innen nicht garantieren können, mit der niedrigsten Bewertung versehen. Die Quality Rater Guidelines sind zwar kein direkter Rankingfaktor, könnten aber in zukünftigen Updates der Ranking-Algorithmen verwendet werden. Website-Betreiber*innen wird daher empfohlen, die Qualität und sachliche Richtigkeit der eigenen KI-Inhalte stets zu überprüfen.

Weitere zu vermeidende Praktiken erläutert Niklas Lewanczik auf onlinemarketing.de. Zum einen sollten KI-generierte Inhalte immer an den entsprechenden Stellen gekennzeichnet werden. Darauf wies Barry Schwartz mit Blick auf den neuen Eintrag in den Google Quality Rater Guidelines hin. Es reiche nicht aus, auf einer Seite nur allgemein darauf hinzuweisen, dass KI zur Erstellung verwendet wurde. Eine Missachtung dieses Hinweises führe zu einem schlechten Ranking (lowest E-E-A-T). Eine weitere Änderung im Rahmen der neuen Spam-Richtlinien ist das verstärkte Vorgehen gegen KI Content Stuffing. Konkret handelt es sich dabei um den im vorherigen Thema erwähnten Scaled Content Abuse mittels KI.

#2 Reduzierung der Sitelinks

Es gibt deutliche Anzeichen dafür, dass in letzter Zeit weniger Sitelinks in den Suchergebnissen von Google angezeigt werden. Diese automatisch generierten Links sollen den Nutzer*innen die Navigation erleichtern, indem sie weitere relevante Ergebnisse anzeigen. Bisher gibt es keine Informationen darüber, warum dies geschieht. Christian Kunz vermutet in seinem Artikel auf seo-suedwest.de, dass es sich um einen Fehler, einen Test oder eine gezielte Änderung handeln könnte.

Online Marketing News

#1 Bing Webmaster Tools besitzt nun neue IndexNow & Top SEO Reports

Bing hat seine Webmaster Tools verbessert, indem sie den IndexNow Insights Report erweitert und den Top SEO Insights Report hinzugefügt haben. Über den IndexNow Insights Report können Nutzer*innen herausfinden, wie sie die Sichtbarkeit und das Ranking ihrer Seite verbessern können. Darin enthalten sind unter anderem folgende Informationen:

- Status der in IndexNow eingereichten URLs

- Quelle der eingereichten URLs (bspw.: WordPress, Cloudflare, händisch)

- Indexierstatus und erstes Indexierdatum der letzten 1000 URLs, die eingereicht wurden

- Informationen über ein verspätetes Einreichen der letzten 1000 URLs, die eingereicht wurden

- Problemmeldungen von URLs, die über den Crawler gefunden wurden

- Berichte über die Anzahl von eingereichten, gecrawlten und indexierten URLs

- Individuelle Fehlermeldungen (bspw.: nicht gecrawlte oder indexierte Links, Deadlinks, Robots.txt disallowed)

- Detailreports zu nicht indexierten URLs sowie Anleitungen, um die URLs in den Index zu bekommen

- Export-Files über Indexierungs-Trends

Neben den IndexNow Insights Report gibt es den neuen Top SEO Insights Report, welcher Nutzer*innen personalisierte Tipps und Lösungsvorschläge zu SEO-spezifischen Problemen einer Seite gibt. So können Nutzer*innen einfach herausfinden, wie sie ihre Seite verbessern können. Unter anderem zeigt der Bericht Folgendes:

- Qualitätsprobleme mit dem Inhalt

- Verbesserungspotentiale zur Indexierung

#2 Amazons Umsatzbringer: monatlicher SISTRIX Report

Seit Februar 2024 veröffentlicht SISTRIX einen monatlichen Report zu den interessantesten Amazon Trends. Unter anderem sind dort die Top-Kategorien, die meistverkauften Produkte, die Top-Brands u.v.m. zu finden. Zudem wird ein Vergleich zum Vormonat gezogen.

Als Beispiel gibt es hier die Veränderungen in der Kategorie „Garten“ im März 2024:

Im März verzeichnete die Kategorie „Küche, Haushalt & Wohnen“ den höchsten Mindestumsatz, jedoch verzeichnete die Kategorie „Garten“ den größten Zuwachs, was den Mindestumsatz angeht. Besonders Blumen- und Pflanzensamen, Gartengeräte und Düngemittel waren beliebt. Der Mindestumsatz der Unterkategorie „Rasenmäher & -traktoren“ stieg im Vergleich zum Februar um 450 %. Das Einzelprodukt mit dem größten Zuwachs an Mindestumsatz war eine Gartenschere von Gardena, von 2063 Verkäufen im Februar auf 7877 im März. Dieser Boom spiegelt sich auch in den Top-10-Marken nach Umsatz wider, zu denen Werkzeughersteller wie Einhell und Makita gehören, die unter anderem Sägen, Schrauber und Rasenmäher verkaufen.

Meta News

#1 Kleine Modellversionen von Llama 3

Im letzten Sommer veröffentlichte Meta sein eigenes Large Language Model (LLM), Llama 2. Da sich die KI-Branche in einer rasanten Geschwindigkeit ändert und verbessert, arbeitet Meta fortlaufend an Llama 3. Das Modell verspricht, leistungsfähiger als die Konkurrenzprodukte zu sein. Beispielsweise soll es in der Lage sein, abstrakte Fragestellungen wie Metaphern oder Sprichwörter zu verstehen.

Obwohl der offizielle Start von Llama 3 für den Sommer geplant ist, sollen bereits Mitte April erste kleine Modellversionen des LLMs veröffentlicht werden.

#2 Neues Threads Feature: Swipen

Nutzer*innen können dem Threads-Algorithmus nun zeigen, welcher Inhalt für sie relevant ist. Ein Swipen nach rechts bedeutet, dass ihnen der Post gefällt. Umgekehrt gibt ein Swipen nach links dem Post eine negative Bewertung. Es ist bisher unklar, ob und wie sich der Swipe-Algorithmus vom Like-Algorithmus unterscheidet.

#3 Neues Instagram Feature: Spins

Instagram ermöglicht es nun ähnlich wie TikToks „Duet“-Funktion, Reels von anderen Nutzer*innen zu übernehmen und anzupassen. Besonders die Original-Poster*innen profitieren von diesem Feature. Denn jede Anpassung am eigenen Reel durch eine andere Person sorgt dafür, dass auch deren Zielgruppe darauf aufmerksam wird. Das erhöht die eigene Reichweite. Aktuell befinden sich diese Anpassungen noch in der Testphase, weshalb noch nicht alle User*innen das neue Feature nutzen können.

Quick-Tipp: Wer seinem Reel auf Instagram einen Ad Push geben möchte, kann nun Musik aus Metas Bibliothek verwenden. So wird sichergestellt, dass keine lizensierte Musik im kommerziellen Kontext verwendet wird.

Tipps des Monats

#1 Shoppable Videos

Shoppable Videos sind Clips, die es ermöglichen, dass Nutzer*innen ein Produkt direkt aus dem Video heraus kaufen. Das funktioniert für Posts, Video-Ads und Livestreams.

Durch die Möglichkeit, Produkte direkt im Video zu kaufen, wird der Verkaufszyklus verkürzt. Nutzer*innen können das Produkt also sofort kaufen, wenn sie es sehen. Der kurze Nutzerweg steigert zusätzlich die Wahrscheinlichkeit zur Conversion.

Shoppable Videos können auf Plattformen wie YouTube, Instagram, Pinterest und TikTok verwendet werden.

Wichtig zu beachten ist, dass

- der Produktfeed vollständig ist,

- der Inhalt unterhaltsam und informativ ist,

- die Videos hochwertig sind und auch im Hochformat funktionieren,

- die wichtigsten Informationen am Anfang genannt werden,

- die CTAs klar und verständlich sind und

- die User*innen wissen, dass sie mit dem Video interagieren können.

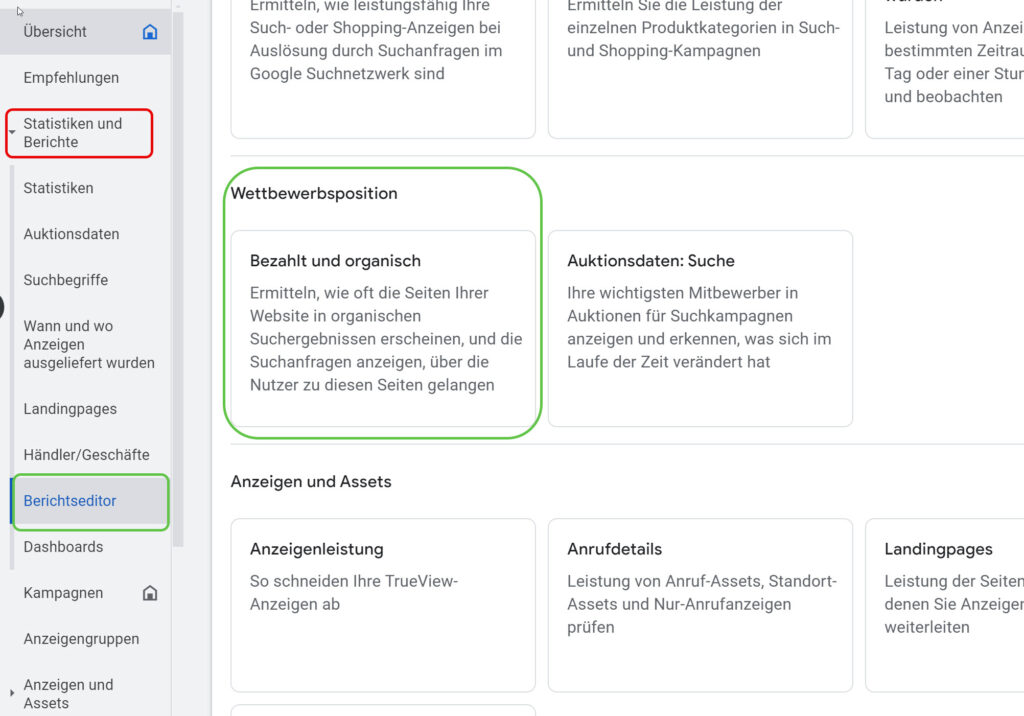

#2 Google Ads: „Bezahlte und organische Suche“ für besseres SEA und SEO

Der Bericht „Bezahlte und organische Suche“ hilft zu verstehen, wie organische und bezahlte Anzeigen im Verhältnis zueinander stehen. Der Bericht ist in Google Ads verfügbar, nutzt aber auch Daten aus der Google Search Console zu, weshalb es wichtig ist, beide Konten zu verknüpfen. Beispielsweise kann der Bericht dazu verwendet werden, neue Keywords zu finden, oder herauszufinden, für welche Suchanfragen eine Ads Kampagne besonders sinnvoll ist.

Content und KI

#1 Wie man sich mit „Deep Content“ gegen KI-generierten Content durchsetzen kann

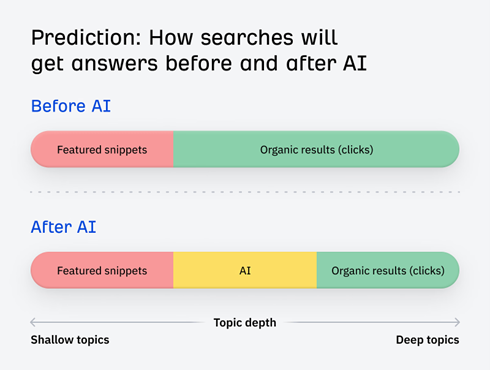

Joshua Hardwick hat erkannt, dass KI-generierter Content nun ein fester Bestandteil des Webs ist. Sich gegen die künstliche Intelligenz durchsetzen zu müssen, macht einigen SEOs Angst. Jedoch ist Joshua Hardwick fest davon überzeugt, dass künstliche Intelligenz SEOs nicht ablösen wird. Stattdessen wird sich nur die Art und Weise ändern, wie mit Content umgegangen wird. Bis vor kurzem konnten noch oberflächliche Themen ranken, beispielsweise „Wie installiere ich macOS neu?“. Diese Art von Fragestellungen hat einfache Lösungen, die von der KI problemlos wiedergegeben werden können.

Anders ist es bei tiefergehenden, individuellen und abstrakten Fragestellungen. In diesen Fällen kann die KI nur angeben, was gemacht werden könnte, aber nicht, wie und mit welchen Schritten eine Person zu dieser Lösung kommt. Tiefgehende Fragen benötigen tiefgehende Antworten, die nur Expert*innen geben können.

Tiefgreifende Fragestellungen sind solche, die nicht schnell beantwortet werden können. Daher sollten Keywords, die Featured Snippets besitzen, in solchen Fällen eher vermieden werden. Auch Antworten von ChatGPT und Gemini können evaluiert werden. Ist die Antwort unzureichend, handelt es sich um eine tiefgreifende Frage. Zudem haben detaillierte Lösungen zu komplexen Problemen den Vorteil, dass sie leichter natürliche Backlinks erhalten können.

#2 KI zur Content-Recherche

Mert Mengü beschreibt in seinem Artikel, wie KI für das Content Marketing genutzt werden kann. Schritt für Schritt führt er die Leser*innen durch den Recherche-Prozess, angefangen bei der Auswahl der geeigneten Tools über das richtige Anregen bis hin zur Bewertung des KI-generierten Inhalts.

A/B-Tests

#1 Warum A/B-Tests für SEO besonders wichtig sind

Durch die kontinuierliche Weiterentwicklung und Veränderung der Suchalgorithmen ist es besonders wichtig zu erfahren, ob eine SEO-Strategie tatsächlich funktioniert. Das Testen einer Strategie kann dabei helfen, potenzielle Verluste zu minimieren. In einer typischen SEO-Strategie werden Änderungen basierend auf den Verbesserungsvorschlägen des SEO-Experten auf der Live-Site implementiert, und anschließend werden die Auswirkungen dieser Änderungen beobachtet.

Beim Testen wird zunächst eine Änderungshypothese erstellt, die nur einer Testgruppe ausgespielt wird. Mit den daraus gewonnenen Daten kann bewertet werden, ob die Änderung tatsächlich auf der Live-Site umgesetzt werden sollte. Im Gegensatz zu UX/CRO-Tests werden bei SEO-A/B-Tests mehrere Seiten getestet.

Zudem liefern A/B-Tests direkte Vergleichszahlen, was es möglich macht, Kunden oder Stakeholdern zu zeigen, welche Auswirkungen eine bestimmte Strategie wirklich hat. Eingehende Beispiele für solch SEO-A/B-Tests sind im Artikel von Stephanie Wallace zu finden.

#2 A/B-Tests und SEO ohne Probleme kombinieren

A/B-Tests, insbesondere CRO- und UX-A/B-Tests, haben eine komplexe Beziehung. Beide Maßnahmen zielen darauf ab, positive Veränderungen auf einer Website herbeizuführen. Da A/B-Tests kurzfristige und schnelle Ergebnisse liefern, während SEO längerfristige und langsame Änderungen bewirkt, besteht die Möglichkeit, dass A/B-Tests die SEO behindern könnten. Olya Ianovskaia gibt in ihrem Artikel an, worauf zu achten ist und wie A/B-Tests durchgeführt werden können, ohne die Rankings zu beeinträchtigen.

#3 10 erfolgreiche A/B-Tests

Craig Bradford stellt in seinem Artikel 10 Beispiele für SEO-A/B-Tests vor, die bei anderen Websites Erfolge erzielten. Hierbei ist aber auch wichtig zu erwähnen, dass nicht jeder A/B-Test für jeden die gleichen Ergebnisse erzielt.

Die 10 Tests, die Craig Bradford vorstellt, sind:

- Position der Brand im Title-Tag

- Dynamische Preise im Title-Tag

- Das benötigte Maß an Einzigartigkeit von Content

- Angabe der Neuartigkeit/Aktualität des Contents im Title

- Kürzung von Title Tags

- Informationen nicht mehr innerhalb von Tabs zeigen

- Entfernen des Produktkarussells

- Umformulierung der H2-Überschriften als Frage

- Hinzufügen von „Beste“ in den Title-Tags

- Hinzufügen von KI-Content

Ein schönes Wochenende wünschen euch

Désirée und Laura