In unserem Rückblick für den Monat September berichten wir unter anderem über die sogenannten Bubble Links im Featured Snippet, geben ein Update zum Thema Title Tags in den SERPs sowie einen Überblick über die Neuerungen bei Screaming Frog. Viel Spaß beim Durchstöbern der News.

Google zeigt Featured Snippet Bubble Links an

Es macht den Anschein, als teste Google erneut die Einbettung von Links in Featured Snippets. Aufgetaucht sind die neuen Fälle in US-Suchergebnissen. Die neue Funktion war bereits im November 2020 und im vergangenen Januar aufgefallen.

Bei den Featured Snippet Bubble Links handelt es sich um Datenelemente von einer anderen Website, die die Website im Featured Snippet überlagert. Das entsprechende Element ist gepunktet unterstrichen und fährt man mit dem Mauszeiger darüber, erscheint ein kleines, übergelagertes Fenster mit Extrainformationen.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Weitere InformationenDie weiterführenden Informationen kommen entweder von Wikipedia oder verweisen auf interne Seiten. Google arbeitet nun seit knapp einem Jahr an diesem Feature. Die Bubble Links befinden sich dabei noch immer in der Anfangsphase in den USA und werden sich vermutlich in nächster Zeit noch weiter wandeln.

Warum die Funktion Bubble Links heißt? Haben wir uns auch gefragt. Antwort: Der Name rührt daher, dass Google die eingebetteten Links im HTML-Code als data bubble link anzeigt. Zudem sieht das Fenster ein wenig aus wie eine Sprechblase.

Und warum ist das relevant für uns?

Vorweg können wir allen, die jetzt große Bedenken äußern, zunächst etwas den Wind aus den Segeln nehmen. In dieser Phase sollten wir SEOs uns erst einmal keine allzu großen Sorgen machen. Die Bubble Links könnten sich als nützliches Feature erweisen. Hier wird es interessant, ob und wie man Bubble Links beeinflussen kann.

Bedenken beziehen sich meist auf den Fakt, dass Konkurrenz im Snippet übergelagert dargestellt wird und dadurch potenzielle Sucher*innen verloren gehen könnten. Aktuell werden jedoch keine fremden Seiten angezeigt – abseits von Wikipedia. Jedoch betrachtet wohl kaum jemand Wikipedia in unserer Online-Welt als direkte Konkurrenz.

Sobald dieses Feature international (also auch in Deutschland) ausgerollt wird, könnte es für die eigene Website interessant sein, die Google Search Console im Auge zu behalten. Denn diese Links könnten für einige Seiten die Impressionen beeinträchtigen.

Für Nutzer*innen können sich die Bubble Links wirklich als wertvoll erweisen. Denn man erhält so eine schnelle weiterführende Information, ohne viel Zeit zu verlieren.

Sollte es zu diesem Thema weitere News geben, halten wir euch auch weiterhin auf dem Laufenden. Lest euch hierzu auch gerne den ausführlichen Artikel von Brody Clark durch.

Google News

Bedenken zum neuen Chrome Feature Google Continuous Search

Chance oder Risiko: Mit Continuous Search Navigation, einem neuen Feature von Google Chrome, erreicht man ohne Back Button nach dem Anklicken eines Suchergebnisses auf direktem Wege weitere Suchergebnisse der Konkurrenz.

Diese Funktion wurde zunächst in der Chrome Beta der Android-Version entdeckt, wie Christian Kunz von SEO Südwest berichtete. Klickt man auf ein Google Suchergebnis, so erscheint diese Navigation in Form von Tabs unter der Adressleiste des Browsers. Die Tabs tauchen also zusammen mit der Website auf, deren Suchergebnis ausgewählt wurde.

Mithilfe dieser Tabs wird eine schnelle Weiterleitung zu verschiedenen anderen Websites ermöglicht. Bin ich also mit der aktuellen Website nicht zufrieden, kann ich ohne Aufwand auf der nächsten, in der Navigation angezeigten Website suchen. Anstelle eines längeren Schritts zurück über den Back Button, kann die Konkurrenz also nun direkt ausgewählt werden.

Interessant: Bei einem Featured Snippet erscheinen die Tabs nicht. Ebenso wenig, wenn man auf eine bezahlte Such-Anzeige klickt. Sistrix fragt sich zudem in einem Tweet, wann in den Tabs auch Werbung auftaucht.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Weitere InformationenNun also zurück zur Ausgangsfrage: Birgt die neue Funktion eher Chancen oder Risiken?

- Stichpunkt Nutzer*innen-Freundlichkeit: Klickt man als Nutzer*in auf ein Suchergebnis und ist unzufrieden, so verlässt er oder sie die Seite höchstwahrscheinlich sowieso und sucht woanders weiter – warum diesen Schritt also nicht vereinfachen? In diesem Zusammenhang wird es also nochmal wichtiger, die Suchintention der Nutzer*innen zu treffen. Denn wenn man direkt zufrieden ist, warum noch die Seite wechseln?

- Stichpunkt Verweildauer: Die Besuchsdauer einer Seite kann durch die neue Funktion sinken, da man direkte Alternativen angezeigt bekommt, die vielleicht verlockend(er) wirken. Die Frage ist aber generell, ob und inwiefern sich das Feature im großen Rahmen durchsetzt.

Title Update steigert wieder die Verwendung der Title Tags

Das Google Update im August (wir berichteten) löste bei vielen SEOs einen kurzen Schock aus. Es kam zu deutlichen Veränderungen der Titel, die in den Suchergebnissen angezeigt wurden. Anstelle von Title Tags orientierte sich vermehrt Google an Überschriften. Das sorgte für Unmut.

Die schöne Nachricht ist, Google nimmt Feedback wahr. Auf seinem Blog erklärte Google, dass aufgrund der eher negativen Rückmeldungen weitere Änderungen vorgenommen werden. Zudem sei die Verwendung des Title Tags für die Titel der Snippets von 80 Prozent auf 87 Prozent gestiegen.

Darüber hinaus sollte man auf folgende Situationen achten, wenn möglichst der eigene Titel verwendet werden soll:

- Halbleere Titel: Der Titel besteht aus einer Zusammenfassung vorne und dem Namen der Website hinten. Liegt keine Zusammenfassung vor, wird nur der Name der Website herangezogen und Google sucht selbst nach passenden Inhalten. Kommt zum Beispiel vor, wenn Vorlagen verwendet werden.

- Obsolete Titel: Google kann nun die Jahreszahl im Title Tag von selbst an das aktuelle Jahr anpassen.

- Unpassende Titel: Google ändert den Titel, wenn die Inhalte der Seite im Tag nicht richtig vertreten werden, z. B. Produkte genannt werden, die auf der Seite nicht vorhanden sind.

- Micro Boilerplate Titel: Bei gleichen Titeln ohne individuelle Abgrenzung in einem Bereich, kann Google jeweils passende Informationen aus den Seiten nehmen und im Titel ergänzen. Fehlt z. B. die Angabe der Reihenfolge einer Filmserie im Title Tag, so sucht Google sich die entsprechende Information und passt den Titel an.

Generell gilt hier: Investiert ein wenig Zeit und wählt euch eure Titel mit Bedacht. So ist die Chance geringer, dass Google nicht euren Title Tag verwendet, sondern sich woanders Informationen sucht.

Lest hierzu gerne auch den passenden Artikel von SEO Südwest.

Intelligente interne Verlinkung für mehr Vertrauen

In einer vergangenen Ausgabe von Googles SEO Office Hours erzählte John Mueller davon, wie interne Verlinkungen dabei helfen können, Google durch die vertrauenswürdigsten und qualitativ hochwertigsten Seiten von Websites zu leiten. So können insbesondere neue Websites das Vertrauen der Suchmaschine gewinnen und damit Google dazu bringen, immer mehr ihrer Seiten zu crawlen.

„Anfangs muss man eine Art trichterförmige Webstruktur erstellen. Im Laufe der Zeit, wenn Google immer mehr auf der Website unterwegs ist, erweitert man diese Schritt für Schritt, bis eine Art Endsituation erreicht wird, in der Google aktiv den gesamten Inhalt der Website indexiert.“

John Mueller in der SEO Office Hour vom 10. September (Übersetzung aus dem Englischen)

Wenn ihr euch das Gespräch und Muellers Erklärungen noch einmal genauer anhören wollt, könnt ihr euch die YouTube-Aufzeichnung der SEO Office Hour vom 10. September 2021 nochmal ansehen. Das Thema interne Verlinkungen wird ab ca. 18:25 angesprochen.

Google füllt beim Crawlen automatisch Formulare aus

Trifft der Googlebot auf Formulare, so kann es sein, dass Google diese Formulare ausfüllt. Dadurch kann es wiederum passieren, dass interne Suchergebnisseiten im Index landen.

Wie das funktioniert? Wenn der Googlebot also auf ein <form> Element stößt, so kann eine geringe Anzahl von Suchanfragen für das Formular herausgefiltert werden. Bei Textboxen übernimmt Google unaufgefordert Wörter der Website. Bei Checkboxen, Auswahlmenüs und Radio Buttons verwendet Google bestehende Werte aus dem HTML.

Ihr wollt nicht, dass eure internen Seiten, die auf ausgefüllten Formularen aufbauen, indexiert werden? Dann vergesst nicht, diese Seiten auf „noindex“ zu setzen.

Hier gelangt ihr zum Blogpost dazu von SEO Südwest.

Online Marketing News

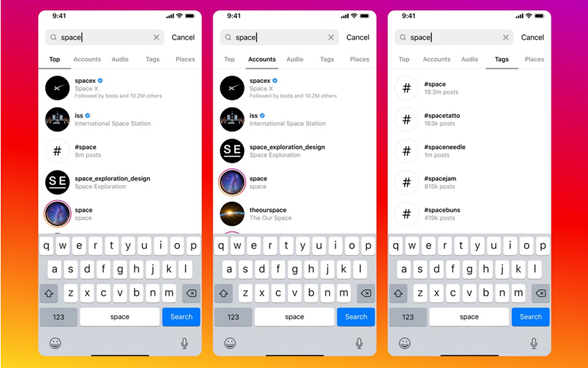

Einblicke in die Suchfunktion von Instagram

Instagram gab auf seinem hauseigenen Blog ein paar Einblicke in die interne Suche der Website. Adam Mosseri erklärte, wie Instagram die Reihenfolge von Suchergebnissen bestimmt.

Instagram zieht verschiedene Faktoren heran, wenn es darum geht, die Suchergebnisse in eine Reihenfolge zu bringen. Die wichtigsten sind:

- Der Text der Suchanfrage: Der eingegebene Text ist der wichtigste Faktor für das Ranking der Suchergebnisse.

- Die eigenen Aktivitäten: Instagram berücksichtigt die Aktivitäten des Accounts, wie z. B. die Accounts denen gefolgt wird, Posts, die aufgerufen wurden und Interaktionen mit anderen Accounts im Allgemeinen.

- Die Wichtigkeit der möglichen Suchergebnisse: Wenn es viele mögliche Suchergebnisse gibt, werden die bekanntesten zuerst angezeigt. Instagram bestimmt die Bekanntheit auf Basis von Bekanntheitssignalen wie Klicks, Likes, Shares, Follows, Hashtags und geografischen Faktoren.

Weiterhin gibt es von Instagram ein paar allgemeine Tipps, wie ihr euch selbst prominenter in der Suche platzieren könnt.

Ihr solltet dazu:

- einen passenden Nutzer*innen-Namen verwenden

- relevante Keywords und Orte in eurer Bio verwenden

- relevante Keywords und Hashtags in euren Bildunterschriften verwenden

Spam führt zu einer Abstrafung in den Suchergebnissen. Sensible Inhalte tauchen ebenfalls seltener in den Suchergebnissen von Instagram auf. Konten, Hashtags und Beiträge, die gegen die Community-Richtlinien verstoßen, werden vollständig von Instagram entfernt und tauchen somit auch nicht mehr in der Suche auf.

Wenn ihr den Text im Original nachlesen wollt, schaut euch den Instagram-Blogpost zur Funktionsweise des internen Rankingalgorithmus an.

Google Ads stellt erweiterte Textanzeigen (ETAs) ein

Google hat angekündigt, erweiterte Textanzeigen einzustellen. Ab Mitte 2022 wird es nicht mehr möglich sein, neue ETAs zu erstellen oder bestehende zu bearbeiten. Jedoch sollen auch nach diesem Zeitpunkt weiterhin bestehende ETAs zusammen mit responsiven Suchanzeigen geschaltet und es können auch Berichte über die Leistung eingesehen werden. Darüber hinaus könnt ihr eure erweiterten Textanzeigen anhalten, danach fortsetzen oder bei Bedarf entfernen.

Call Ads und Dynamic Search Ads können außerdem weiterhin erstellt und bearbeitet werden.

Den Platz von erweiterten Textanzeigen sollen Responsive Suchanzeigen (RSAs) einnehmen. Viele Werbetreibende nutzen bereits RSAs, jedoch schätzen eine Menge von ihnen die größeren Kontrollmöglichkeiten, die ETAs bieten.

Google treibt mit dieser Änderung die Automatisierung von Anzeigen weiter voran. Das künftige Auslaufen von ETAs bedeutet, dass Werbetreibende weniger direkte Kontrolle über ihre Konten haben und mit dem maschinellen Lernen und der KI von Google Ads arbeiten müssen.

Für eine umfangreichere Zusammenfassung der Thematik empfehlen wir euch diesen Artikel von Search Engine Land.

Bing macht Content Submission API für alle Nutzer*innen verfügbar

Anfang Mai dieses Jahres hatte Bing die Bing Content Submission API im Beta-Modus gestartet. Damit konnten Webmaster Bing in Echtzeit über Änderungen am Inhalt ihrer Website informieren.

Diese geschlossene Beta-Phase wurde nun beendet und die API steht nun allen offen. Alle können nun Content-Änderungen an Bing senden, wodurch die Crawl-Last des Bing Bots auf Websites reduziert und die Reichweite erhöht werden kann.

Die neue API bietet zusammen mit einer bereits vor einiger Zeit eingeführten API für die Übermittlung von URLs mehr Flexibilität, um aktualisierte Inhalte und URLs an Bing zu übermitteln. Änderungen an Websites können Bing nun unmittelbar mitgeteilt werden, sodass Suchende direkt die aktualisierten Inhalte sehen können.

Wir haben für euch an dieser Stelle den dazugehörigen Blogpost von Bing zum Nachlesen verlinkt.

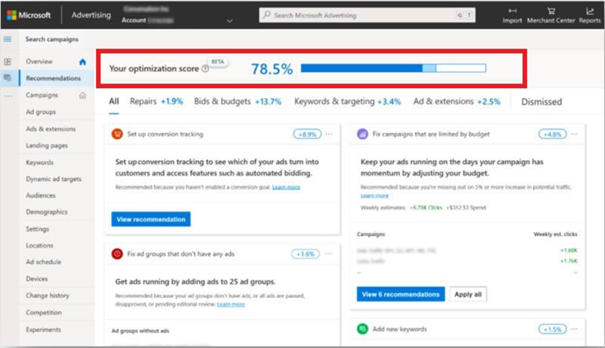

Microsoft Ads bietet nun Optimierungskennzahl an

Google Ads hat sie schon seit Längerem, Microsoft Ads zieht nun nach und führt eine eigene Optimierungskennzahl für Anzeigen ein. Die Kennzahl ist auf Konto- und Kampagnenebene verfügbar und wird für aktive Such-, Shopping- und Audience-Kampagnen angezeigt. Über die Registerkarte „Empfehlungen“ könnt ihr sie nun in Microsoft Ads einsehen. Das neue System soll Werbekund*innen dabei helfen:

- Zeit effizienter zu nutzen

- Optimierungsmaßnahmen mit höherer Wirkung zu priorisieren

- Optimierungsbemühungen im Laufe der Zeit zu verfolgen

Neben einem allgemeinen Wert zeigt Microsoft Ads außerdem eine Liste von speziell für das Konto empfohlenen Optimierungen an. Wie bereits aus Google Ads bekannt, wird euch ein prozentualer Wert angezeigt, der angibt, wie stark sich ihr Optimierungsergebnis verändert, wenn ihr eine Empfehlung annehmt oder ablehnt.

Zur Berechnung des Wertes prüft Microsoft Ads mehrere Werte einer Kampagne:

- Gebote und Budgets

- Keywords und Targeting

- Anzeigen und Erweiterungen

Der Microsoft Advertiser bietet mit dieser Komforterweiterung nun eine ähnliche Erfahrung wie Google Ads.

Genauere Infos zum Thema Optimierungskennzahl bei Bing findet ihr hier.

Neues Screaming Frog Update

Screaming Frog hat vor Kurzem Version 16.0 veröffentlicht. Wir fassen für euch im Folgenden die wichtigsten Neuerungen kurz zusammen:

Verbessertes JavaScript-Crawling

- JavaScript Tab & Filters: Die alte Registerkarte „AJAX“ wurde in „JavaScript“ umbenannt und enthält nun eine umfassende Liste von Filtern für gängige Probleme im Zusammenhang mit der Überprüfung von Websites, die clientseitiges JavaScript verwenden.

- Originalen und gerenderten HTML-Code crawlen: Der Crawler im Spider-Modus durchsucht nun sowohl das originale als auch das gerenderte HTML, um Seiten zu identifizieren, deren Inhalt oder Links nur auf der Client-Seite verfügbar sind und um andere wichtige Unterschiede zu melden.

- Identifizieren von JavaScript-Inhalten und Links: Ihr könnt nun sehen, auf welchen Seiten JavaScript-Inhalte nur in der gerenderten HTML-Post-JavaScript-Ausführung verfügbar sind. Weiterhin gibt es eine neue Spalte „Link-Ursprung“ und einen neuen Filter in der Registerkarte „Outlinks“ (und „Inlinks“). Damit könnt ihr genau feststellen, welche Links aufgrund von JavaScript nur im gerenderten HTML einer Seite enthalten sind.

- Vergleich: HTML vs. gerendertes HTML: Die Registerkarte „Aktualisiert“ zeigt an, ob Seitentitel, Beschreibungen, Überschriften, Meta-Robots oder Canonicals von JavaScript abhängen oder durch JavaScript aktualisiert wurden. Sowohl die ursprüngliche als auch die gerenderte HTML-Version können gleichzeitig angezeigt werden.

- Shadow DOM & iframes: Das Rendering wurde verbessert, um dem Verhalten von Google besser zu entsprechen. Google ist in der Lage, den Shadow DOM Content zu indexieren, und kann unter bestimmten Bedingungen iframes in ein div im gerenderten HTML einer übergeordneten Seite einbinden. Dazu ist nun auch die SEO Spider von Screamingfrog in der Lage.

Automatisierte Crawl-Berichte für Data Studio

Data Studio ist heute ein weitverbreitetes Tool für die Erstellung von SEO-Berichten. Damit Crawl-Berichtsdaten leichter in diese Berichte einbezogen werden, gibt es in der neusten Version von Screaming Frog einen neuen data-studio-freundlichen, benutzerdefinierten Crawl-Übersichtsexport, der in der Planung verfügbar ist.

Nutzer*innen können nun Crawl-Übersichtsdaten auswählen und diese als einzelne Zeile nach Google Sheets exportieren. Neue geplante Exporte werden automatisch an eine neue Zeile in demselben Blatt in einer Zeitreihe angehängt.

Die neue Crawl-Übersicht in Google Sheets kann mit Data Studio verbunden werden und für einen vollautomatischen Google-Data-Studio-Crawl-Bericht verwendet werden. Es gibt eine Screaming-Frog-Data-Studio-Crawl-Berichtsvorlage, allerdings könnt ihr auch eigene Versionen erstellen.

Erweiterte Suche und Filterung

Die eingebaute Suchfunktion wurde verbessert. Sie verwendet standardmäßig die reguläre Textsuche, ermöglicht aber auch den Wechsel zu Regex. Die neue Suchfunktion hat eine Reihe vordefinierter Filter und ermöglicht die Kombination von Regeln (und/oder).

Weiterhin zeigt die Suchleiste auch die vom Such- und Filtersystem verwendete Syntax an. Diese kann einfach eingefügt oder direkt in das Suchfeld geschrieben werden, um Suchen durchzuführen.

Zusätzliche Sprachen für das User Interface

Neben Englisch ist die Benutzeroberfläche jetzt auch in Spanisch, Deutsch, Französisch und Italienisch verfügbar. Screaming Frog erkennt beim Start die auf dem Computer verwendete Sprache und verwendet diese standardmäßig.

Screaming Frog ist ein Tool, das auch von uns intern intensiv genutzt wird, von daher beobachten wir dessen Updates mit besonderem Interesse.

Die Änderungen könnt ihr auf der Website von Screamingfrog im Original nachlesen.

Unsere Tipps des Monats

Tipps zum Verfassen von Autoren-Bios

Besonders seit dem sogenannten „Medic-Update“ haben Autor*innen-Bios für die SEO Performance an Wichtigkeit gewonnen. Um die E-A-T-Faktoren zu erfüllen, ist es wichtig, transparent zu machen, wer einen Beitrag geschrieben hat und wer diese Person ist.

Mit dem Thema hat sich Daniel Smullen genauer beschäftigt. In einem umfangreichen Beitrag auf Search Engine Journal beschreibt er, worauf bei der Gestaltung der Bios zu achten ist. Er geht dabei nicht nur auf reine SEO-Faktoren, sondern auch auf Faktoren der User Experience (UX) ein.

Wenn ihr euch genauer mit dem Thema beschäftigen möchtet, schaut gerne bei Search Engine Journal vorbei.

Optimierung von UX Elementen für Core Web Vitals

Die Core Web Vitals sind seit diesem Sommer wichtige Faktoren für das Ranking. Auf eurer Website gibt es verschiedenste Elemente, die sich auf die Core Web Vitals auswirken können. Es ist daher wichtig zu wissen, welches Element welchen Einfluss hat.

In diesem Beitrag auf Google Developers listet Google ein paar häufige UX-Elemente wie Carousels oder Infinite Scroll auf und gibt Empfehlungen, wie sich diese hinsichtlich der Core Web Vitals optimieren lassen. Die Seite ist sehr übersichtlich gestaltet und bietet mit wenig Text viel Inhalt. Definitiv einen Blick wert!

Zum Zusammenhang von Website Theme und SEO

Wie hängt das Theme einer Website mit SEO-Faktoren zusammen? Dieser Frage hat sich vergangenen Monat John Mueller auf dem Google Search Central YouTube-Kanal gewidmet.

Das Theme selbst ist an sich kein wichtiger Faktor, allerdings beeinflusst es unter anderem:

- die Darstellung der Contents

- Internal Links

- Pagespeed

- strukturierte Daten

Da diese Faktoren für den SEO-Erfolg durchaus relevant sind, wirkt sich ein Wechsel des Themes häufig auch auf das Ranking einer Website aus. Dies solltet ihr im Hinterkopf behalten.

Wenn ihr euch das mit zweieinhalb Minuten recht kurze Video zum Einfluss des Themes auf SEO-Faktoren anschauen wollt, haben wir es hier für euch parat.

Semantisches SEO für News-Seiten

Zum Schluss empfehlen wir euch noch diesen Beitrag von newsdash. Darin beschreibt der Autor sehr detailliert, wie ihr semantisches SEO für News-Seiten optimal umsetzt. Auch die Frage, was unter semantischem SEO genau zu verstehen ist, wird einleitend geklärt.

Ein schönes Wochenende wünschen euch

Gesa und die SEO-Trainees

3 Antworten

Da kann ich nur zustimmen, toller Beitrag! Zum Thema Google Continuous Search: Eine weitere Änderung von Google wird das endless scrolling in der SERP sein. Das bedeutet, dass es nicht mehrere SERP-Seiten gibt, sondern endlos nach unten gescrollt werden kann. Die Frage ist, wie sich das auf die Darstellung von Ads oder Rich Snippets auswirken wird. Ich hoffe da wird es schnellstmöglichst Neuigkeiten geben.

Die Beiträge sind sehr informativ und besitzen, im Gegensatz vieler anderer Blogs aus diesem Genre, wirklich einen Mehrwert.

Lieber Lothar,

vielen Dank für deinen lieben Kommentar. Wir freuen uns immer über Feedback! 🙂

Viele Grüße,

Gesa