Parameter in URLs können oft zu Irretationen nicht nur bei SEOs, sondern auch bei Nutzern führen. Erfahrt in unserem dieswöchigem Top-Thema, wie sich dynamische URLs zusammensetzen, was für Gefahren es in diesem Bereich gibt und wie mögliche Lösungsansätze hierzu aussehen können. Außerdem: Google kündigt Änderungen in der Traffic-Messung bei der Search Console an.

Dynamische URLs – Wieso können sie gefährlich sein und wie könnt Ihr Euch davor schützen?

URLs können schnell zum Albtraum eines jeden SEOs werden. Gerade bei endlos langen Adressen können sich leicht Fragezeichen hinsichtlich der Bedeutung einzelner Zeichen auftun. Search Engine Journal hat diesem spannenden Thema einen detaillierten Artikel gewidmet, den wir für Euch zusammenfassend darstellen möchten.

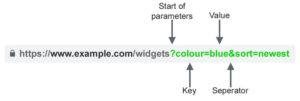

Parameter dienen dazu, dem Server die Auswahl eines Nutzers zu übermitteln. Damit kann z.B. die Zusammenstellung eines Produkts hinsichtlich der Größe oder auch Farbe gemeint sein. Um wirklich zu verstehen, was ein Parameter beinhaltet, ist es ein guter erster Schritt, eine URL in ihre einzelnen Bestandteile zu zerlegen. Dabei hilft das Schaubild unter diesem ersten Absatz. Neben der eigentlichen Adresse, die immer vor den Parameterabschnitt einer jeden URL steht, kann sie weitere Buchstaben, Zahlen und Zeichen enthalten. Diese Aneinanderreihungen werden als Parameter bezeichnet. Die eigentliche Adresse wird mit einem „?“ von den Parametern abgetrennt. Hier wird auch in unterschiedliche Bestandteile gegliedert. Der erste Abschnitt beinhaltet ein Wertepaar, dass sich aus den Aspekten „Key“ und „Value“ zusammensetzt und mit „=“ miteinander verknüpft wird. Es kann auch mehrere dieser Paare geben. In diesem Fall werden die Parameter mit einem „&“ voneinander getrennt. Generell sind die Wertepaare bei einer Suchanfrage dafür zuständig, Inhalte dynamisch aus der Datenbank des Servers auszulesen. Somit werden URLs dieser Art auch als dynamische URLs bezeichnet.

Die häufigsten Fälle, in denen dynamische URLs genutzt werden, sind die folgenden:

- Sortierungen: https://www.beispiel.de?sort=lowest-price,?order=highest-ratedor?so=newest

- Filter: https://www.beispiel.de?type=widget,colour=blueor?price-range=20-50

- Paginierungen: https://www.beispiel.de?page=2,?p=2 or viewItems=10-30

- Suche: https://www.beispiel.de?query=users-query,?q=users-queryor?search=drop-down-option

- Übersetzungen: https://www.beispiel.de?lang=fr,?language=de

- Tracking: https://www.beispiel.de?utm_medium=social,?sessionid=123or?affiliateid=abc

Was sind die Gefahren, die dynamische URLs mit sich bringen? Ein relevantes und häufig auftretendes SEO-Problem ist Duplicate Content. In diesem Zusammenhang ist es wichtig zu wissen, dass die Inhalte von statischen und dazugehörigen dynamischen URLs sich oft gar nicht oder nur marginal voneinander unterscheiden. So ist eine URL mit und ohne eingebautes Tracking beispielsweise vom Inhalt der Seite her identisch.

- Statische URL: https://www.beispiel.de/widgets

- Tracking URL: https://www.beispiel.de/widgets?sessionID=32764

Erscheinen die gleichen oder ähnlichen Inhalte nun beispielsweise in unterschiedlichen Kategorien einer Website, besteht die Gefahr darin, dass Suchmaschinen jede einzelne Parameter-URL als komplett neue Seite ansieht. Da sich diese Inhalte aber nicht oder nur sehr leicht unterscheiden, (z. B. durch unterschiedliche Farben eines Produkts) können die Seiten sehr schnell als Duplicate Content gewertet werden. Die Ranking-Signale werden somit verdünnt und Google weiß nicht mehr, welche Seite relevant für die entsprechende Suchanfrage ist.

Ein weiterer Aspekt, der berücksichtigt werden muss, ist das Crawling-Budget. Dieses Budget ist begrenzt und daher wertvoll. In dem Fall, dass nun durch den Einsatz von Parameter-URLs identische Inhalte gecrawlt werden, wird Crawling-Budget verschwendet. Als Konsequenz kann dieses Budget an anderer Stelle fehlen. Im schlimmsten Fall kann es also passieren, dass relevante Inhalte nicht gecrawlt und somit auch nicht indexiert werden.

Auf Nutzer wirken kryptische URLs weniger vertrauenswürdig. Dieser Umstand kann sich durchaus auf die Performance einer Seite auswirken. Wenn es also zur Darstellung von Links kommt, sollte eine URL auch optisch ansprechend sein. Dies kann die CTR in den SERPs, sozialen Medien, E-Mails und dergleichen in jedem Fall anheben.

Solltet Ihr nun Probleme mit dynamischen URLs haben, ist natürlich die Frage, wie mögliche Lösungsansätze aussehen können? SEJ empfiehlt folgende fünf Schritte, um den IST-Stand abbilden zu können:

- Führt einen Crawl beispielsweise mit Screaming Frog durch.

- Werft einen Blick in das URL Parameter Tool der Google Search Console.

- Zieht Eure Logfiles zur Rate, um festzustellen, ob Parameter-URLs gecrawlt werden.

- Arbeite mit einer Site-Abfrage, um herauszufinden, welche Parameter-URLs gecrawlt werden. Verwendet hierbei diese Operatoren: site:example.com inurl:key.

- Schaut Euch die Google Analytics Reports in der Rubrik „Verhalten“ an. So könnt Ihr feststellen, welche Seite von Nutzer aufgerufen wurden.

Sind diese ersten Schritte getan, geht es nun darum, die Probleme anzugehen und effizient zu lösen. Gerade bei sehr umfangreichen Seiten ist es sehr wahrscheinlich, dass viele URLs schlichtweg nicht (mehr) benötigt werden und somit entfernt werden sollten. Im Detail handelt es sich hier um Parameter-URLs, die für einen bestimmten Zeitraum mal einen Nutzen erfüllt haben, nun aber nicht länger benötigt werden (beispielsweise der Ticketbestellprozess für ein in der Vergangenheit liegendes Event). In diesem Bestellprozess erhält der Nutzer ein Cookie in Form einer Session ID, um eine bessere Identifizierung ermöglichen zu können. Diese ID hat nun keinen Nutzen mehr, befindet sich aber nach wie vor auf der Website.

Darüber hinaus sollten Keys nur in URLs eingefügt werden, wenn diese wirklich eine Funktion haben. Im Screenshot stellen key1 sowie key2 keine Funktion dar und können somit den Crawler als Folge eher verwirren.

Keys sollten nur einmal verwendet werden. Wenn jedoch mehrere Values zu ein und demselben Key relevant sind, sollte dies in einer und nicht mehreren Key-Abfragen dargestellt werden. Die Values werden dabei untereinander mit einem „-“ voneinander getrennt.

Um Crawling-Budget nicht zu verschwenden, sollte immer auf eine einheitliche Darstellungsweise von Parametern geachtet werden. Der Crawler geht systematisch vor, weshalb er mehr Zeit benötigen würde eine Seite zu interpretieren, wenn eine URL wie in dem Negativbeispiel (siehe Screenshot) dargestellt ist.

Wie können Probleme mit dynamischen URLs von vornherein verhindert werden? Hier gibt es unterschiedliche Varianten und somit auch verschiedene Szenarios wann was am besten angewendet werden sollte.

Mit dem Canonical Tag kann eine Seite als Originalseite festgelegt werden. Weitere Seiten, die den gleichen oder annähernden Inhalt haben, verweisen somit automatisch auf die kanonische Seite und es wird Duplicate Content vermieden. Generell sollte ein Canonical Tag also immer gesetzt werden, wenn bei Parameter-URLs in irgendeiner Weise die Gefahr von Duplicate Content bestehen sollte. Problem ist hierbei, dass diese Vorgehensweise trotzdem das Crawl-Budget belastet, denn auch Parameter-URLs, die mit einem Canonical-Tag versehen wurden, werden trotzdem erst einmal gecrawlt. Zudem ist der Tag nur ein Hinweis an den Crawler und keine Garantie dafür, dass der Crawler diesen Hinweis auch befolgt.

Eine weitere sinnvolle Maßnahme ist es, Parameter-Seiten mit einem Noindex-Tag von einer Indexierung auszuschließen. Die Wahrscheinlichkeit, dass sich Crawler hier auch wirklich an die Hinweise halten, ist viel höher als bei dem Canonical Tag. Grund für diese Maßnahme ist, dass in dem Index keine Ergebnisse mit gleichen oder sehr ähnlichen Inhalten dem Nutzer angezeigt werden sollten.

Eine weitere Variante gegen Duplicate Content vorzugehen ist die Robots.txt. An dieser Stelle kann man sich wirklich sicher sein, dass Crawler diese auch befolgen. Zudem wird diese Datei als erstes von einem Bot ausgelesen. Mit der Disallow-Funktion können hier bestimmte URLs für Crawler gesperrt werden. Es ist auch möglich, dass alle URLs, die Parameter enthalten, ausgeschlossen werden. Der Befehl sieht dann wie folgt aus: Disallow: /*?*.

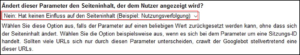

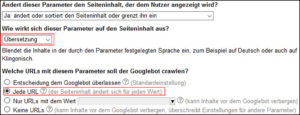

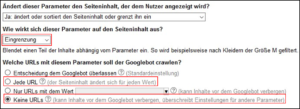

Eine weitere Möglichkeit ist es, mit dem URL Parameter Tool in der Google Search Console zu arbeiten. Allgemein gesprochen, kann hier dem Crawler dabei geholfen werden, die Hintergründe von Parameter-URLs zu verstehen. Außerdem kann dem Crawler mitgeteilt werden, wie er mit Parameter-URLs umgehen soll. Hier sind drei Handlungsempfehlungen, die SEJ bei spezifischen Parametern empfiehlt:

Google rät davon ab, dynamische URLs in statische URLs umzuwandeln. Erst vor ein paar Tagen kommentierte John Mueller auf Twitter, dass eine Überführung sehr aufwendig sei und oft zu Fehlern führe. Aus diesem Grund empfehlen wir Euch, von dieser Vorgehensweise abzusehen, da Google Parameter gut versteht und man am Ende eventuell mehr Schaden als Nutzen davonträgt.

Generell sollte darauf geachtet werden, dass nicht einfach alle Methoden zugleich angewendet werden. Beispielsweise sollte nicht ein Canonical-Tag und ein Noindex-Tag zeitgleich genutzt werden. So kann es dazu kommen, dass eine Seite mittels eines Noindex-Tags zwar nicht indexiert werden soll, aber ein Canonical-Tag an anderer Stelle auf genau diese Seite verweist. Genau solche widersprüchlichen Hinweise wirken auf den Crawler verwirrend. Aus diesem Grund sollte individuell abgewogen werden, welche der beschriebenen Methoden am besten angewendet werden kann. Selbst John Mueller kann in einem Webmaster Hangout keine klaren Handlungsempfehlung zu einem Beispiel aussprechen.

Google News

- Bereits in der letzten Woche haben wir darüber berichtet, dass Ende März die Funktionen der alten Google Search Console abgeschafft werden sollen. Nun gab Google bekannt, dass ein Feature in der neuen Search Console frisch ausgerollt wird, das es bereits in der alten Search Console auch schon gegeben hat. Es handelt sich dabei um den Bereich „Sicherheit & Manuelle Maßnahmen“. Mit Hilfe dieses Tools wird über Sicherheitsprobleme einer Domain aufgeklärt und Handlungsempfehlungen werden ausgesprochen. Es handelt sich im Detail um folgende Themenbereiche:

- Per Hacking eingefügte URLs

- Schädliche Downloads

- Ungewöhnliche Downloads

- Malware

- Irreführende Seiten

In diesem Bereich ist ebenfalls ersichtlich, wenn Google Abstrafungen gegen eine Website ausspricht. Hier muss zwischen Berichte für „Manuelle Maßnahmen“ und in Berichte für „Sicherheitsprobleme“ unterschieden werden. Wie diese Abgrenzungen genau aussehen, könnt Ihr in dem Hilfsdokument der Search Console nachlesen.

- John Mueller bestätigte in einer Reaktion auf Twitter, dass die Bewertungspunktzahl für Ladegeschwindigkeit von Websites, die von PageSpeedInsights aufgestellt wird, sich auch ohne Anpassungen auf einer Website verändern kann. Folglich sind die Bewertungen nicht das entscheidende, sondern die Empfehlungen, die von den Tools gegeben werden.

- Google kündigt an, dass Traffic und Fehlermeldungen zukünftig in der Search Console anders zugeordnet werden sollen. Aktuell wird jede einzelne URL selbst nach Impressions und Klicks in der Console bewertet. Ab März soll die festgelegte bzw. von Google auch anerkannte Canonical-URL entscheidend sein. Diese URL sammelt also von allen URLs, die unter den verweisenden Canonical-Tag stehen, gebündelt sämtliche Traffic-Werte ein. Diese Umstellung wird insbesondere für Websites mit mehreren Properties oder auch extra angelegten Mobilversionen sowie AMP-Seiten hinsichtlich der Bewertungen von Traffic neue Änderungen mit sich bringen. In Form von Filterfunktionen soll der Traffic von beispielsweise AMP-Versionen aber nach wie vor zugeordnet werden können. Generell sieht Google hier Vorteile, da es auf diese Weise zu weniger Missverständnissen von Traffic- oder auch Fehlerzuweisung kommen soll. Vor der Umstellung rät Google dazu, Zugriffsrechte auf einzelne Properties zu prüfen und ein Daten-Backup durchzuführen. Zudem kann mit dem URL Inspection Tool in der neuen Search Console nachvollzogen werden, welche URL von Google als kanonisch angesehen wird.

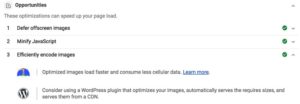

Lighthouse-Empfehlungen werden bald je nach CMS-Programm ausgegeben. Lighthouse kann in vielerlei Hinsicht ein nützliches Tool sein. Es handelt sich um ein Open-Source Programm, das über die Chrome DevTools verwendet werden kann und die Qualität von Websites im Allgemeinen verbessern soll. Zunächst wird ein Performance Check für unterschiedliche Bereiche (Bsp. PageSpeed) durchgeführt. Im Anschluss werden von Lighthouse Empfehlungen ausgesprochen, die die Leistungsfähigkeit der geprüften Website anheben können. Neu ist nun, dass diese ausgesprochenen Empfehlungen dezidiert je nach CMS (Bsp. WordPress) ausgeliefert werden. Dies ist zweifelsfrei eine sehr hilfreiche Neuerung, da die Handlungsempfehlungen zuvor eher allgemeiner Natur und somit nicht für jedes beliebige CMS pauschal anwendbar waren. Das Ganze wird aktuell entwickelt und wird als Lighthouse Platform Packs als erstes für WordPress erscheinen. Solltet Ihr Lighthouse bereits nutzen, könnt Ihr aktuell auch noch Feedback geben, wie diese Empfehlungen ausgespielt werden sollen. Es wird darüber diskutiert, ob Lighthouse nur die bereits maßgeschneiderte Empfehlung in Bezug auf Euer verwendetes CMS ausliefern soll oder aber auch zusätzlich die allgemeinen Empfehlungen angeben soll.

Vermischtes

- Bei Bing können nun bis zu 10.000 URLs täglich eingereicht werden. Ab sofort können bei Bing pro Tag 10.000 URLs eingereicht werden, um ein schnelleres Crawlen und Indexieren ermöglichen zu können. Zuvor ist dies lediglich mit 10 URLs pro Tag möglich gewesen. Voraussetzung hierbei ist das Alter einer Website von mindestens 180 Tagen. Darüber hinaus spielen weitere Faktoren eine Rolle, die in dem Statement aber nicht konkret benannt werden.

- Mit bereits bestehenden Inhalten zum Erfolg. Es muss doch nicht immer neu sein. In einem Artikel von selbststaenig-im-netz.de werden acht hilfreiche Tipps gegeben, wie man bereits bestehendem Content wieder zu neuer Strahlkraft verhelfen kann. Neben Aktualisierung von Inhalten über Verlinkungen neuer relevanter Quellen werden viele unterschiedliche Herangehensweise vorgestellt. Zudem wird an konkreten Optimierungsbeispielen die Traffic-Entwicklung veranschaulicht. Nicht jeder Inhalt ist für so eine Optimierung geeignet. Erfahrt in dem Artikel, welche Inhalte dies sein könnten.

- Welche Vorteile bringen die Bing Webmaster Tools mit sich? Oft werden die Features der neuen Google Search Console kritisch gesehen, weil sie nicht mehr so tiefgreifend sind wie noch in der alten. Wird hier ein Vergleich zu den Webmaster Tools von Bing gezogen, kann es einige Vorzüge geben. Beispiel: Bing ermöglicht es, 20.000 verlinkende URLs zu exportieren, die auf Eure Domain verweisen. Bei der Google Search Console ist dieser Export gerade einmal auf 1.000 URLs begrenzt. Weitere spannende Bing-Funktionen könnt Ihr in dem Beitrag von GrowthUp finden.

- MOZ-Update: Welche Änderungen wird es wann bei der Domain Authority geben. MOZ hat einen selbstdefinierten Scoring-Wert (1-100) ins Leben gerufen, der vorhersagen soll, wie eine Domain in den SERPs ranken wird. Mittlerweil ist die Domain Authority zu einer festen Größe geworden, wenn es darum geht, die Ranking-Stärke einer Domain zu messen. Am 05.02. wurde nun ein Update für den nächsten Monat hinsichtlich der Berechnung des Werts angekündigt. Unter anderem kann nun ein separater Spam Score in die Festlegung des Scores einbezogen werden. Was sich noch alles ändern wird, könnt Ihr dem offiziellen Statement von MOZ entnehmen. Darüber hinaus soll es am 21. Februar ein Webinar zu diesem Thema geben.

Unsere Tipps der Woche

- Das sind die 80 häufigsten Fehler bei E-Commerce-Websites. Onlinemarketing.de hat eine sehr umfangreiche Infografik über 80 häufige Fehler im E-Commerce auf Deutsch veröffentlicht. Das Original stammt von SEMrush. Untersucht wurden dabei mehr als 1.300 E-Commerce-Websites und weitere 5 Millionen Einzelwebsites. Hier ein kleiner Vorgeschmack, welche spannenden Insights auf Euch warten.

- Bosch veröffentlicht Video zur smarteren Zukunft. Zu guter Letzt wollen wir Euch auf die neueste Werbe-Auskopplung von Bosch aufmerksam machen. Hier wird auf sehr lustige Art und Weise gezeigt, wie das zukunftsorientierte Leben mit Bosch aussehen kann. Wir haben ab und zu ein wenig Fremdscham verspürt.

Sie sehen gerade einen Platzhalterinhalt von Youtube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Ein tolles und erholsames Wochenende wünschen Euch

Janek und die SEO-Trainees