Den meisten SEOs wird der Screaming Frog mit Sicherheit nicht nur ein Begriff sein. Vielen von euch ist er vermutlich sogar ein treuer Weggefährte im Tagesgeschäft, nämlich immer dann, wenn die OnPage-Analyse einer Domain ansteht. Auch in unseren Zusammenstellungen nützlicher SEO Tools hatte der kleine Spider stets einen festen Platz. Heute möchten wir euch das Tool ausführlicher vorstellen und seine wichtigsten Funktionen und Features zeigen.

Was macht der Screaming Frog SEO Spider?

Der Screaming Frog ist ein SEO Spider, folglich macht er im Prinzip genau das, was sämtliche Suchmaschinen-Bots machen: Er crawlt die Links einer Domain und sammelt dabei SEO-relevante Daten. Diese Daten lassen sich dann sortieren, filtern und Excel-freundlich exportieren. Als Desktopanwendung ist der Screaming Frog sowohl für Windows- als auch für Mac-User verfügbar. In der kostenlosen Version ist der Crawl-Umfang auf maximal 500 URLs begrenzt und auch die Einstellungsmöglichkeiten sind beschränkt. Nichtsdestotrotz sollte die kostenlose Variante für die Analyse kleinerer Projekte vollkommen ausreichend sein. Wem das doch nicht reicht, der kann für 99 Britische Pfund eine Jahreslizenz für die Vollversion erstehen.

Der Screaming Frog ist ein SEO Spider, folglich macht er im Prinzip genau das, was sämtliche Suchmaschinen-Bots machen: Er crawlt die Links einer Domain und sammelt dabei SEO-relevante Daten. Diese Daten lassen sich dann sortieren, filtern und Excel-freundlich exportieren. Als Desktopanwendung ist der Screaming Frog sowohl für Windows- als auch für Mac-User verfügbar. In der kostenlosen Version ist der Crawl-Umfang auf maximal 500 URLs begrenzt und auch die Einstellungsmöglichkeiten sind beschränkt. Nichtsdestotrotz sollte die kostenlose Variante für die Analyse kleinerer Projekte vollkommen ausreichend sein. Wem das doch nicht reicht, der kann für 99 Britische Pfund eine Jahreslizenz für die Vollversion erstehen.

Nachdem man in das vorgesehene Fenster die zu untersuchende Domain eingegeben hat und der Crawl-Durchlauf gestartet wurde, bekommt man die gesammelten Daten über das Interface präsentiert und kann die verschiedenen Elemente über Tabs auswählen. Bei kleineren Seiten kann sich die Performance des SEO Spiders durchaus sehen lassen, bei sehr großen Domains kommt der Screaming Frog jedoch teilweise ins Straucheln und hängt sich mitunter komplett auf. Dieses Problem lässt sich in der Regel ganz unkompliziert beheben, indem man eine große Site einfach ordnerweise crawlen lässt.

Einstellungen vor dem Crawlen

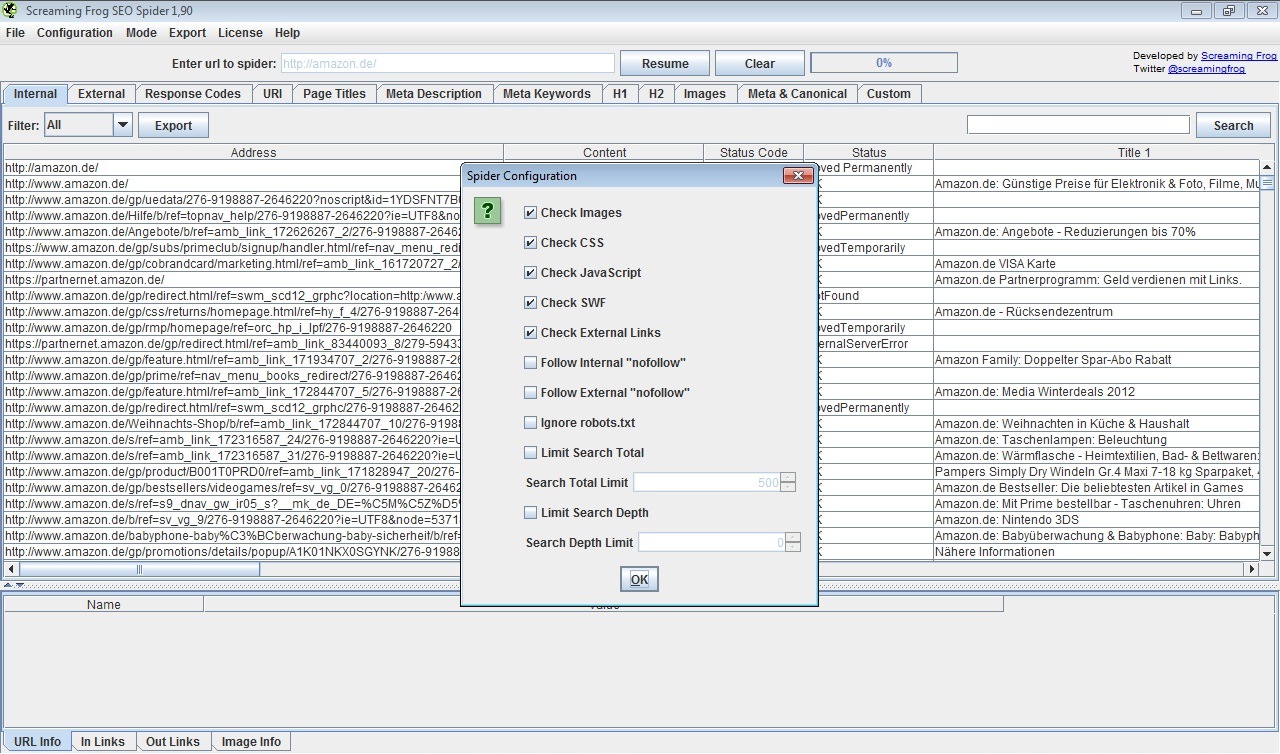

Bevor man mit dem Crawl-Vorgang beginnt, hat man unter dem Menüpunkt „Configuration“ die Möglichkeit, einige Einstellungen vorzunehmen, welche das Crawl-Verhalten des Spiders steuern. So kann man den Spider z. B. anweisen, die Robots.txt zu beachten oder eben nicht. Man kann gezielt einzelne Verzeichnisse crawlen lassen, Bilder, CSS oder JavaScript vom Crawling ausschließen oder Nofollow-Links ignorieren lassen. Des Weiteren lassen sich hier auch eigene Filter anlegen. Darüber hinaus kann man unter den Einstellungen auch den User Agent ändern. Zur Wahl stehen die gängigen Suchmaschinen-Bots sowie die Browser.

Wirklich nötig ist diese Funktion eher selten, denn standardmäßig verhält sich der Screaming Frog wie ein Suchmaschinen-Bot und hält sich entsprechend an die Robots.txt. Genau das ist ja unser Ziel, wenn wir eine Site crawlen: Wir möchten sie mit den Augen der Suchmaschinen sehen. Den User Agent zu ändern kann aber sinnvoll sein, um zu überprüfen, ob Webseiten Suchmaschinen-Bots und Besucher gleich behandeln und identische Inhalte aussteuern oder eben nicht. Man könnte auf diese Weise auch feststellen, ob durch die Robots.txt gezielt Inhalte vor bestimmten Bots verborgen werden. Dies könnte man aber ebenso gut mit einem Blick in die Robots.txt.

Die wichtigsten Funktionen und Features

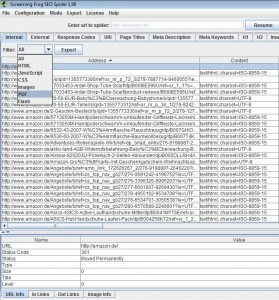

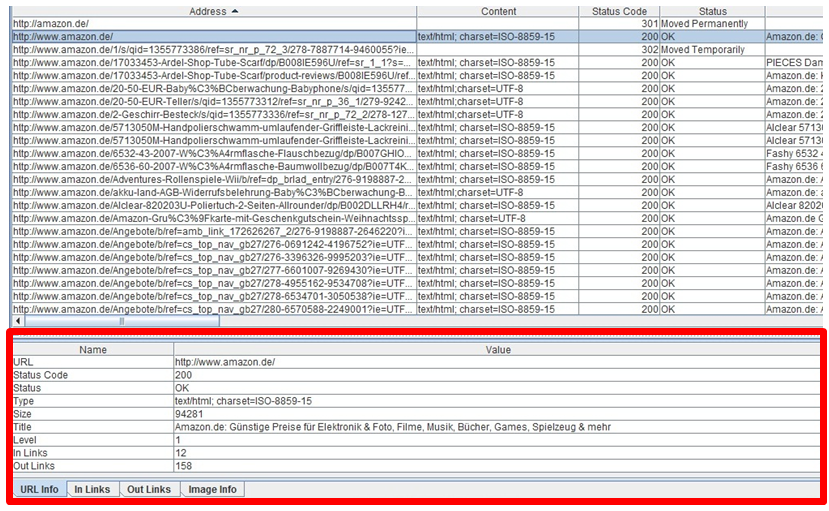

Zu Veranschaulichungszwecken haben wir hier etwa 1500 URLs der Domain amazon.de gecrawlt. Das Interface des Screaming Frog ist intuitiv und selbsterklärend. Nach Spalten sortiert werden hier alle relevanten Informationen angezeigt. Die erste Spalte zeigt die Adresse also die jeweilige URL an. Die zweite Spalte „Content“ unterscheidet zwischen unterschiedlichen Formaten, z. B. HTML, Bilder, PDFs, CSS oder JavaScript. Hier kann man gezielt nach Formaten filtern und damit z. B explizit alle PDF-Daten analysieren.

Zu Veranschaulichungszwecken haben wir hier etwa 1500 URLs der Domain amazon.de gecrawlt. Das Interface des Screaming Frog ist intuitiv und selbsterklärend. Nach Spalten sortiert werden hier alle relevanten Informationen angezeigt. Die erste Spalte zeigt die Adresse also die jeweilige URL an. Die zweite Spalte „Content“ unterscheidet zwischen unterschiedlichen Formaten, z. B. HTML, Bilder, PDFs, CSS oder JavaScript. Hier kann man gezielt nach Formaten filtern und damit z. B explizit alle PDF-Daten analysieren.

Wenn ihr den Screaming Frog verwendet, werdet ihr feststellen, dass sich diverse Informationen an unterschiedlichen Positionen wiederfinden, was jedoch nicht störend auffällt und meist durchdacht wirkt. Klickt man eine beliebige URL an, so sieht man unterhalb der Liste eine Infobox, welche relevante Informationen zu der URL bereithält. So sieht man hier den Statuscode der URL, den Typ des Contents, die Größe, die Ordnertiefe (Level) sowie die Anzahl eingehender und ausgehender Links. Neben der URL-Info hat man einige weitere Reiter. Unter diesen kann man sich beispielsweise alle eingehenden und ausgehenden Links der entsprechenden URL anzeigen lassen.

In der nächsten Spalte bekommt man den Statuscode angezeigt. Durch die vordefinierten Filter lassen mit einem Klick z. B. alle URLs mit einem 4xx-Statuscodes anzeigen. Da es sich bei 4xx-Codes in den meisten Fällen um 404er handelt und man solche Seiten aus SEO-Sicht, aber auch aus Usability-Gründen möglichst vermeiden möchte, hat man hier auf einen Blick potentielle Baustellen aufgedeckt, die man sich genauer anschauen sollte. Geht man jetzt wieder zu der URL-Infobox unter der Liste, sieht man, von welchen Seiten die 404er verlinkt werden. Nach demselben Schema lassen sich auch die 3xx-Statuscodes behandeln. Hier hat man schnell eine Übersicht über vorhandene 302- oder 301-Statuscodes und kann entsprechend handeln.

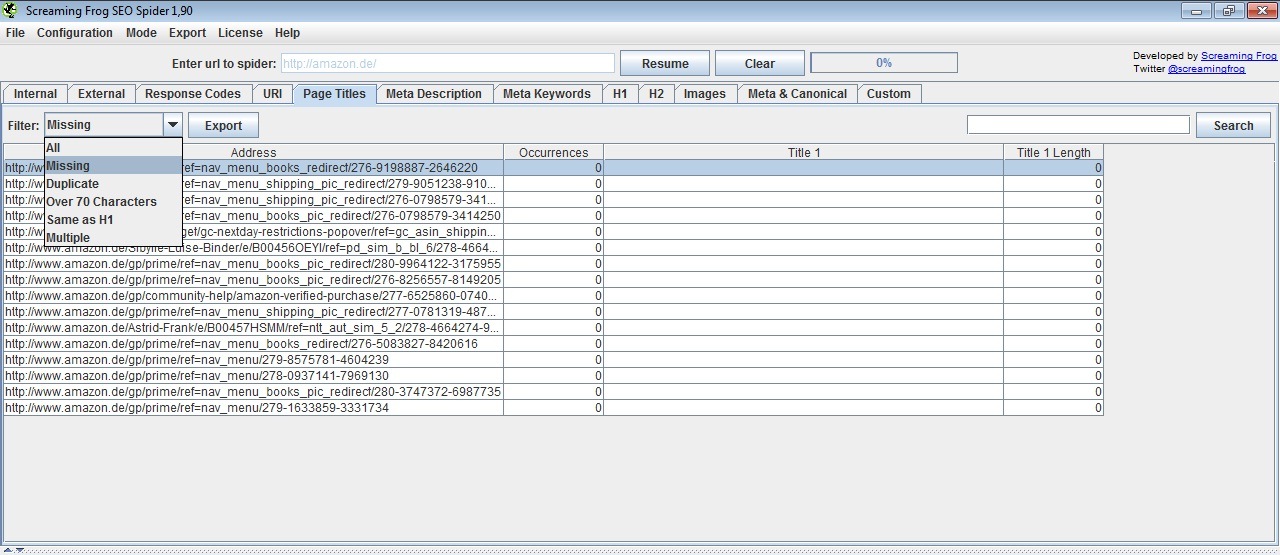

Die nächsten Spalten zeigen mit Title und Description sehr wichtige Elemente. Hier sieht man zum einen die Inhalte dieser Elemente, zum anderen hat man bequemerweise direkt die jeweilige Anzahl der verwendeten Zeichen, diese interessieren uns ja für die Darstellung in den SERPs. Mit Hilfe der vordefinierten Filter lassen sich auch hier sehr schnell Fehler aufdecken. URLs mit fehlenden, identischen oder aber zu langen Titles und Descriptions lassen sich mit wenigen Klicks identifizieren.

Als weitere relevante Keyword-Träger werden auch die H1- und H2-Tags aufgeführt. Ähnlich wie bei den Titles und den Descriptions lässt sich auch bei den Überschriften überprüfen, ob überhaupt welche vorhanden sind, ob identische verwendet werden oder ob die verwendeten Überschriften zu lang sind.

Auch Bilder kommen bei dem Report des Screaming Frog nicht zu kurz. Alle SEO-relevanten Informationen wie Dateigröße, Dateiname sowie Inhalt des Alt-Tags werden hier aufgeschlüsselt und URLs können danach gefiltert werden, ob ebendiese Informationen fehlen oder zu groß bzw. zu lang sind.

Zuletzt erhält man auch Auskunft über die Meta-Auszeichnungen der URLs. Hier können wir in erster Linie einsehen, ob URLs eine besondere Auszeichnung in dem Meta Robots Tag haben, wie z. B. „noindex, nofollow“. Seiten, die man nicht indexiert haben möchte, sollten durchaus mit dem Noindex-Tag versehen werden, jedoch sollte man auch nicht indexierte Seiten stets mit dem Follow-Tag auszeichnen, damit der Linkfluss nicht behindert wird. Des Weiteren können wir hier überprüfen, ob das Canonical-Tag immer sinnvoll und zielführend gesetzt worden ist oder ob es nicht doch vielleicht irgendwo fehlt, wo es sinnvoll wäre.

Als wäre all das noch nicht genug, bekommt man mit einem Rechtsklick auf eine URL zusätzliche nützliche Funktionen. So kann man unter anderem die URL direkt im Browser öffnen, die Indexierung der URL überprüfen, die Cache-Version anzeigen lassen, sich die URL im Archiv (Wayback Machine) ansehen oder die Robots.txt aufrufen.

Fazit

Der Screaming Frog SEO Spider ist ein wirklich tolles, nützliches und sehr umfangreiches SEO Tool, mit dem sich eine Domain schnell und übersichtlich durchleuchten lässt. Anhand der Ordnertiefe lässt sich die Struktur einer Website einsehen. Die Auflistung der Statuscodes lässt schnell erkennen, wie gesund und sauber die Domain ist. Die Anzahl interner Links verrät, ob auch wirklich die relevanten Inhalte durch die interne Verlinkung gefördert werden. Anchor-Texte der internen Links, Titles, Descriptions, Überschriften sowie Dateinamen und die Alt-Tags zeigen, ob die Inhalte auch auf relevante Keywords optimiert sind. Alle Daten lassen sich bequem in Excel exportieren, was eine individuelle Auswertung und grafische Darstellung ermöglicht.

Solltet ihr nun auch auf den Geschmack gekommen sein, dann probiert das Tool doch mal aus, es kostet euch schließlich nichts.

Wir wünschen euch spannende SEO-Analysen

Andreas und die SEO Trainees

5 Antworten

Ich bin heute auf diesen Beitrag gestoßen und erst einmal Kompliment für diesen guten Beitrag.

Ich selber setze die kostenlose Variante ein, da sich für mich derzeit die Kostenpflichtige noch nicht rechnet.

Aber alleine der Einsatz der kostenlosen Variante hilft mir schon dabei, diverse kleine und größere Probleme auf meinen Webseiten zu erkennen und wenn es grundsätzliche Einstellungen es sind, die Fehler verursachen.

Also aus meiner Sicht ein Tool welches wirklich zu empfehlen ist.

Danke für den interessanten Bericht

Lässt sich bei Screaming Frog eigentlich auch der Useragent einstellen? Bei Xenu kommt man da ja nicht weiter und wird auf verschiedenen Webseiten geblockt.