Fachartikel, der Zweite. Nachdem ich mich von meinem ersten Fachartikel so weit erholt habe, steht auch schon der zweite an. Und ich freue mich auf ein geradezu sagenumwobenes Thema. Ich möchte gerne mit euch in die unergründlichen Geheimnisse des Invisible Webs eintauchen und mir einmal anschauen: Was ist das genau?

Was ist das Invisible Web?

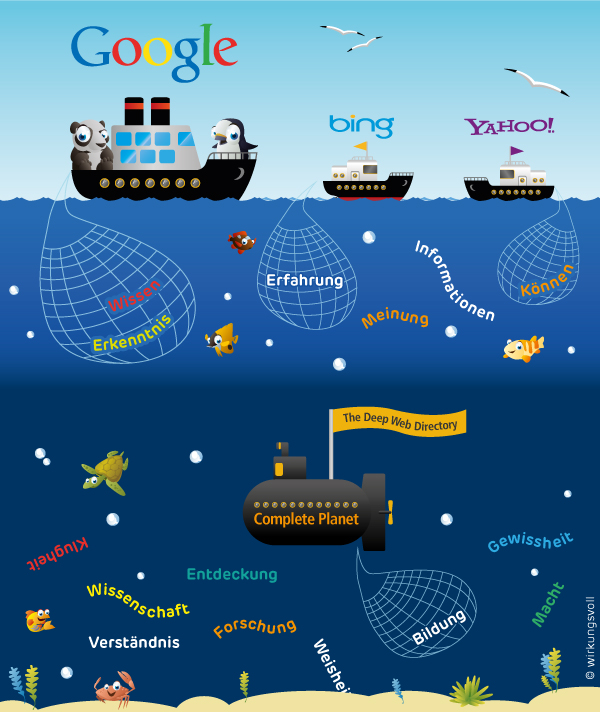

Es gibt schätzungsweise 100 bis 200 Milliarden frei zugängliche Internetseiten. Google hat davon groben Schätzungen zufolge 30 bis 100 Milliarden Internetseiten indexiert. Alle von den Suchmaschinen indizierten Seiten bilden das Visible Web, auch Sichtbares Web oder Surface Web genannt. Alle anderen Seiten – und dies ist ein nicht unerheblicher Teil – werden aus verschiedenen Gründen nicht indexiert beziehungsweise dem Nutzer nicht angezeigt. Die Angaben über die Größe des Invisible Web differieren sehr stark. So wurde im Jahr 2001 eine Studie von BrightPlanet veröffentlicht, die das Invisible Web auf 500 mal so groß wie das Visible Web schätzte. Da täglich neue Blogs und Websites dazukommen, wachsen sowohl Visible als auch Invisible Web. Letzteres soll um geschätzte 36,5 Millionen Seiten pro Jahr wachsen.

Quelle: BrightPlanet StudieLetzteres soll um geschätzte 36,5 Millionen Seiten pro Jahr wachsen.

Die Bezeichnungen Invisible- oder Unsichtbares Web sind leicht irreführend. Tatsächlich sind die Seiten nicht unsichtbar, sondern lediglich durch die gängigen Suchmaschinen nicht auffindbar. Alternativ wird daher auch der Begriff Deep Web verwendet. Warum aber werden die Seiten von Google und Co. nicht in den Suchergebnissen angezeigt?

Möglichkeit 1: Die Seite wurde nicht indexiert

Keine Suchmaschine kennt alle Seiten, die es im Internet gibt. Alles, was nicht indexiert wurde, kann dementsprechend über diese Suchmaschine nicht gefunden werden. Wenn man sich die Funktionsweise von Suchmaschinen ins Gedächtnis ruft, werden schnell einige Gründe für nicht indexierte Seiten deutlich:

- Die Crawler hangeln sich von Link zu Link. Wenn kein Link auf die entsprechende Seite führt, kann sie zwangsläufig nicht indexiert werden.

- Von der Homepage aus sollten alle Seiten mit maximal fünf Klicks zu erreichen sein, so empfehlen wir es im Sinne der Suchmaschinenoptimierung. Das liegt daran, dass die Crawler die tiefen Hierarchien nicht durchdringen. Diesen Teil des Invisible Webs nennt man auch Opaque Web. Hier spielt der Kosten-Nutzen-Faktor eine wichtige Rolle. Die Web-Robots bestimmen unter anderem nach Besuchsfrequenz, wie tief sie in die Struktur eindringen.

- Obwohl die Robots ständig unterwegs sind, benötigt der Prozess der Indexierung selbstverständlich Zeit. Möglich ist, dass aktuelle Seiten noch nicht indexiert wurden. Renommierte Seiten, die regelmäßig neu mit Inhalten unterfüttert werden, werden von den Crawlern öfters als andere Seiten durchsucht. So erreichen uns auch aktuelle Nachrichten und News über Google.

- Als Ersteller eines Internetauftritts kann jeder selbst entscheiden, welche Seite indiziert werden soll und welche nicht. Mit dem noindex-Tag sorgt der Webmaster dafür, dass der Crawler die Seite nicht in den Index aufnimmt. Diese Seiten gehören dem so genannten Private Web an.

- Weitere Gründe können in der Website-Gestaltung liegen. Suchmaschinen erkennen nur Text als Content. Wenn Grafiken und Bilder nicht mit den entsprechenden Alt- und Title-Attributen versehen werden, wird diese Seite auch nicht indiziert.

- Andererseits kann es vorkommen, dass eine Website nicht indiziert wird, weil zu viel Text auf der Seite ist, denn jede Suchmaschine hat ein Indizierungslimit für Wörter.

- Während die meisten Formate von den Crawlern gelesen werden können, gibt es Formate, wie Flash und Java Script, die nicht indiziert werden. Hier wird der Begriff Truly Invisible Web verwendet.

- Viele Internetseiten sind nicht frei zugänglich, das heißt ihre Inhalte sind durch Login mit Passwort aufzurufen (auch Proprietary Web genannt). Dies stellt ein weiteres Hindernis für die Crawler dar. In der bereits oben erwähnten Studie kam man jedoch zu dem Ergebnis, dass 95 % des Invisible Webs frei zugänglich sind.

- Die Inhalte von Datenbanken, wie zum Beispiel von Bibliothekskatalogen, können ebenfalls nicht indiziert werden, denn die Seiten werden dynamisch erzeugt. Für die Recherche in einem Katalog wird ein Stichwort in die Suchmaske eingegeben. Die Suchergebnisse werden auf einer dynamischen Seite ausgegeben und in keinerlei Form gespeichert. Kommt die nächste Suchanfrage, verschwindet die Seite wieder.

- Manche Websites sind nur in bestimmten Regionen abrufbar. Der Server der Seite kann die IP-Adresse aus anderen Ländern blockieren. Davon können auch Suchmaschinen betroffen sein.

- Dynamische URLs und URLs mit aneinandergehängten Parametern und Sonderzeichen werden häufig von Suchmaschinen ignoriert.

- Manche Seiten (insbesondere aus dem Nachrichtenbereich) haben Zeit-Limits für die Erreichbarkeit einer Website gesetzt. Die ursprüngliche URL wurde dann bereits indiziert, doch der Inhalt ist nicht mehr abrufbar.

Möglichkeit 2: Die Seite wird in den Suchergebnissen nicht angezeigt

Andererseits gibt es auch Websites, die zwar indiziert werden, aber trotzdem zum Invisible Web gehören, da sie in den Suchergebnissen nicht angezeigt werden:

- Bei Duplicate Content, also inhaltlich identischen Seiten, erscheint die Seite nur einmal in der Suchergebnisliste, da die Duplicate Content Prüfung von Google die Seiten entsprechend herausfiltert.

- Unerwünschte oder auch rechtswidrige Inhalte werden von Google zensiert und tauchen nicht in der Trefferliste auf, wie zum Beispiel Seiten mit kinderpornographischen Inhalten.

- Wenn Google auf offensichtliche Manipulation der Suchergebnisse stößt, zum Beispiel durch Keyword Spamming, behält sich Google vor, diese Seiten aus den Suchergebnissen zu streichen.

Invisible Web – Perspektiven und Ausblick

Das Invisible Web bietet großes Potenzial als Informationsquelle. Obwohl das Invisible Web nach etwas Verbotenem klingt, ist tatsächlich ein Großteil der Seiten fachspezifisches Material. Bei einer wissenschaftlichen Recherche ist es daher immer empfehlenswert, spezielle Suchdienste und Fachdatenbanken in Anspruch zu nehmen. So fand die Studie von BrightPlanet aus dem Jahr 2001 heraus, dass viele Seiten, obwohl sie nicht über die gängigen Suchmaschinen auffindbar sind, hohen Traffic haben.

Quelle: BrigthPlanet Studie

Bis zu diesem Zeitpunkt ist die Studie von Brightplanet die einzige umfangreiche Studie, welche das Invisible Web untersuchte. Bedenkt man, dass das Internet das am schnellsten wachsende Medium ist, ist eine Studie aus dem Jahr 2001 schon längst veraltet. Auch der Umgang der Suchmaschinen mit dem Invisible Web hat sich verändert. Während aufgrund von mangelndem Speicherplatz in den frühen Jahren der Suchmaschinen nur kleine Teile von Websites indexiert wurden, werden heute bereits viel umfassendere Inhalte indexiert. Mit dem Sitemaps-Protokoll hat Google schon eine alternative Methode entwickelt um die Anzahl an nicht indexierten Seiten zu verringern. Das Protokoll ermöglicht einem Webmaster, Suchmaschinen über Seiten seiner Website zu informieren, die von dieser ausgelesen werden sollen. Dadurch werden Quellen aus dem Invisible Web aufgedeckt und indexiert.

Der Anspruch von Google ist immer die Vollständigkeit gewesen. Der Trend geht zwar zu personalisierten Suchergebnissen, dennoch ist Vollständigkeit gefragt. Insofern bleibt abzuwarten, wie der Umgang der Suchmaschinen mit dem Invisible Web sich wandeln wird.

Und wer weiß schon, welche unbekannten Geheimnisse im Invisible Web schlummern und darauf warten entdeckt zu werden?

Noch eine schöne Woche wünschen euch

Gesa und die SEO Trainees

5 Antworten

Ich weiß nicht aber ich habe das gefühlt das uns irgend wann mal alles um die Ohren fliegt es kann doch nicht sein das man nur Verlinken muss.

Ich hätte echt nicht gedacht, dass es dermaßen viele Webseiten gibt, die Google nicht indexiert hat. Die Gründe dafür machen aber definitiv Sinn. Warum allerdings dringen Crawler nicht tiefer als 5 Ebenen in eine Seite ein? Hat das einen speziellen Hintergrund?

Hintergrund ist einfach, dass Gogle davon ausgeht: Je weiter weg eine Seite von der Homepage ist, desto unwichtiger ist sie. Würde der Web-Robot wirklich jede Unterseite einder Domain crawlen, würde das sehr viel Zeit in Anspruch nehmen. Google macht da wohl eine einfache Kosten-Nutzen-Rechnung.

Gut rübergebracht und das Bild finde ich oben gut gemacht 😉