Die Woche neigt sich langsam dem Ende zu – das bedeutet, wir werfen wieder einen Blick auf die neusten SEO-Geschehnisse. Im heutigen Wochenrückblick widmen wir uns dem Thema JavaScript und SEO. Außerdem geht es um die größten Erfolge und Misserfolge von Google, Chatbots und viele andere Neuigkeiten, die wir zusammengefasst haben.

JavaScript und SEO

Auf OnPage.org erstellte Irina Hey einen Guide, der JavaScript für SEO thematisiert. Der Artikel beschäftigt sich mit der Frage, ob Suchmaschinen in der Lage sind, den JavaScript Code zu crawlen. Die Autorin gibt außerdem einige Tipps, wie ihr JavaScript sinnvoll einsetzt, damit die Suchmaschinenoptimierung nicht beeinträchtigt wird.

Die Verwendung von JavaScript für Design und Funktionalität ist mit einem bestimmten Risiko behaftet, da die Crawler die Inhalte eventuell nicht lesen oder falsch interpretieren könnten. Laut Irina Hey kann Google zwar mit JavaScript gut umgehen, viele andere Bots könnten beim Crawlen von JavaScript jedoch Probleme haben. Beispielsweise könnte das Backlink-Tool Links auf der Webseite nicht erkennen.

5 Regeln für den Einsatz von JavaScript

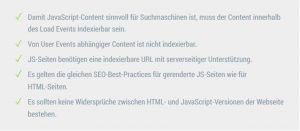

Obwohl Google technisch vielen Anbietern voraus ist, solltet ihr die Webseite nicht nur auf JavaScript-Basis entwickeln, sondern besser nur einige JS-Elemente verwenden, so die Autorin. Dafür nennt sie fünf zentrale Regeln:

Des Weiteren werden in dem Guide die häufigsten Fehler genannt, die ihr vermeiden solltet. Sie entstehen sehr oft durch fehlerhafte Implementierungen. Viele gängige SEO-Best-Practices lassen sich ebenso auf JavaScript SEO anwenden. John Müller hat im März 2016 in einem Post erklärt, worauf Webmaster bei der Verwendung von JavaScript achten sollten. Dazu gehören:

- pushState-Fehler: Mit dieser Methode kann Javascript URLs verändern. Hierbei werden die originalen URLs mit serverseitiger Unterstützung weitergegeben.

- Indexierbare URLs: Jede Seite braucht einzigartige URLs. Ein pushState bei JavaScript erzeugt jedoch keine URL. Deshalb benötigt eure JavaScript-Seite auch ein eigenes Webdokument, das einen Statuscode 200 OK als Serverantwort auf eine Client- oder Bot-Anfrage ausgeben kann.

- Fehlende Meta Daten: Ihr solltet nicht vergessen, auch für JavaScript Meta Daten zu hinterlegen.

- a href und img src: Der Google Bot benötigt Links, denen er folgen kann. Deshalb solltet ihr in den JavaScript-Dokumenten auch Links mit href- oder src-Attributen versehen.

- Kein JavaScript über robot.txt sperren: Achtet darauf, dass JavaScript-Dateien nicht in der robots.txt ausgeschlossen werden.

- Verwendung der aktuellen XML-Sitemap: Das Attribut „lastmod“ solltet ihr in der XML-Sitemap immer aktuell halten.

- Einheitliche Version: Achtet darauf, dass möglichst keine Widersprüche auftreten und z. B. canonical-Tags oder Paginierungen korrekt interpretiert werden.

Zu guter Letzt stellt die Autorin einige Tools vor, die eine JavaScript-Seite crawlbar machen, wie zum Beispiel prerender.io, Brombone oder die Google Search Console.

Als Fazit sieht Irina Hey viel Potenzial in der Einsetzung von JavaScript für die Erweiterung der Funktionalität der Webseite. Allerdings nur, wenn die oben genannten Aspekte beachtet werden. Mehr Informationen zu diesem Thema könnt ihr auf OnPage.org nachlesen.

Google News

- Die größten Erfolge und Misserfolge von Google: In den letzten 21 Jahren hat Google zahlreiche Produkte auf den Markt gebracht. Einige fanden sofort viele begeisterte Anwender, andere Projekte scheiterten hingegen. Die wichtigsten Google-Produkte und die größten Flops des Suchkonzerns findet ihr hier in Form einer Infografik. Außerdem veröffentlichte T3n noch eine interessante Übersicht, die zeigt mit welchen Produkten die Internet-Riesen – Amazon, Apple, Alphabet, Microsoft und Facebook – ihre Milliarden verdienen.

- Kein organisches Ergebnis für Featured Snippets in den SERPs: Google testet eine Änderung in den Suchergebnisseiten. Wenn Featured Snippets in den organischen Suchergebnissen auftauchen, werden sie zukünftig nicht mehr zusätzlich als reguläre Treffer in den SERPs gelistet, so Search Engine Roundtable.

- Entwicklerkonferenz Google I/O: Von Mittwoch bis Freitag findet diese Woche die Entwicklerkonferenz Google I/O statt, auf der traditionell ein Ausblick auf neue Produkte und Dienste der Tech-Welt gegeben wird. Die Veranstaltung ist zum Haupt-Event vom Google geworden. Dieses Jahr werden angeblich Neuigkeiten zur nächsten Variante des Smartphone-Systems Android und zu Augmented Reality vorgestellt, teilt GoogleWatchBlog mit. Genaue Informationen zu dem Thema könnt ihr nächste Woche bei uns nachlesen.

Vermischtes

- Chatbots auf Facebook werden cleverer: Chatbots sind aktuell einer der wichtigsten Technologie-Trends. Ziel ist es, eine Konversation als möglichst natürliches Nutzer-Interface anzubieten, sodass sie dem Gespräch mit einem Freund ähnelt. Dafür hat FAIR (Facebook AI Research) eine Open-Source-Plattform zum Trainieren und Testen von Dialogmodellen für Chatbots gestartet. Mehr Infos gibt’s auf engadget.com.

- PageSpeed Insights kritisch hinterfragt: Das Tool ist easy-to-use und hilft zu testen, ob eure Website schnell genug ist. Für kleine Websites kann das Tool sehr hilfreich sein. Für die meisten Webseiten stellt Moz.com aber in Frage, ob PageSpeed Insights wirklich so glaubwürdig ist. Bei größeren Websites ist es komplizierter, die genaue Analyse auszuführen. Deshalb empfiehlt Moz.com „a skeptical read“ von PageSpeed Insights. Was darunter zu verstehen ist, könnt ihr im Artikel nachlesen.

- Apple Watch erkennt Herzrhythmusstörungen: Laut einer Studie der University of California in San Francisco kann die Smart Watch über einen Algorithmus mit 97-prozentiger Genauigkeit ermitteln, wenn der Träger an Herzrhythmusstörungen leidet, auch Vorhofflimmern genannt. Die Erkrankung ist laut Angaben der amerikanischen Stroke Association für einen von vier Hirninfarkten (Schlaganfällen) verantwortlich.

- Snapchat und neue 3-D Filter für Werbekunden: Bei dem neuen Feature ist die Rede von einer Augmented-Reality-Funktion, bei der dreidimensionale Gegenstände in den Raum hinzugefügt werden können, berichtet Horizont. So lassen sich in die Bilder und Videos etwa Regenbögen, Wolken oder Pflanzen einfügen.

Sie sehen gerade einen Platzhalterinhalt von Youtube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Ein schönes Wochenende wünschen euch

Anastasiia und die SEO-Trainees

2 Antworten

Also ich finde die Angst vor Javascript übertrieben. Ich hatte vor kurzem mal den Fall, dass eine Webseite komplett mit AngularJS umgesetzt wurde und auch wie haben anfangs geschwitzt, ob das wirklich alles von Google korrekt indexiert wird. War aber so! Mal abgesehen davon, dass die Indexierung ca. 2 Wochen länger dauert, hat alles bestens geklappt. Und Screamingfrog kann es inzwischen auch. Nur für Bing und co. ist die Webseite vollkommen unsichtbar. Die können JS nämlich Null! 😉

Danke für deinen Kommentar.

Wie im Artikel beschrieben, ist JS nur eine Gefahr, wenn man die Regeln nicht befolgt. Du hast anscheinend alles richtig gemacht 😉

Etwas „Angst“ sollte man m. E. schon haben. Ich sehe häufig kleine und gelegentlich auch schwerwiegende Fehler bei JS. Vor allem wenn man nicht viel von SEO versteht, ist man mit gewöhnlichen HTML-Seiten wahrscheinlich eher auf der sicheren Seite.