Durch Core-Updates betreibt Google Qualitätsmanagement. Was wird aber bei diesen Updates gemacht und worauf solltet Ihr achten, damit ein Core-Update keine negative Auswirkungen auf Eure Google-Positionierungen haben.

Was bedeuten Core-Updates für Websites?

Die SEO-Welt ist schon immer dynamisch gewesen. Die jüngsten Veränderungen zeigen, dass dies auch in Zukunft so bleiben wird und dieser Trend eher zu- als abnimmt. Für die stetig wachsende Dynamik sorgen Core-Updates, die von Google durchgeführt werden. Laut SISTRIX gab es in den letzten zwölf Monaten insgesamt sechs Core-Updates, bei denen jedes Mal größere Veränderungen der Sichtbarkeitswerte vieler Websites festzustellen waren. Welche Anpassungen im Zuge dieser Updates des Google-Algorithmus durchgeführt worden sind, wird von Google nicht näher kommentiert. Die Frage bleibt nun, wie Website-Betreiber mit dieser Ungewissheit umgehen sollen. Zumal die Updates in der Vergangenheit nicht von Google detailliert kommentiert geschweigen denn angekündigt worden sind. In unserem aktuellen Top-Thema wollen wir mit Euch Aspekte durchgehen, die hinsichtlich Core-Updates immer bei Optimierungsarbeiten berücksichtigt werden sollten. Grundlage ist ein vor kurzem erschienener Artikeln von SISTRIX.

Google verstehen

Es handelt sich bei Core-Updates um Anpassungen des Suchalgorithmus von Google. Es gibt Updates von Google, bei denen ein klares Qualitätsproblem benannt wird. Bei Core-Updates wird so ein Problem nicht benannt. Google spricht von allgemeinen Anpassungen des Suchalgorithmus. Diese Updates sind also besonders zu betrachten. Es bleibt also sehr viel Raum für Spekulationen, was aus welchen Gründen an dem Algorithmus wie angepasst wird.

Jonas Weber, heutiger SEO-Berater und ehemaliger Mitarbeiter von Google, sagt dazu, dass es immens wichtig ist, die Prinzipien von Google zu verstehen. Das erste Prinzip ist demnach „Der Nutzer steht an erster Stelle, alles Weitere folgt von selbst“. Aus Sicht von Google heißt dies also, wenn der Nutzer mit den Ergebnissen, die von Google geliefert werden, zufrieden ist, besteht kein Grund dafür, eine andere Suchmaschine zu nutzen. Die Zufriedenheit der Nutzer ist also der Schlüssel für Google. Um diese aufrecht zu erhalten, arbeitet Google ständig am eigenen Qualitätsmanagement. Ein Teil davon sind die Core-Updates.

Drei unterschiedliche Gründe für Veränderungen bei Rankings

Die Gründe für Sichtbarkeitsverluste oder auch -gewinne sind nicht gänzlich geklärt. Um dennoch eine Einordnung der Veränderungen vornehmen zu können, unterscheidet Jonas Weber drei verschiedene Bereiche:

- Neue Daten von bestehenden oder neuen Websites werden hochgeladen.

- Es wird von Google an bestehenden Faktoren für die Gewichtung von Ergebnissen gearbeitet.

- Neue Signale für die Gewichtung von Ergebnissen kommen dazu.

Generell sollte man sich klar machen, dass es zwei wesentliche Perspektiven gibt. Auf der einen Seite Google, die die Nutzer zufrieden stellen wollen. Auf der andern Seite Website-Betreiber, die natürlich auch die Nutzer, aber eben auch die Suchmaschine bestmöglich befriedigen möchten, um gute Positionen in den SERPs zu erreichen. Laut Jonas Weber kann Google sehr gut quantitativ (nicht qualitativ!) nachvollziehen, was die besten Resultate für Nutzer sind. In diesem Zusammenhang haben wir in unserem Wochenrückblick von KW 12 darüber berichtet, dass Google mutmaßlich Nutzerdaten in den Ranking-Algorithmus einbezieht. An dieser Stelle kann natürlich nicht pauschalisiert werden, da „das beste Ergebnis“ aus Nutzersicht subjektiv betrachtet werden muss. Jonas Weber rät, die Dinge öfter außerhalb der „SEO-Blase“ zu betrachten.

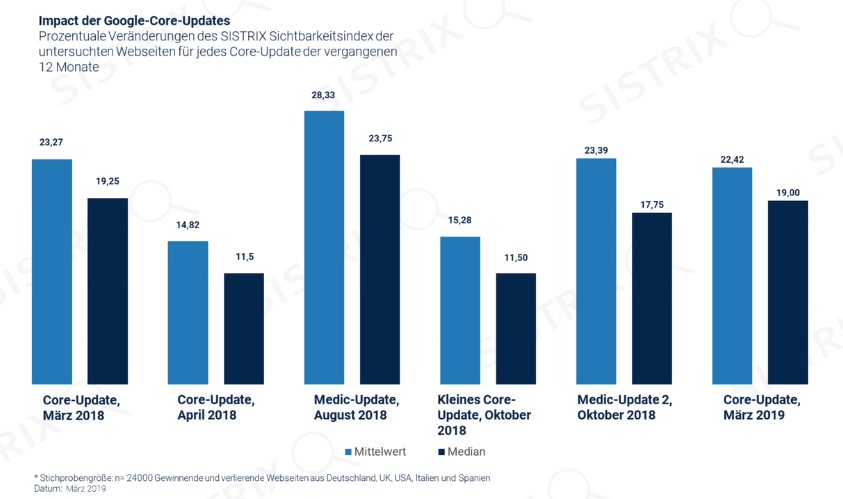

SISTRIX-Studie: Auswirkungen vergangener Core-Updates

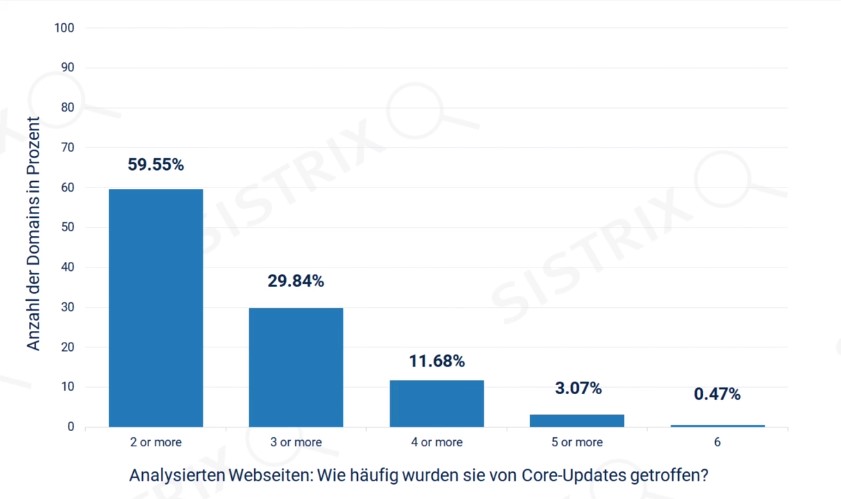

Die Studie von SISTRIX beinhaltet eine Stichprobengröße von insgesamt 24.000 gewinnenden und verlierenden Websites aus Deutschland, UK, USA, Italien und Spanien. Sie zeigt die prozentualen Sichtbarkeitsveränderungen der untersuchten Websites im Zuge der Core-Updates der letzten zwölf Monate. Die Daten veranschaulichen, dass es durchaus Bewegung nach den Core-Updates in den Suchergebnissen gibt. Nichtsdestotrotz sind sehr viele Websites gar nicht von den Auswirkungen der Updates betroffen. Zudem muss dabei bedacht werden, dass Google neue Datensätze von bereits indexierten oder komplett neuen Websites hochlädt und dies Auswirkungen auf die Sichtbarkeit haben kann.

Darüber hinaus betreffen positive sowie negative Sichtbarkeitsveränderungen sehr oft Websites, die schon einmal von den Auswirkungen eines möglichen Core-Updates betroffen gewesen sind. Jonas Weber berichtet, dass bei vielen seiner Kunden, die negativ von einem Update getroffen wurden, im Anschluss viel in die Website-Optimierung steckten. Erfahrungsgemäß wurden sie dafür auch oft mit einem positiven Sichtbarkeitsverlauf im nächsten Update belohnt. Weber kommentiert an dieser Stelle nicht, was genau optimiert wurde. Im Fokus sollte stehen, dass die Produkte bzw. die Dienstleistungen, die auf einer Website angeboten werden, einzigartig sind und für den Nutzer funktionieren. Die Frage muss sein, was Euch als Mitbewerber dazu berechtigt, in den Top-SERP-Platzierungen gegenüber der Konkurrenz zu ranken.

Wie sollten Update-Verlierer Ursachenforschung betreiben?

Wenn Ihr nun von einer negativen Sichtbarkeitsentwicklung betroffen seid, ist die Frage, wie man dieser Entwicklung entgegensteuern kann. An dieser Stelle kann vorweggenommen werden, dass es keine universell einsetzbare Vorgehensweise gibt, die alle Probleme löst. Generell sollte man in jedem Fall einen Blick in die Quality Rater Guidelines von Google werfen, die öffentlich zugänglich sind. Hier werden unterschiedliche Gewichtungskonzepte vorgestellt, die für verschiedene Seitentypen relevant sind. Auf Ursachenforschung geht Jonas Weber nun mittels zwei konkreter Aspekte, zu denen er konkrete Beispiele liefert:

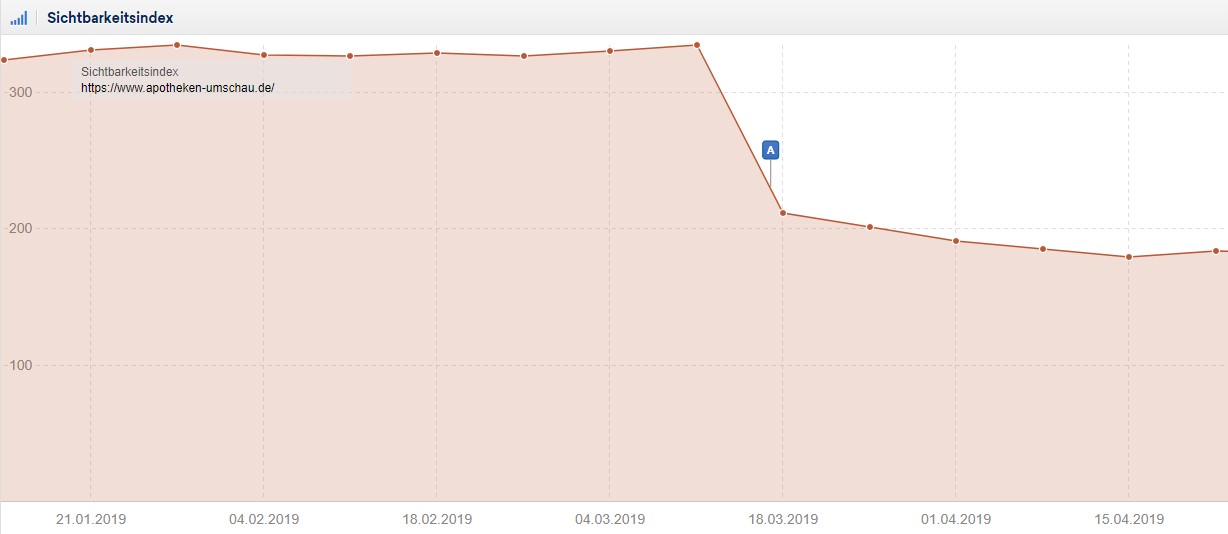

- Thin & Duplicate Content: Im Zuge des Core-Updates im März ist die Seite apotheken-umschau.de negativ betroffen gewesen. Weber kommentiert diese Entwicklung so, dass Duplicate Content für diesen Trend verantwortlich gemacht werden kann. Im Detail handelt es sich um die Beipackzettel sämtlicher Medikamente, die von der Seite indexiert wurden. Dieser Content wird ursprünglich von den Medikamentenhersteller herausgegeben. Generell sollte von einer Indexierung von Thin Content (durch Noindex-Meta-Tags) und Duplicate Content (durch Canonical-Tags) abgesehen werden.

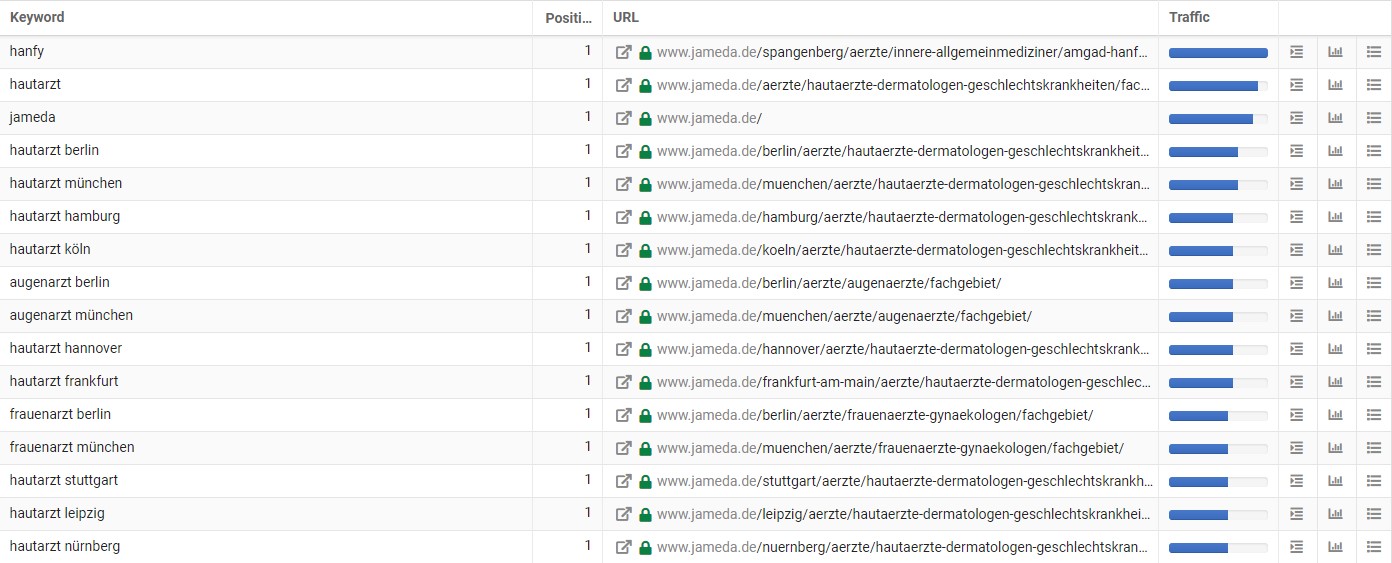

- Befriedigung von Suchintentionen der Nutzer: Ein weiteres wichtiges Thema, welches sich Google immer mehr zu Herzen nimmt, ist die Suchintention. Wenn diese aus Sicht der Nutzer nicht erfüllt wird, soll dies zunehmend negative Auswirkungen auf die Sichtbarkeit von Seiten haben. Weber führt hier die negative Sichtbarkeitsentwicklung von jameda.de, Deutschlands größtes Portal für Ärzteempfehlungen, an. Das Portal rankte vor nicht all zu langer Zeit für diverse Shorttail Keywords wie beispielsweise verschiedene Krankheiten. Auf jameda wurde dem Nutzer hierzu eine Beschreibung der Krankheit und den dazugehörigen Symptomen geliefert. Es handelt sich dabei aber nicht um den eigentlichen Kompetenzbereich von jameda.de, da andere Seiten aus dem Gesundheitsbereich schlichtweg bessere Artikel zur Verfügung stellen und die informationsgetriebene Intention der Nutzer besser erfüllen. Der wesentliche Kernbereich von jameda sind die Ärzteempfehlungen, die der Nutzer je nach Stadt und Fachgebiet des Arztes nachvollziehen kann. Zusammengefasst hat jameda.de bei erwähnten Shorttail Keywords stark an Konkurrenten verloren, während Midtail Keywords wie die Kombination aus Arztfachgebiet + Stadt weiterhin die Haupt-Traffic-Treiber der Seite darstellen.

Man sollte Update-Gewinner voneinander unterscheiden

An dieser Stelle muss man in zwei unterschiedliche Arten von Gewinnern unterteilen. Zum einen Websites, deren Sichtbarkeitsentwicklung nicht unter einem Update gelitten hat. Diese Seiten können sich auch als Gewinner zählen, da sie offenbar bereits vieles richtig machen. Dann gibt es noch Seiten, die im Zuge des Updates an Sichtbarkeit dazu gewonnen haben. Wie auch zuvor bei den Update-Verlierern beschrieben, kann kein Patentrezept der Gewinner pauschal festgestellt werden. Es fließen einfach zu viele Faktoren in die Bewertung mit hinein, die eine tragende Rolle spielen können.

Worauf sollte man sich generell fokussieren?

Bei diesen abschließenden Empfehlungen von Jonas Weber wird davon ausgegangen, dass bereits ein solides Website-Gerüst aus relevantem Content, guten Backlinks und funktionierender Technik besteht. Man sollte also zwischen Websites unterscheiden, die sich erst ihr Ranking erarbeiten müssen und solchen, die bereits für relevante Keywords gut positioniert sind.

Zunächst einmal sollten voreilige Schlüsse aus etwaigen Sichtbarkeitsentwicklungen prinzipiell vermieden werden. Bei zunehmend negativen Tendenzen sollte in Ruhe analysiert werden, wie man sein Produkt bzw. seine Dienstleistung für den Nutzer besser machen kann. Zusammenfassend kann gesagt werden, dass es nicht ein Faktor, sondern eine Fülle an unterschiedlichen Aspekten gibt, die bei der Entwicklung eine Rolle spielen. Jonas Weber empfiehlt, sich zunächst den Punkten Thin Content sowie externem und internem Duplicate Content zu widmen. Ihr solltet Euch immer vor Augen führen, dass Google nicht unendliche Ressourcen zur Verfügung stehen, um wirklich alle Inhalte einer Seite einzubeziehen. Aus diesem Grund sollte kein Crawling-Budget durch Duplicate oder Thin Content verschwendet werden. Nur die für den Nutzer wichtigen Seiten sollten in das Crawling einbezogen werden. Generell kann Crawling-Budget eingespart werden, wenn vornerein wichtige Seiteninhalte mit wenigen Klicks von der Startseite aus erreichbar gemacht werden. Zudem solltet Ihr darauf achten, dass bei Eurer internen Verlinkung alles korrekt eingerichtet ist und so 404-Fehlerseiten vermieden werden. Eine XML-Sitemap ist für das Crawling-Budget ebenfalls sehr wichtig, da es dem Suchmaschinen-Bots eine Art Landkarte Eurer Website mitgibt und so der Crawling-Prozess beschleunigt werden kann.

Die Nutzerintention ist ein weiterer wichtiger Aspekt. Ihr solltet Euch selbst fragen, welche Suchintentionen durch Eure Website bedient werden und wie man sich von Konkurrenten abheben kann. Generell können hier mehrere Bereiche unterschieden werden:

- Informationsgetriebene Intentionen

- Kaufgetriebene Intentionen

- Navigationsgetriebene Intentionen

- Brandgetriebene Intentionen

- Unklare Intentionen (bei einigen sehr generischen Keywords)

Hier muss die Frage im Mittelpunkt stehen, wie Google die Suchergebnisse zusammenstellt. Wird beispielsweise das Keyword „Kredit“ eingegeben, werden Ergebnisse angezeigt, die kaufgetriebene Intentionen widerspiegeln. Suchergebnisse, die eine informationsgetriebene Intention von Nutzern widerspiegeln (wie beispielsweise Definitionen des Worts Kredit) werden für das Keyword zunächst einmal nicht angezeigt. Weber stellt es im Umkehrschluss so dar, dass Google Daten von Nutzern auswertet, um die SERPs letztendlich abzubilden. Aus diesem Grund solltet Ihr als Website-Betreiber Euch genau anschauen, wie Google die Suchergebnisse zu Keywords darstellt, für die Ihr ranken wollt. Wird die Suchintention gut bedient, können auch mehr positive Nutzersignale gesammelt werden, was sich laut Weber wiederum positiv auf die Positionierung in den Ergebnissen auswirkt.

Grundsätzlich gilt, dass die beste SEO-Strategie keinen Nutzen hat, wenn die Website selbst dem User keinen Mehrwert bietet.

Google-Themen

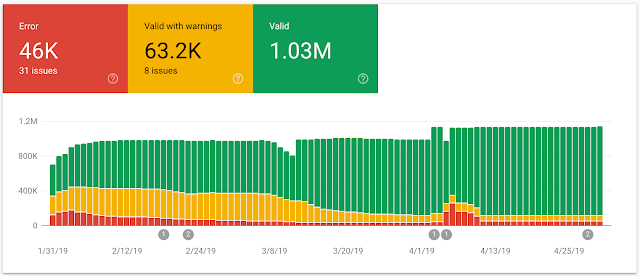

- Datensätze einiger Google-Search-Console-Berichte sind komplett verloren gegangen: Google bestätigt nun, dass in dem Zeitraum vom 09. bis zum 25. April Daten aus einigen Reports der Search Console endgültig verloren sind. Nun ist diese mutmaßliche Folge des Indexierungsproblems, über das wir auch in unseren letzten Wochenrückblicken berichtet hatten, zur Gewissheit geworden. Von dem Problem können alle Berichte bis auf die Performance-Daten betroffen sein. Google selbst bestätigt, dass der Datenausfall ab dem 26. April behoben worden sei.

- Google erklärt, wie sich die geringe Qualität einzelner Seiten auf das Ranking einer ganzen Website auswirkt: Dies muss nicht immer der Fall sein, ist aber durchaus möglich. In einem aktuellen Webmaster Hangout beantwortete John Mueller eine Nutzerfrage nun so, dass es manchmal nicht möglich sei, die Qualität einzelner Unterseiten zu bewerten, sondern das Gesamtbild einer Website in diesem Fall entscheidend sei. Nach diesem Bewertungsprinzip wird laut Mueller dann verfahren, wenn die Qualität der verschiedenen Seiten einer Website sich stark voneinander unterscheidet. Dabei sollte das Verhältnis zwischen Seiten mit hoher und solchen mit fragwürdiger Qualität ausgeglichen sein. Wenn eine Website überwiegend Seiten mit einem hohen Qualitätsstandard beinhaltet, fallen einzelne Seiten mit schlechterer Qualität mutmaßlich weniger ins Gewicht und umgekehrt.

- Google bestätigt die Engine-Umstellung auf Chromium 74: Vor zwei Wochen hatten wir bereits in unserem Wochenrückblick darüber berichtet, dass der Google-Crawler mit einer neueren Version der Rendering-Engine Chromium gesichtet wurde. Am 07. Mai bestätigte Google nun offiziell, dass die Umstellung auf Chromium 74 stattgefunden habe. Es bedeutet für Euch, dass der Googlebot nun dazu in der Lage ist, mehr als 1.000 neue Features zu rendern. Unter anderem zählen dazu neuere Versionen von JavaScript oder zum Beispiel auch IntersectionObserver für Lazy Loading. Die zuvor noch als eine Art Vermittler zwischen der in die Jahre gekommenen Crawler-Engine und neuerer Features auf Websites dienenden Polyfills können nun laut Google entfernt werden. Vor einer Entfernung solltet Ihr darauf achten, dass der Crawler wirklich alle Eure Features rendern kann. Updates sollen in Zukunft nun regelmäßiger durchgeführt werden.

- Neue Funktionen in der Google Search Console zu strukturierten Daten: Ab sofort sind neue Berichte für Websites mit strukturierten Daten in der Google Search Console verfügbar. Im Webmaster Central Blog von Google wurde darüber berichtet, dass mit diesen Berichten Syntaxfehler nachvollzogen werden können. Zudem sind Reports abrufbar, die Euch Warnungen, Fehlermeldungen und funktionierende Anzeigen von den Sitelink-Typen „Searchbox“ und „Logo“ angeben. Dieser Bericht wird Enhancements-Report genannt.

Vermischtes

- SEMrush-Studie zu Display-Werbung 2019: Das Displaynetzwerk von Google erreicht gemäß der Studie 90 % aller Internetnutzer und ist somit das größte Anzeigen-Netzwerk weltweit. Welche interessanten Insights die Studie darüber hinaus für Euch bereithält, könnt Ihr dem Artikel von SEMrush entnehmen.

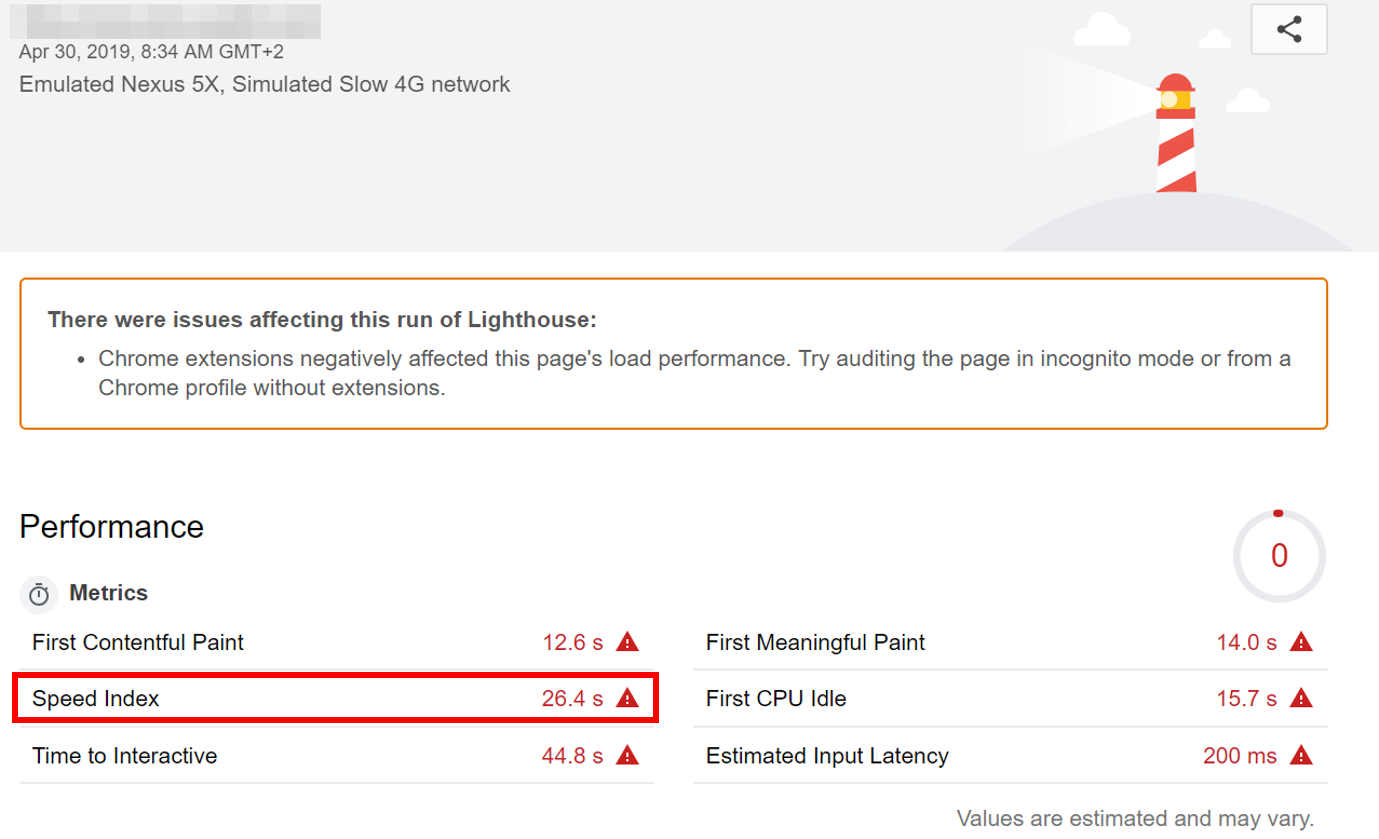

- Das bedeutet die Kennzahl Speed Index im Tool Lighthouse oder PageSpeed Insights: SEO-Südwest hat vor kurzem einen Artikel veröffentlicht, der die Berechnung der Kennzahl Speed Index transparent erklärt. Oft wird die Bedeutung dieses Werts mit der gesamten Ladezeit einer Website gleichgesetzt. Das ist eine falsche Annahme. Der Index gibt den Verlauf des Seitenaufbaus wieder. Lest den Artikel von SEO-Südwest, um Euch zu informieren, wie der Wert sich genau zusammensetzt.

- Wie könnt Ihr für die chinesische Suchmaschine Baidu optimieren: Wegen Googles mächtiger Marktpositionierung kann es leicht passieren, dass die übrigen Suchmaschinen in Vergessenheit geraten. Doch beispielsweise auch Baidu hat weltweit zwei Milliarden Nutzer. Gerade bei Websites, die für chinesische Zielgruppen interessant sind, lohnt sich aus diesem Grund eine SEO-Optimierung. Die SEO-Spezialisten Jordan Koene und Ben Shapiro haben sich hierzu in einem Podcast ausgetauscht, welcher bei searchmetrics erschienen ist.

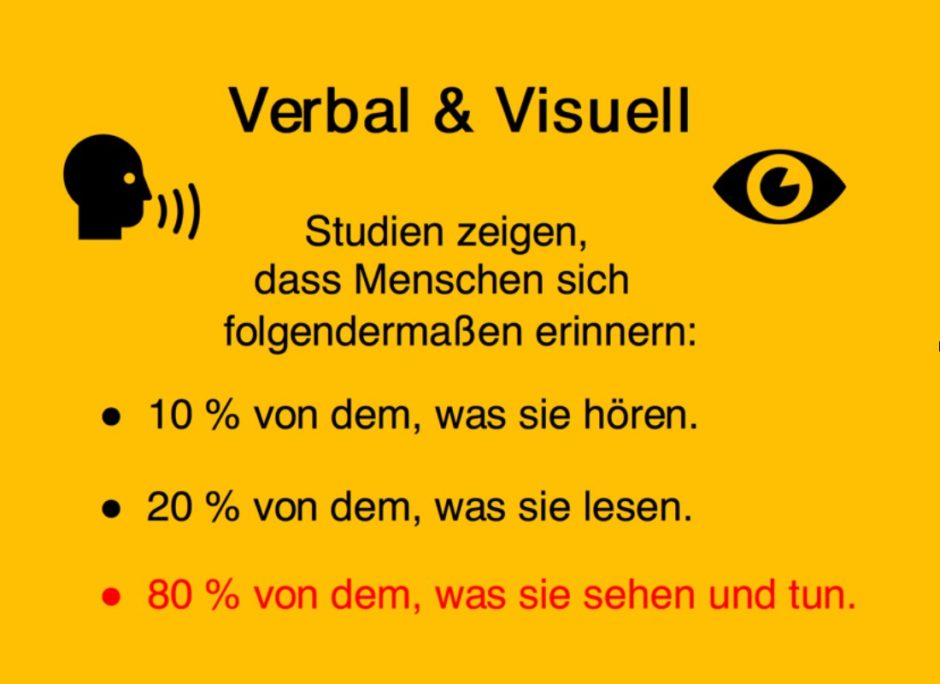

- Visuelle Kommunikation ist Trumpf: Dies ist bei weitem keine neue Information, aber dennoch immer wieder wichtig. Das UPLOAD Magazin hat nun einen umfassenden Artikel veröffentlich, der nochmals gut strukturiert festhält, wieso visuelle Inhalte so wichtig sind, wie genau diese Kommunikationsart auf uns Menschen wirkt und welche Formen wann angewendet werden. Wir wünschen viel kreativen Erfolg.

Unsere Tipps der Woche

- Was Ihr über Call Tracking wissen solltet: 65 Prozent der Kunden finden es bequemer, Unternehmen per Telefon zu kontaktieren, verglichen mit nur 24 Prozent, die es vorziehen, ein Webformular auszufüllen. Deshalb müssen digitale Vermarkter Daten für Offline-Anrufumwandlungen und webbasierte Umwandlungen kombinieren. Searchenginejournal.com hat alles Wichtige zum Thema zusammengestellt.

- Tools für Social Media Monitoring: In den sozialen Netzwerken werden Produkte und Marken auf unterschiedliche Weise erwähnt: Empfehlungen werden ausgetauscht, es hagelt Beschwerden, es wird über Anzeigen gesprochen oder eine Marke wird am Rande erwähnt. Um immer den Überblick zu behalten, sind Tools für das Überwachen von Social-Media-Aktivitäten sinnvoll. Obwohl Social Media Monitoring ein recht einfaches Konzept ist, können Tools in Preis und Funktionen stark variieren. Auf searchenginejournal.com findet Ihr eine hilfreiche Zusammenstellung von Tools.

- Google startet bald Videoreihe über SEO-Mythen: Google startet bald eine neue Videoreihe über SEO-Mythen. Die Reihe „SEO Mythbusting“ wird von Martin Splitt kreiert und auf dem Google Webmasters YouTube-Kanal veröffentlicht. Splitt hatte kürzlich Videos über JavaScript SEO abgeschlossen.

Wir wünschen Euch ein schönes Wochenende!

Janek und die SEO-Trainees

Eine Antwort

Die Entwicklung geht seit Jahren immer nur in eine Richtung: Hochwertige Inhalte und qualitativ hochwertige, themenrelevante Backlinks von Seiten mit hoher Authorität. Die Bedeutung der Backlinks wird künftig wohl eher abnehmen (aber sicher nicht verschwinden), während hochwertige Inhalte noch höher gewichtet werden.

Das die Befriedigung von Suchintentionen der Nutzer dabei im Zentrum steht, ist mehr als logisch. Und auch hier spielt Authorität und Vertrauenswürdigkeit wieder eine grosse Rolle. Der medizinische Bereich ist ein hervorragendes Beispiel dafür: Google kann sich schlicht nicht erlauben, die ganze erste Seite der Suchresultate voller Affiliateseiten zu haben, die mit zweifelhaften Inhalten das grosse Geld mit Partnerprogrammen verdienen wollen. Das Core-Update geht meiner Meinung nach eindeutig in die richtige Richtung, und es wird noch lange nicht das letzte dieser Art gewesen sein.