Ein SEO Audit dient dazu, eine Website vollumfänglich auf ihr SEO-Profil hin zu untersuchen und Fehler zu ermitteln, an denen im Anschluss gearbeitet werden kann, um die Sichtbarkeit der Website in der organischen Suche zu verbessern. Im Top-Thema unseres Wochenrückblicks erfahrt Ihr, was ein SEO Audit beinhaltet und wie Ihr dabei vorgehen könnt. Außerdem: Ahrefs will mit eigener Suchmaschine in Konkurrenz zu Google treten.

Was ist ein SEO Audit?

Was ist ein SEO Audit?

Für viele ist SEO so etwas wie eine Blackbox. Viele wissen, dass SEO wichtig für die Sichtbarkeit einer Website ist, aber sie wissen nicht, wie sie mit dem Thema umgehen sollen oder was alles dazugehört.

Bei einem SEO Audit wird eine Website in diversen SEO-relevanten und SEO-verwandten Bereichen überprüft. Das Ziel des SEO Audits ist, die Schwachstellen einer Website aufzuspüren, deren Optimierung sehr wahrscheinlich zu einer verbesserten Sichtbarkeit in den Suchmaschinenergebnissen verhelfen würden. Der SEO Audit schließt mit einer Reihe von Empfehlungen ab, die dem Betreiber der geprüften Website dabei helfen sollen, die Sichtbarkeit in der organischen Suche zu erhöhen.

Ihr würdet gerne wissen, welche Bereiche in einem SEO Audit berücksichtig werden sollten und woraufhin man die Website prüfen sollte? In der vergangenen Woche wurde von Credo eine Anleitung für einen SEO Audit vorgestellt. Einige Punkte aus dem Beitrag wollen wir Euch heute vorstellen.

Wann macht ein SEO Audit Sinn?

Wer mit der Performance seiner Website nicht zufrieden ist und sowieso das Gefühl hat, dass etwas besser gemacht werden könnte, der kann mit einem SEO Audit kaum etwas falsch machen. Aber egal ob eine Website nicht so gut rankt oder bereits gut läuft. Man sollte sich immer fragen, was man noch besser machen könnte und ein SEO Audit kann hier für gewöhnlich gleich diverse Antworten liefern.

In SEO zu investieren ist generell ein sehr guter Weg, um die Sichtbarkeit einer Website langfristig zu verbessern und ein SEO Audit zeigt Euch die SEO-Schwachstellen Eurer Website auf.

Was beinhaltet ein SEO Audit?

Ein SEO Audit behandelt einfach gesagt schlichtweg alle Bereiche, die irgendwie in Zusammenhang mit SEO und somit mit der organischen Sichtbarkeit einer Website stehen.

Diese wären:

- Die Technik einer Website

- Der Content einer Website

- Die Wettbewerber

- Keywords

- Links

Sich einen Überblick verschaffen

Es ist ratsam, sich zunächst einmal mit der aktuellen Performance seiner Website zu beschäftigen. Dies geht am einfachsten mit Hilfe von Google Analytics und der Google Search Console.

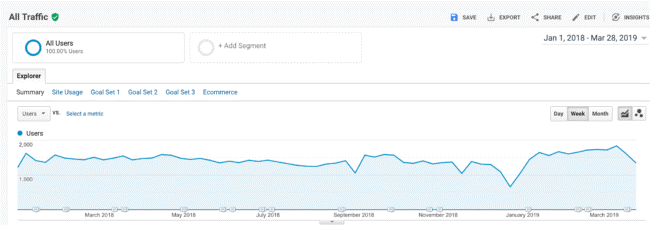

Startet damit, Euch in Analytics einen Überblick über die Performance der Website zu verschaffen (Zielgruppe ➤ Übersicht). Gut ist immer, sich die Daten für ein Jahr rückwirkend anzuschauen, um zum Beispiel saisonale Schwankungen erkennen zu können.

Macht Euch Gedanken darüber, wo ein Verlust der Sichtbarkeit herrühren könnte. Zum Beispiel verzeichnen viele Seiten über die Weihnachtsfeiertage einen Traffic-Rückgang, der jedoch keine Panik bei Euch auslösen sollte und sich im Normalfall von allein wieder erledigt, wenn die Menschen aus dem Feiertagskoma erwachen und das Internet wiederentdecken.

Ein Rückgang des Traffics kann unter anderem auch damit in Verbindung stehen, dass das Tracking aus irgendeinem Grund nicht mehr läuft. Daher sollte diese Möglichkeit in Betracht gezogen und geprüft werden.

Gibt es aber keine derartige Erklärung für einen Traffic Drop, dann könnte es tatsächlich am SEO Eurer Website liegen. Möglicherweise gab es ein Google Update, durch das sich die Anforderungen an SEO schlichtweg geändert haben oder Wettbewerber haben Euch aus irgendeinem Grund im Ranking überholt und heimsen nun den Traffic ein, der vorher auf Eure Website gelangte. In diesen beiden Fällen ist ein SEO Audit Gold wert, um herauszufinden, was falsch läuft.

Prüfen, welche Seiten Traffic bringen

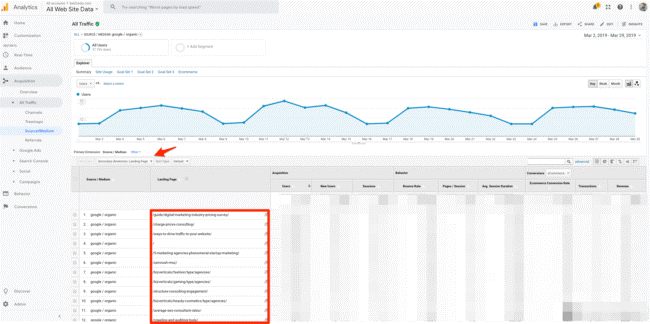

Navigiert in Google Analytics in den Bereich Akquisition ➤ Quellen ➤ Alle und wählt unter dem Graphen Quelle/Medium aus und klickt auf Google/Organic. Als sekundäre Dimension wählt Ihr im Anschluss Landingpage aus.

Nun schaut Ihr Euch die Liste an, die Euch ausgegeben wird. Zum einen seht Ihr, welche Landingpages für den meisten Traffic sorgen und somit die interessantesten für die Nutzer zu sein scheinen. Mit dieser Information könnt Ihr Vergleiche von gut performenden Seiten zu schlechter performenden Seiten aufstellen. Was habt Ihr auf den Traffic-starken Seiten besser gemacht als auf den Seiten mit weniger Traffic?

Je weiter nach unten Ihr in der Landingpage-Liste scrollt, umso spannender kann die Liste werden. Haltet Ausschau nach URL-Parametern, die zu Duplicate Content führen können und schaut auch, ob Ihr in der Liste URLs findet, die eigentlich nicht indexiert sein sollten, aber dennoch Traffic erhalten.

Traffic Keywords

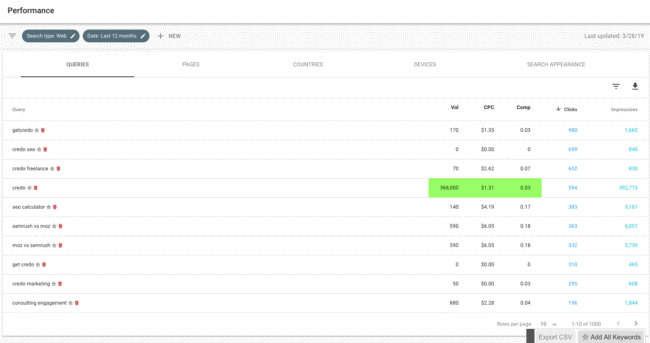

Nun schaut Euch in der Google Search Console im Bereich Leistung um. Hier seht Ihr erneut eine Übersicht über die Traffic-Daten. Darunter findet Ihr eine Auflistung derjenigen Keywords, die Eure Nutzer auf Eure Website bringen.

Diese Informationen sind daher nützlich, weil sie Euch klare Daten darüber liefern, was die Nutzer in die Suche eingeben und im Anschluss auf Eurer Seite landen – für welche Keywords Eure Seite also bereits gut funktioniert. Ebenso zeigen Euch die Daten, welche Keywords bisher nicht so viel Traffic bringen, wie Ihr es vielleicht vermutet hattet, woran Ihr im Anschluss also arbeiten könnt.

Klickt Ihr in der Search Console auf ein einzelnes Keyword, könnt Ihr Euch außerdem die Entwicklung dieses Keywords anschauen. In anderen Tools, wie zum Beispiel Sistrix und SEMrush, könnt Ihr Euch diese Keyword-Daten in einer Auflistung von mehreren Keywords anzeigen lassen. Aber egal welches Tool Ihr wählt, auf diese Weise erhaltet Ihr die Information, ob Eure Keywords über die Zeit im Ranking gefallen oder gestiegen sind. Macht Euch ein Bild davon, ob vielleicht ganze Keyword-Sets eine Änderung erfahren haben und ob diese Änderungen vielleicht sogar mit einem Abfall oder Anstieg des Traffics Eurer Seite einhergehen.

Indexierung, Statuscodes und weitere Fehlerquellen prüfen

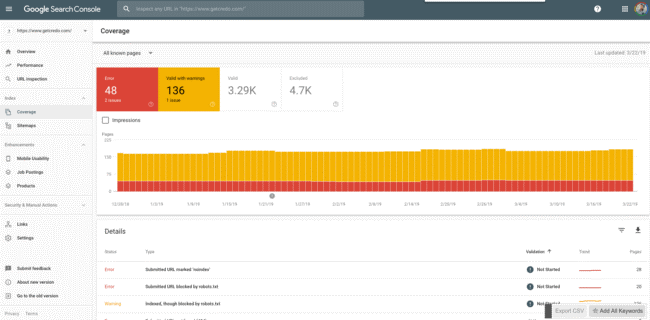

Im Bereich Abdeckung in der Google Search Console könnt Ihr Euch mit verschiedensten Problemquellen auseinandersetzen. Hier könnt Ihr Euch zum Beispiel anzeigen lassen, welche Seiten indexiert, aber nicht in der Sitemap zu finden sind, oder welche Seiten zwar gecrawlt, aber nicht indexiert werden. Auch könnt Ihr Euch zum Beispiel die URLs anzeigen lassen, die den Statuscode 404 ausgeben. In diesem Bereich werdet Ihr für gewöhnlich viele Hinweise finden, woran Ihr arbeiten könnt, um Eure Website aufzuräumen und Google so das Crawlen und Indexieren Eurer Seite zu erleichtern.

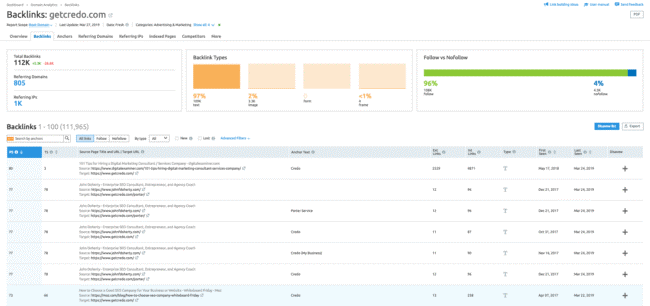

Backlinks

Unter anderem bietet das Tool SEMrush gute Möglichkeiten, die Backlinks Eurer Website genauer zu untersuchen. Im Bereich Backlinks (Überraschung!) und hier unter dem Reiter Backlinks (siehe vorige Klammer) könnt Ihr zum Beispiel die Links nach Trust sortieren. Lasst Euch die Links mit einem geringen Trust Score anzeigen und schaut Euch die Links und dazugehörigen Domains an. Möglicherweise sind diese Links einen Disavow wert, welchen Ihr über das Google Disavow Links Tool einreichen könnt. Wie Ihr dabei vorgehen müsst, erfahrt Ihr in diesem Guide von Google.

Auch könnt Ihr Euch in dem Tool die Ankertexte Eurer Backlinks anzeigen lassen. Unschön ist es, wenn die Ankertexte zu einem großen Teil aus Money-Keywords bestehen oder oft nichtssagende Worte wie hier als Anker dienen. Ein schönes Ankertext-Profil bietet viel Variation und Ankertexte mit Keywords, die wirklich gut zum Inhalt der verlinkten Seite Eurer Website passen. Wenn Euch die Ankertexte Eurer Backlinks nicht besonders gut gefallen, ist es oftmals nicht so leicht, dieses zu ändern, schließlich finden sich die Links und Anker auf externen Seiten. Aber Ihr könnt in jedem Fall darauf Acht geben, dass bessere Ankertexte verwendet werden, wenn Ihr zukünftigen Linkaufbau betreibt.

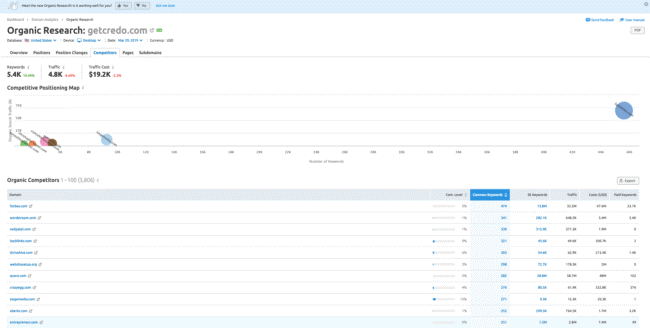

Wettbewerber

Es ist wichtig, Eure Wettbewerber im Blick zu behalten. Wer sind Eure Wettbewerber? Was machen sie möglicherweise besser als Ihr? Auch hier bietet wieder unter anderem das Tool SEMrush spannende Daten. So könnt Ihr Euch im Bereich Domain Analytics ➤ Organische Recherche den Reiter Mitbewerber anschauen. Hier werden Euch die Wettbewerber aufgezeigt, die für dieselben Keywords ranken, für die auch Ihr rankt. Nun könnt Ihr Euch die Seiten Eurer Wettbewerber anschauen und prüfen, was Ihr vielleicht besser machen könntet als bisher.

Betrachtet allerdings die Liste der angezeigten Mitbewerber mit Vorsicht und fragt Euch, ob die einzelnen auch tatsächlich wahre Wettbewerber Eures Unternehmens sind. Habt Ihr wahre Wettbewerber identifiziert, könnt Ihr Euch auch noch einmal gezielt die Daten der spezifischen Wettbewerber anschauen. Gebt dazu einfach die URL des Mitbewerbers in das Tool ein und schaut Euch zum Beispiel an, für welche Keywords Euer Wettbewerber gut rankt (für die Ihr vielleicht schlechter oder gar nicht rankt).

Schlussworte

In diesem Beitrag haben wir Euch ein paar Möglichkeiten aufgezeigt, wie Ihr damit beginnen könnt, Eure Website auf SEO-Basis zu analysieren, doch es gibt noch weitaus mehr Daten, die analysiert werden können, um Euch Aufschluss über Eure Website zu geben. Weitere Daten, die Euch Ideen liefern, was Ihr besser machen könnt, um in der organischen Suche besser zu ranken.

Eine bisher nicht angesprochene Möglichkeit ist der Crawl Eurer Website mit Tools wie zum Beispiel Screaming Frog SEO Spider. Wer allerdings noch wenig Kontakt zu SEO hatte, wird vermutlich länger brauchen, um das Tool und die gelieferten Daten zu durchschauen.

Unser Tipp: Klickt Euch zunächst durch Google Analytics und die Google Search Console. Hier allein findet Ihr jede Menge brauchbare Informationen. Im Anschluss könnt Ihr Euch eines der SEO Tools anschauen. Diese Tools liefern Euch schon so viele Daten, dass Ihr eine ganze Weile beschäftigt sein werdet.

Und zum Schluss ist zu sagen: Ein SEO Audit ist zwar irgendwann beendet, aber nur für den Moment. Technische Fehler können identifiziert und behoben werden, Content kann verbessert und mithilfe aktueller Keywords optimiert und Backlinks können aufgeräumt werden (und noch vieles mehr). Aber es werden neue schlechte Backlinks auftauchen. Keyword-Trends werden kommen und gehen und technische Fehler schleichen sich immer wieder aufs Neue ein.

Daher empfehlen wir, Euch der Aufgabe eines SEO Audits in regelmäßigen Abständen zu widmen oder besser noch ein SEO Monitoring einzurichten.

Google News

- Das URL Inspection Tool der Google Search Console ist nicht für non-web Content gedacht. Wer mit dem URL Inspection Tool der Search Console von Google CSS- und JavaScript-Dateien prüft, wird sehr wahrscheinlich eine Fehlermeldung erhalten. Das Tool behauptet dann, dass die Datei blockiert sei, auch wenn sie de facto nicht per robots.txt gesperrt ist. Wie John Mueller auf Twitter mitteilte, ist der Grund dafür die Tatsache, dass das Tool schlichtweg nicht für CSS- und JavaScript-URLs gedacht ist.

- Für paginierte Inhalte URL-Parameter anstelle von Verzeichnissen verwenden. Auf Twitter wurde John Mueller gefragt, ob es besser sei, paginierte Seiten via URL-Parameter (?seite=2) oder als Verzeichnis (/seite/2) auszuzeichnen. John Mueller antwortete darauf, dass beide Möglichkeiten genutzt werden können, aber er würde die Verwendung von Parametern empfehlen, weil sie einfacher in der Anwendung seien und weniger Probleme beim Crawlen verursachten als „Pseudo-Verzeichnisse“.

- Das Erscheinen von Suchergebnissen in bestimmten Ländern kann nicht blockiert werden. Wieder befinden wir uns auf Twitter und wieder wurde eine Frage an John Mueller gerichtet. Ein Nutzer wollte wissen, ob es möglich sei, das Ausspielen von Websites in den SERPs für bestimmte Länder oder Regionen zu verbieten. John Mueller antwortete daraufhin ganz klar, dass dies nicht möglich sei. SEO-Südwest hat auf zwei Möglichkeiten hingewiesen, wie man dies dennoch umsetzen könnte:

- Eine alternative Version einer Website für die Länder anbieten, die in der Suche ausgeschlossen werden sollen. Per Geo-Targeting kann Google dann angewiesen werden, die alternative Version in der entsprechenden Region auszuspielen.

- Nutzer auf Basis ihrer IP-Adresse von dem Besuch der Website ausschließen.

- Links, die nicht in der Search Console angezeigt werden, sind irrelevant. Diesmal wurde John Mueller auf Reddit eine Frage gestellt, die lautete: können Links, die in der Google Search Console nicht angezeigt werden, eine Seite negativ beeinflussen? John Mueller antwortete daraufhin, dass Links, die nicht in der GSC angezeigt werden, für gewöhnlich ziemlich irrelevant sind.

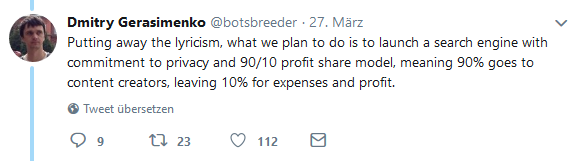

Vermischtes

- Ahrefs arbeitet an einer eigenen Suchmaschine. Dmitry Gerasimenko, Gründer und CEO von Ahrefs, hat auf Twitter geäußert, dass Ahrefs an einer eigenen Suchmaschine arbeitet, die in Konkurrenz zu Google treten soll. In seinem Twitter-Thread weist Dmitry auf zwei große Probleme von Google hin. Das erste ist die bekanntermaßen kaum vorhandene Privatsphäre. Der zweite Punkt wird interessant: Dmitry sagt, Google nimmt 100 Milliarden Dollar mit der Suchmaschine ein. Nun sollen wir uns vorstellen, was für eine andere Welt es wäre, würde Google ein 90/10-Profitmodell einführen, bei welchem 90 Milliarden Dollar an die Publisher gehen würden, die den Content kreieren, der Google überhaupt erst die Einnahmen ermöglicht. Und genau das ist es, was für die Suchmaschine von Ahrefs vorgesehen ist: ein 90/10-Profit-Share-Modell. Und wie DuckDuckGo will auch Ahrefs deutlich mehr Wert auf Privatsphäre legen.

- Digitalsteuer für Österreich beschlossen. Auf EU-Ebene ist die Einführung der Digitalsteuer zwar gescheitert, die schwarz-blaue Regierung hat selbige aber nun für Österreich beschlossen, wie Finanzminister Hartwig Löger mitteilte. Internet-Unternehmen mit einem Jahresumsatz von 750 Mio. Euro müssen in Österreich künftig 5 % Steuern auf Gewinne aus Online-Werbung zahlen. Die österreichische Regierung erhofft sich durch die Einführung der Digitalsteuer zusätzliche Steuereinnahmen in Höhe von mehr als 200 Millionen Euro, wie unter anderem auf tagesschau.de und horizont.de berichtet wurde.

- OnpageDoc gehört jetzt zu Seobility. Die seobility GmbH, Betreiber der gleichnamigen SEO Software Seobility, hat den deutschen Wettbewerber OnpageDoc zum 01. April 2019 übernommen. Pläne für die Übernahme bestanden wohl schon seit 2017, heißt es in der offiziellen Pressemitteilung von Seobility. Der Betrieb von OnpageDoc wird im Juni eingestellt werden. Im Rahmen der Übernahme wird jedoch allen OnpageDoc-Kunden die Seobility Software zu attraktiven Wechselkonditionen angeboten.

- Zwei spannende Infografiken zum Thema Local SEO. In dieser Woche sind uns gleich zwei Infografiken bezüglich Local SEO untergekommen, die wir Euch nicht vorenthalten wollen. Denn sie zeigen, wie sinnvoll es für lokal agierende Unternehmen ist, ihr Local SEO zu optimieren. Allein folgende Zahlen sind sehr imponierend:

- 46 % aller Suchanfragen in Google seien lokale Suchanfragen

- mobile lokale Suchanfragen seien von 2016 auf 2018 um 900 % gestiegen

Die Infografiken findet Ihr auf den Seiten von Score und SocialMediaToday.

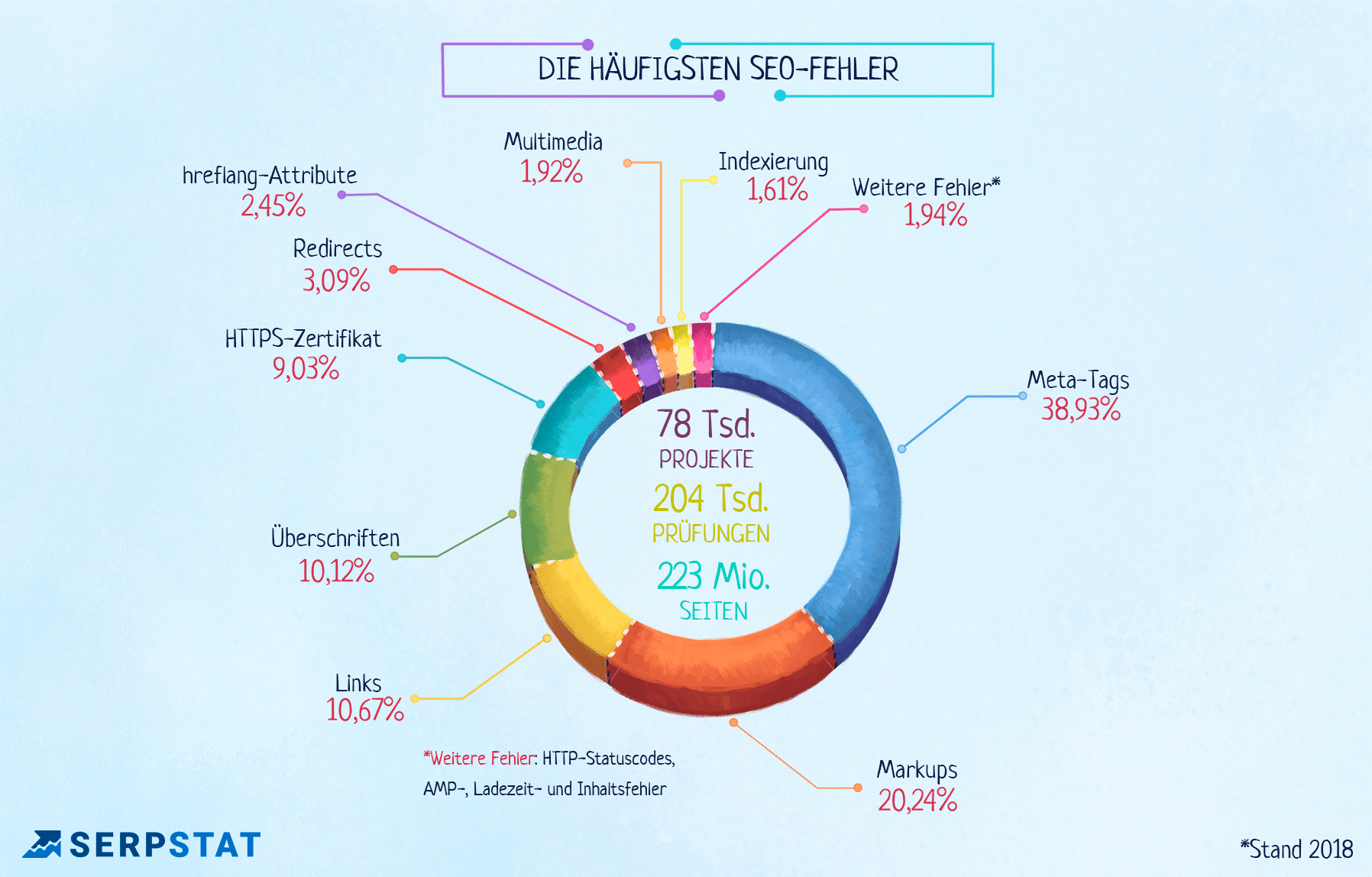

Unsere Tipps der Woche

- Die häufigsten SEO-Fehler. Serpstat hat in einer Studie 223 Mio. Seiten auf SEO-Fehler geprüft und bietet in einem Beitrag Einsicht in die gewonnenen Daten. Dabei wird deutlich, dass die Gestaltung der Meta-Tags scheinbar ganz besonders oft vernachlässigt wird und das obwohl der Meta-Title ein wichtiger Keyword-Träger ist. Aber auch Links, Markups, Überschriften, HTTPS, Redirects, Indexierung und die Ladezeit werden unter anderem besprochen. Schaut doch mal in den Artikel von Serpstat rein, findet heraus, wo besonders oft Fehler gemacht werden und prüft im Rahmen Eures SEO Audits gleich nach, ob Ihr diese Fehler vielleicht auch macht.

- Wie uns die sozialen Medien in den April geschickt haben. Neu erhältlich in jedem Fressnapf: Die Gassi-Drohne, die mit Eurem Hund Gassi geht. Und auf Tinder hat die Schummelei bezüglich der Körpergröße dank einer neuen Funktion endlich ein Ende: Nutzer müssen sich nun neben einem öffentlichen Gebäude fotografieren und die Körpergröße wird automatisch ermittelt. Was sich noch für Aprilscherze im Web getummelt haben, findet Ihr in einem Beitrag auf onlinemarketing.de.

Ein schönes Wochenende wünschen Euch

Jill und die SEO-Trainees