Das neue Jahr startet direkt mit technologischen Schwergewichten: Google Chrome wandelt sich zum KI-Browser-Agenten und Bing liefert mit dem neuen „AI Performance“-Report erstmals (Beta-)Daten zur Sichtbarkeit in der KI-Suche. Während Google SearchGuard den Kampf gegen Scraper verschärft, rücken in den KI-News vor allem die Einführung von Werbung in ChatGPT sowie neue Erkenntnisse zur Unberechenbarkeit von KI-Rankings in den Fokus. Wir werfen zudem einen Blick auf den Web Almanac 2025 und zeigen, wie ihr eure SEO-Workflows mit Custom GPTs und „Sub-document Processing“ auf das nächste Level hebt.

Viel Spaß beim Lesen!

Google News

#01 Google Chrome jetzt auch als KI-Agent nutzbar

Wer Google mal für sich arbeiten lassen wollte, der kann dies durch ein neues Update im Browser Chrome tun. In jedem Tab kann jetzt ein neues Panel an der Seite geöffnet und dort Gemini eine Aufgabe erteilt werden – recherchieren, eintragen, einkaufen usw.

Wozu kann man den Agenten einspannen?

Google nennt Beispiele wie Texte über verschiedene Tabs hinweg vergleichen, unterschiedliche Gegenstände von einem Foto für ein bestimmtes Budget einkaufen, sich Produktrezensionen von verschiedenen Domains zusammenfassen lassen oder Kalendermanagement. Das geht mit der neuen “auto browse”-Funktion und kann sogar noch personalisiert werden, indem man den Browser mit anderen Google Apps verknüpft.

Zudem ist Nano Banana hier direkt integriert, sodass man direkt im Browser Bilder umwandeln kann, ohne sie herunterladen zu müssen.

Wichtig fürs Marketing:

Neben persönlicher Effizienzsteigerung ist es auch spannend, dass “auto browse” Schritt für Schritt dokumentiert, wie es vorgeht und auf welche Hürden es stößt. Lasst den Browser also mal auf eure Website los. So bekommt man kostenlos die Möglichkeit zu sehen, ob die eigene Website schon für das Zeitalter des Agentic Internets bereit ist.

#02 Googles Wachhund gegen Scraper

Durch das gerichtliche Verfahren von Google gegen SerpAPI konnte Search Engine Land rekonstruieren, wie Google SearchGuard funktioniert. Dieses System erkennt seit Anfang letzten Jahres, welche Nutzende Bots sind, die nur die Suchergebnisse von Google abgreifen möchten. Für die Erkennung werden überraschend kleinteilige Faktoren genutzt und getrackt wie Mausbewegung, Anschlag-Rhythmus der Tastatur, Verhalten beim Scrollen, Zeitintervalle zwischen Interaktionen sowie Browser-Settings.

Wichtig für SEOs:

Wer selbst Google-Suchergebnisse scrapt oder Tools dafür nutzt, dem sollte bewusst sein, wie schwer Google es Bots mittlerweile macht. Google SearchGuard ist ein scharfer Wachhund, was Auswirkungen auf die Zuverlässigkeit und Kosten von gescrapten Suchdaten hat.

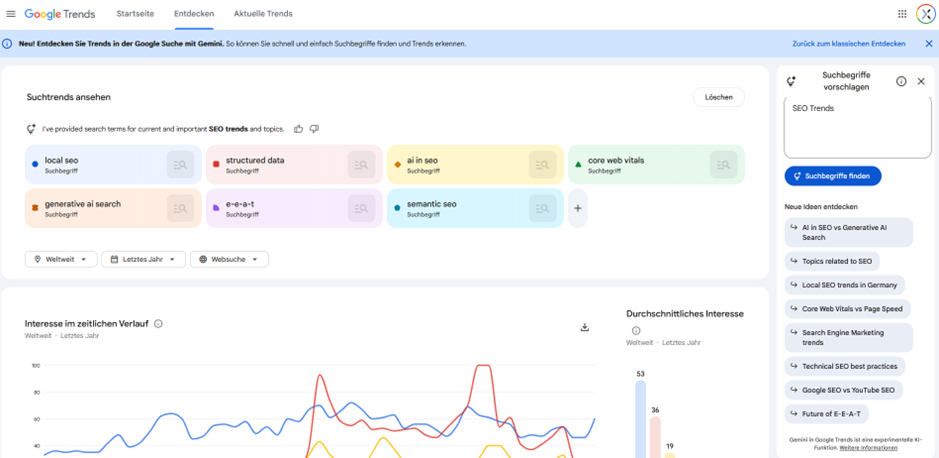

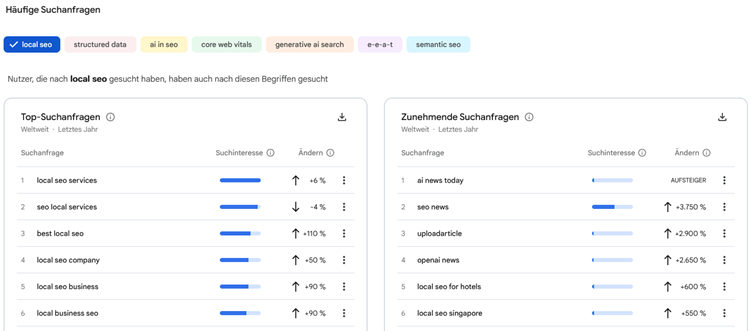

#03 Google Trends’ Hochzeit mit Gemini

Google Trends hat ein KI-Update erhalten und kann jetzt gewinnbringender für Keyword- und Themen-Recherchen verwendet werden. Die aktualisierte ‚Entdecken‘-Seite verfügt über eine neue Seitenleiste, durch die Gemini Suchbegriffe zu relevanten Themen und Trends vorschlagen und vergleichen kann. Zudem erhaltet Ihr personalisierte Prompt-Vorschläge, die bei vertiefenden Recherchen hilfreich sein können.

Oben und Unten: Screenshots aus dem neuen Google Trends.

Online Marketing News

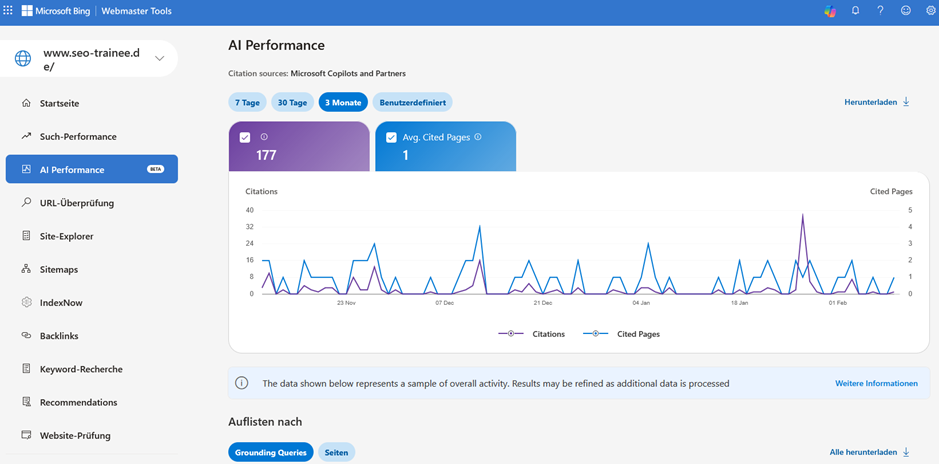

#01 Neuer ‘AI Performance’-Report in Bing Webmaster Tools

Was Search Engine Land zunächst als Test sah, ist inzwischen Live. In den Bing Webmaster Tools kann man jetzt eine Beta-Version für “AI Performance” finden.

Enthaltene Kennzahlen (Was gemessen wird)

- Zitationen (Citations): Anzahl der Erwähnungen der Website in KI-Antworten von Microsoft Copilot und dessen Partnern.

- Zitierte Seiten: Die genaue Anzahl und Auswahl der spezifischen URLs, die als Quelle herangezogen wurden.

- Grounding Queries: Die Suchbegriffe, so wie Bing sie interpretiert (nicht zwingend die exakte Eingabe der Nutzer*innen), die zur Zitation führten.

- Nutzerintention (Intent): Im Test gab es auch Informationen, ob die Anfrage informativer, navigationsorientierter oder sonstiger Natur war. Dies konnten wir noch nicht reproduzieren.

Die entscheidende Lücke

- Keine Klickdaten: Der Report zeigt zwar die Sichtbarkeit (Zitate), aber keine Klicks oder CTR-Werte. Publisher*innen sehen also weiterhin nicht, wie viel Traffic tatsächlich aus der KI-Suche auf ihre Website fließt.

- Keine Verbindung von Grounding Queries und zitierten URLs: Aktuell wird in den Bing Webmaster Tools leider nicht angezeigt, welche URLs für welche spezifischen Grounding Queries angezeigt werden.

Bedeutung für die Branche

- Fortschritt mit Beigeschmack: Während der Report erste Einblicke in die Performance innerhalb von KI-Systemen im Microsoft-Kosmos gibt und dadurch erste datengestützte GEO-Analysen ermöglicht werden, fehlen weiterhin wichtige Daten. Hier wird hoffentlich nachgearbeitet. Zudem bringt es vielleicht andere KI-Anwendungen dazu, ähnliche Daten zugänglich zu machen.

Beispiel der “AI Performance” in den Bing Webmaster Tools für seo-trainee.de

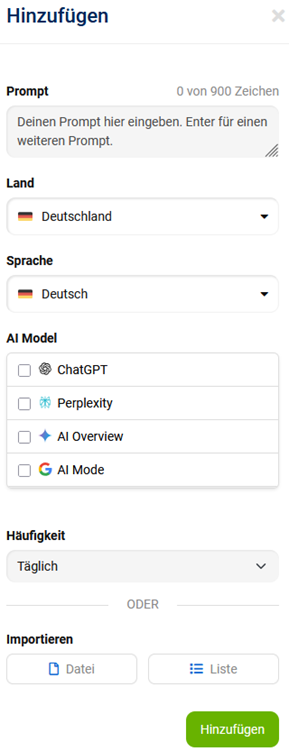

#02 SISTRIX-Update: Connector Looker Studio & Google AI Mode tracken

SISTRIX hat über LinkedIn Bescheid gegeben, dass es einen neuen Connector aller APIs des SEO-Tracking-Tools zum Google Looker Studio gibt.

Es ist jetzt also leichter, individuelle SEO-Reports im Looker Studio mit SISTRIX-Daten anzureichern.

Außerdem kann jetzt neben ChatGPT, Perplexity und den AI Overviews auch der AI Mode von Google im Prompt-Monitoring von SISTRIX getrackt werden. Auch für diese KI-Anwendung werden jetzt also ein individueller KI-Sichtbarkeitsindex, Informationen zu Wettbewerbern und Sentiment-Werte ausgegeben.

Screenshot vom Einrichten des Prompt-Monitorings in SISTRIX

#03 Marketing-Potenziale über den Tellerrand hinaus: Digg & Yahoo Scout

Ihr sucht nach bisher wenig bespielten Marketing-Kanälen online? Dann sind folgende Kandidaten etwas für euch:

- Digg ist ein Reddit-Klon, der Toxizität und dem Problem von Bot-Accounts den Kampf angesagt hat. Um die Identität der Nutzer*innen sicher zu verifizieren, setzt die Plattform auf KI, die öffentlich zugängliche Daten findet und auswertet. Informationen aus Reddit werden aktuell gerne von KI-Anwendungen zitiert. Sollte Digg sich als vertrauenswürdigere Alternative positionieren können, wären bereits gepflegte Communitys für Markenthemen auf dieser Platzform sehr wertvoll für GEO.

- Yahoo is back! Mit Yahoo Scout steigt die ehemalige Suchmaschinen-Größe in den KI-Antwortmaschinen-Markt ein. Die Anwendung soll auf Yahoo-eigenen Daten und Erfahrungen basieren, wird aber als Basis-Modell Anthropics Claude und die Grounding-API von Microsoft Bing nutzen. Es bleibt abzuwarten, ob Yahoo es schafft, sich einen Platz unter den viel genutzten KI-Antwortmaschinen einen Platz erkämpfen kann, aber wenn ja, dann sollte man auch hier tracken, wie die eigene Marke wahrgenommen und dargestellt wird.

KI-News

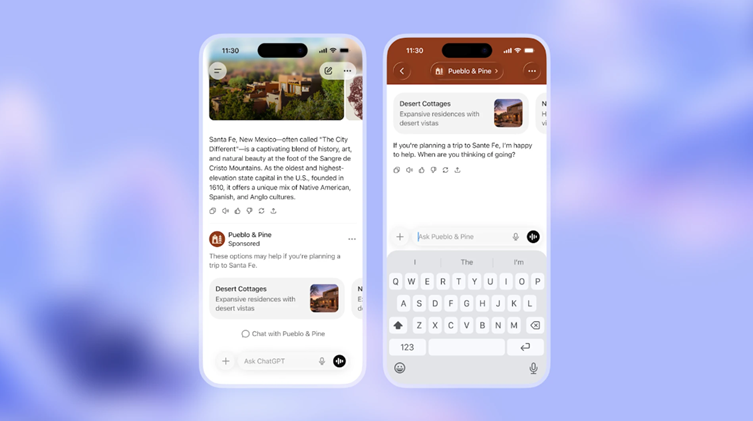

#01 ChatGPT führt Werbung ein

OpenAI leitet eine neue Ära ein und bringt erstmals Werbung in den kostenlosen Free- Tarif und den neuen Budget-Plan ChatGPT Go. Dieser Schritt dient vor allem dazu, die immensen Betriebskosten für Rechenzentren zu decken. Hinter der strategischen Entscheidung steht zudem die Notwendigkeit, Investore*innen ein belastbares und gewinnbringendes Geschäftsmodell zu präsentieren. OpenAI muss beweisen, dass sich die Milliarden-Investitionen in die Infrastruktur langfristig nicht nur durch Abos, sondern auch durch skalierbare Werbeeinnahmen amortisieren.

In den kommenden Wochen startet ein Testlauf für volljährige Nutzer*innen in den USA, bei dem Anzeigen am Ende der Antworten erscheinen. Dabei gleicht das System Konversationsthemen mit den Angeboten der Werbetreibenden ab, um passende Empfehlungen auszuspielen. Sucht ihr beispielsweise nach neuen Rezepten, könnte ChatGPT euch gezielt Anzeigen für Kochboxen oder Lebensmittellieferungen vorschlagen. Für Marketer*innen ergeben sich hierdurch präzise Targeting-Optionen direkt am Point of Intent, da Anzeigen basierend auf der aktuellen Konversation und dem Nutzerprofil ausgewählt werden.

Laut OpenAI müsst ihr keine Sorge um die Neutralität eurer KI haben:

- Unabhängigkeit: Die Antworten werden weiterhin objektiv nützlich generiert und niemals durch Sponsoring beeinflusst.

- Datenschutz: Eure privaten Unterhaltungen werden weder an Werbetreibende verkauft, noch haben diese Zugriff auf eure Chat-Verläufe.

- Kontrolle: Ihr könnt die Personalisierung jederzeit deaktivieren und genutzte Werbedaten löschen.

- Keine Werbung bei sensiblen Themen: Bei Inhalten rund um Politik oder physische und psychische Gesundheit bleibt der Chat werbefrei.

Dennoch bleibt die kritische Frage: Wie neutral kann eine KI wirklich bleiben, wenn sie zum Werbeträger wird? Aus unserer Sicht droht ein Interessenkonflikt zwischen Nutzerhilfe und Profitmaximierung. Wenn ihr etwa nach der „besten Laufschuh-Dämpfung“ fragt, könnte die KI geneigt sein, Marken technologisch hervorzuheben, die gleichzeitig hohe Anzeigenbudgets investieren. Ein schleichender Bias verwässert so die Objektivität, um Werbepartner nicht vor den Kopf zu stoßen.

Ignoriert ihr diese Entwicklung im Bereich Search Generative Experience, verpasst ihr die Chance, eure Marken in neuen, gesprächsbasierten Formaten zu platzieren, die über statische Links hinausgehen.

Werbung in ChatGPT, Quelle: openai.com

#02 KI-Sichtbarkeit: Warum klassische Rankings bei ChatGPT und Google AI versagen

Die Jagd nach „Platz 1“ in KI-Antworten ist laut einer Studie von Rand Fishkin und Gumshoe.ai eine Illusion. KIs agieren als „Probability Engines“, deren Ergebnisse bei jeder Anfrage neu gewürfelt werden. Wenn ihr denselben Prompt 100-mal laufen lasst, ist die Chance, zwei identische Listen zu bekommen, unter 1 %.

Diese Inkonsistenz macht herkömmliches Tracking fast unmöglich:

- Zufällige Reihenfolge: Die Wahrscheinlichkeit für exakt gleiche Platzierungen liegt bei unter 1 zu 1.000.

- Variable Listenlänge: Die Anzahl der genannten Marken schwankt pro Durchgang massiv.

- Keine Empfehlungs-Garantie: Empfehlungslisten sind nicht deterministisch und kaum zuverlässig vorhersagbar.

Ein Tool, das feste „Rankings“ ausgibt, liefert daher wertlose Daten. Ein Krankenhaus erschien im Studien-Test zwar in 97 % der Antworten, belegte aber nur in 25 von 100 Fällen den ersten Platz.

Die Lösung: Sichtbarkeitsrate statt Platzierungen

Die verlässliche Metrik für eure Strategie ist die Sichtbarkeitsrate („Visibility“). Trotz Würfelprinzip tauchen starke Marken über Hunderte Durchläufe hinweg konsistent auf, da die KI den Kern-Intent meist korrekt erfasst.

Für euch heißt das:

- Stoppt Tracking von Einzelplatzierungen: Diese Metrik ist statistisch nicht belastbar.

- Nutzt aggregierte Daten: Wiederholt Anfragen 60- bis 100-mal, um valide Werte zu erhalten.

#03 Microsoft PCM: Monetisierungschance für redaktionelle Inhalte

Microsoft hat den Publisher Content Marketplace (PCM) gestartet, um Publisher*innen eine faire Vergütung für ihre Inhalte im KI-Zeitalter zu ermöglichen. Über diesen Marktplatz könnt ihr eure Texte für die Nutzung durch KI-Systeme lizenzieren und so eine neue Einnahmequelle erschließen. Die Vergütung erfolgt dabei nutzungsabhängig, etwa wenn der Microsoft Copilot eure Beiträge für das Grounding einer Antwort heranzieht.

Das System bietet euch klare Vorteile:

- Einfacher Zugang: Sowohl große Medienhäuser als auch kleine Publisher*innen können ohne individuelle Einzelverträge teilnehmen.

- Volle Kontrolle: Ihr legt die Bedingungen für die Bereitstellung eurer Inhalte selbst fest.

- Transparente Daten: Ein Reporting gibt euch Einblicke in die Nutzung und Leistung eurer Inhalte.

Ignoriert ihr diese Entwicklung, verpasst ihr die Chance, den Traffic-Verlust durch Zero-Click-Suchen finanziell auszugleichen. Aus unserer Sicht ist PCM ein spannender Ansatz, um das Dilemma zwischen hochwertigem Content und fehlender Kompensation zu lösen. Dennoch müsst ihr kritisch prüfen, ob die Erlöse die sinkenden Werbeeinnahmen eurer eigenen Websites langfristig ersetzen können.

Tipps des Monats

#01 Perplexity AI: Vom klassischen Dokument-Ranking zum AEO-Zeitalter

Das Interview mit Jesse Dwyer von Perplexity AI verdeutlicht, dass die KI-Suche keine starre Rangliste mehr ist. Anders als bei der klassischen Suche erhalten zwei Nutzer*innen bei identischen Anfragen oft völlig unterschiedliche Antworten, da persönliche Kontextdaten direkt in das „Context Window“ geladen werden. Für eure SEO-Strategie bedeutet das: Ein einziges, universelles Ranking-Ergebnis gehört der Vergangenheit an.

Der technische Kern der Perplexity-Antworten liegt im Wechsel von Whole-document zu Sub-document Processing:

- Keine ganzen Seiten werden bewertet: Statt komplette Dokumente zu bewerten, zerlegt Perplexity Inhalte in winzige Snippets von zwei bis vier Wörtern.

- Kontext-Sättigung: Die Engine füttert die KI mit ca. 26.000 dieser Schnipsel, um ihr „Kurzzeitgedächtnis“ (Context Window) so mit Fakten zu fluten, dass kein Platz mehr für Erfindungen (Halluzinationen) bleibt.

- Auswahl-Logik: Nur Inhalte, die als relevante Snippets extrahiert werden, landen in der Antwort.

Die zentrale Implikation: Wenn eure Inhalte nicht snippet-tauglich auffindbar sind, sinkt die Chance, als Quelle/Fragment in Antworten aufzutauchen. Wir empfehlen daher, Inhalte durch Semantic Chunking so strukturieren, dass jeder Absatz als eigenständiges Informations-Häppchen für die KI funktioniert. Nur so stellt ihr sicher, dass eure Fakten extrahiert und als Baustein in personalisierten Antworten genutzt werden können.

#02 SEO-Fakten & Trends: Web Almanac & Sistrix Index Watch 2025

Der neue Web Almanac 2025 zeigt deutlich: Die technische Basis wird im KI-Zeitalter zur Pflicht. Inzwischen nutzen 50 % aller Websites strukturierte Daten (vor allem JSON-LD), um nicht nur von Bots gefunden, sondern von KI-Systemen oder dem Google AI Mode verstanden zu werden. Ein spannendes Highlight: Die gezielte Steuerung von AI-Crawlern in der robots.txt (z. B. GPTBot) hat sich seit dem Vorjahr fast verdoppelt – wir SEO-Expert*innen nutzen das File heute also mehr als „Statement of Intent“ für Content-Berechtigungen denn als reinen Crawler-Schutz.

Parallel liefert der Sistrix Index Watch 2025 die Gewinner des Jahres: YouTube und Reddit dominieren absolut, während die Deutsche Börse durch eine meisterhafte Migration zur stärksten relativen Aufsteigerin wurde (+1.170 %). Auf der Verliererseite zeigt sich: Wer bei Konsolidierungen (wie ProSieben auf Joyn) auf 1:1-Weiterleitungen verzichtet und Inhalte auf „Sammelseiten“ leitet, verliert massiv an Sichtbarkeit.

#03 Custom GPTs: Turbo für eure SEO-Workflows

Eigene GPT-Modelle helfen euch dabei, wiederkehrende Aufgaben in strukturierte Workflows zu verwandeln und so deutlich schneller ans Ziel zu kommen. Anstatt Dashboards oder Audits komplett zu ersetzen, übernehmen diese „spezialisierten Helfer“ den ersten Analysedurchlauf und machen Muster sichtbar.

Hier sind die besten Einsatzbereiche für eure tägliche Arbeit:

- Analyse & Technik: Erstellt GPTs für Wettbewerbs-Analysen (besonders effektiv mit verbundenen Tool-Daten aus Semrush oder Ahrefs sowie eigenen Reports) oder regelmäßige technische SEO Checks, um z. B. Probleme bei Core Web Vitals oder Fehler in der Search Console sofort zu identifizieren.

- UX & Content: Ein UX GPT (gefüttert mit guten UX-Artikeln oder auch einer Team-Dokumentation mit Vorgaben) prüft eure Seiten auf Basis interner Design-Regeln, während ein SERP Analyzer Screenshots mit Live-Ergebnissen vergleicht.

- Präsentationen: Auch wenn die KI noch keine fertigen Slides erstellt, liefert sie euch strukturierte Inhalte wie Header und prägnante Takeaways für eure Slide Decks. Durch die Kombination von Daten aus anderen spezialisierten GPTs erstellt ihr so im Handumdrehen fundierte Zusammenfassungen z. B. zum Seitenstatus inklusive passender Grafikvorschläge.

Ignoriert ihr diese Möglichkeiten, verliert ihr wertvolle Zeit durch manuelle Routineaufgaben, die KI bereits effizient lösen kann. Da KI zum „Schwafeln“ neigt, solltet ihr strikte Formatvorgaben machen und eure Rollen sowie Zielgruppen vorab präzise definieren. Mehr Beispiele für Custom GPTs und konkrete Prompts findet ihr hier.