Das aktuellste Google Core Update, welches im Juni durchgeführt wurde, hatte gravierende Auswirkungen auf die Sichtbarkeitswerte einiger Websites. Eine besonders hitzige Diskussion wurde in Bezug mercola.com entfacht, einer Website rund ums Thema Alternativmedizin. Holt Euch in unserem heutigen Top-Thema einen Einblick in die Diskussion.

Mercola.com und das Google Core Update

Was ist passiert?

Seit dem Google Core-Update im Juni hat die Website mercola.com einen herben Sichtbarkeitsverlust zu verzeichnen. Ein Großteil der organischen Rankings für Non-Brand-Keywords sind weggebrochen, was die Sichtbarkeitsentwicklung im US-Index eindrucksvoll verdeutlicht:

Was wird Google vorgeworfen?

Der namensgebende Chef hinter mercola.com, der Alternativmediziner Joseph Mercola, wirft via Video-Botschaft Google Zensur vor und interpretiert den Sichtbarkeitsverlust seiner Website als Teil eines großangelegten Angriffs auf die Freiheit von Meinung und Wissenschaft. Google treibe die Agenda seiner Geldgeber voran, etwa der Pharma-Lobby. Unterstützt vom Gründer und den anonymen Redakteuren von Wikipedia, die bekannt dafür seien, „extreme Vorurteile gegen Inhalte rund um Naturheilkunde zu haben“, würden die Rankings von Inhalten mit unliebsamen Sichtweisen systematisch gesenkt.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Diese Verschwörung wurde von unterschiedlichen Medien aufgegriffen. Ein bemerkenswerter Beitrag wurde z. B. auf kopp-report.de veröffentlicht. Unter dem Titel „Eilmeldung: Google entfernt Websites über Naturheilkunde aus seinen Suchergebnissen – ein Whistleblower sagt, wie und warum“. Dort heißt es, dass der investigative Reporter James O’Keefe, Gründer von Projekt Veritas, am selben Tag des Mercola-Berichts einen Beitrag veröffentlicht hat, in dem u.a. die Vorwürfe von Joseph Mercola belegt würden. In diesem Bericht packt ein „Top-Google-Führungsmann und Whistleblower“ darüber aus, in welchem Umfang Google die Sucherergebnisse manipuliere und dabei einer fragwürdigen Agenda folge.

Was ist von den Vorwürfen zu halten?

In verschiedenen Artikeln wurde der Fall Mercola kritisch thematisiert. Lesenswerte Beiträge dazu finden sich z. B. auf SearchEngineJournal und SEO Südwest. Gerade im SearchEngineJournal-Artikel werden der Vorwürfe Mercolas bezüglich der Allianz von Wikipedia und Google als nicht zu belegen und mindestens unwahrscheinlich überführt.

Aus unserer Sicht ist dieses Thema in Zeiten von Fake News, Medienschelte und alternativen Wahrheiten in doppelter Hinsicht spannend: Zum einen ist die Frage, ob und wie eine Suchmaschine wie Google es hinbekommt, die Reputation und Glaubwürdigkeit von Inhalten einigermaßen stimmig zu bewertet und im Suchalgorithmus zu berücksichtigen. Wäre Google hier transparenter, hätten es Verschwörungstheorien nicht mehr ganz so leicht. Zum anderen ist die Frage spannend, ob Google seine Ergebnisse überhaupt derart kuratieren sollte. Wie man dazu steht, das hängt bei jedem sicher stark von den individuellen Vorlieben, Meinungen und Weltanschauungen ab: Auf der einen Seite hat Google vielleicht eine Verantwortung, nicht jedem Aluhut-Träger eine prominente Plattform auf Seite 1 zu bieten. Auf der anderen Seite haben solche Eingriffe das Potenzial, Meinungen zu beeinflussen und zu lenken.

Dass kopp-report.de den Mercola-Fall aufgegriffen hat, zeigt darüber hinaus, wie schnell und dankbar solche Themen benutzt werden, um eine ganz eigene Agenda zu verfolgen: kopp-report.de gehört zum Kopp Verlag, der mit Verschwörungstheorien sein Geld verdient. Mit Buchtiteln wie „Werde übernatürlich“, „Geheime Weltraumprogramme und Allianzen mit Außerirdischen“ oder „Bevölkerungsaustausch in Europa“ wünscht sich so ein Verlag – freundlich formuliert – natürlich eine gewisse Vielfalt in den Suchergebnissen. Dass auch der Enthüllungsbericht von Projekt Veritas mit Vorsicht zu genießen ist, davon könnt Ihr Euch u.a. in diesem Deutschlandfunk-Artikel überzeugen.

Was meint Ihr dazu?

Soll Google bloß die Finger davon lassen entscheiden zu wollen, was wahr ist und was falsch? Oder ist es wichtig und richtig, dass Google Website-Inhalte nach solchen Kriterien bewertet? Schreibt uns Eure Meinung in die Kommentare!

Google-News

- Nach 25 Jahren wird das Robots Exclusion Protocol offiziell zum Internetstandard: Diese Nachricht wurde in einem von Gary Illes, Henner Zeller und Lizzi Harvey geschriebenen Blogpost veröffentlicht. Die grundlegenden Regeln unterscheiden sich zwischen dem nun im IEFT aufgenommenen Dokument und dem damals (1994) festgelegten Konzept größtenteils nicht. Das neue Dokument gibt nun aber über bisher undefinierte Szenarien Aufschluss. Die drei Autoren benennen vier Punkte:

- Alle URI basierten Protokolle können robots.txt verwenden.

- Entwickler müssen mindestens die ersten 500 Kilobytes einer robots.txt parsen.

- Die neue maximale Caching-Obergrenze liegt bei 24 Stunden.

- Wird eine robots.txt inaktiv und steht Crawlern nicht mehr zur Verfügung, werden zuvor festgelegte Disallowed-Seiten für einen „angemessenen“ Zeitraum weiterhin nicht beim Crawling berücksichtigt.

- Änderungen der robots.txt-Regelungen: Einen Tag nach der Veröffentlichung über die Aufnahme des Robots Exclusion Protocolls in IEFT erschien ein weiterer wichtiger Google-Blogpost zu diesem Thema. Es wird der Support von einigen Regeln zum 01. September 2019 abgeschafft, da sie gemäß Google nur zu 0,001 % in robots.txt-Dateien verwendet würden. Gary Illes benennt drei Regeln, die abgeschafft werden:

- Crawl-delay

- Nofollow

- Noindex

Stattdessen werden ab dem 01. September 2019 die folgenden Regeln offiziell in Kraft treten:

- Noindex in Robots Meta Tags: In dem Head-Bereich kann ein HTML-Code-Element gesetzt werden, um URLs effektiv von einer Indexierung auszuschließen.

- 404 und 410 HTTP-Statuscodes: URLs mit diesen Statuscodes werden, nachdem sie einmal gecrawlt wurden, beim darauffolgenden Crawl von einer Indexierung ausgeschlossen.

- Passwortschutz: Wenn kein Markup für Seiten hinterlegt ist, die bezahl- oder abopflichtige Inhalte enthalten, werden diese Seiten vom Index ausgeschlossen.

- Disallow in Robots.txt: Seiten, die mittels disallow blockiert sind, werden weder gecrawlt noch indexiert. Die Ausnahme ist hier, wenn diese Seiten verlinkt werden. An dieser Stelle wird bestätigt, dass Google diese Seiten aber kaum anzeigen wird.

- URLs entfernen mit der Search Console: Das URL Removal Tool wird empfohlen, um URLs aus den SERPs vorübergehend zu entfernen.

- GIFs in der Google-Bildersuche: Die Dateien werden über die Plattform Tenor.com zur Verfügung gestellt, die Google im letzten Jahr erworben hatte. Zudem können die GIFs über Apps wie WhatsApp, Gmail, Hangouts und Android Messages geteilt werden. Wenn Ihr GIFs hochladen möchtet, könnt Ihr dies direkt über Tenor oder über dieses Formular tun.

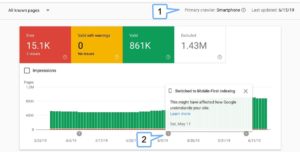

- Zwei neue Features in der Search Console: Auch in dieser Woche können wir über zwei neue Funktionen in der Google Search Console berichten:

-

-

-

- Es wird nun angezeigt, welcher Google Bot Eure Seiten als letztes gecrawlt hat. Auf diese Weise sollen Website-Betreiber möglichst transparent sehen können, ab wann beziehungsweise ob eine Domain mit dem mobilen Google Bot gecrawlt wurde und ob dies Auswirkungen auf die Leistungswerte gehabt hat, so Google Webmasters auf Twitter.

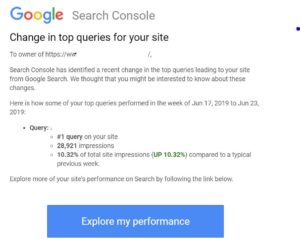

- Eli Schwartz twitterte, dass nach seinen Beobachtungen nun die Search Console auch Benachrichtigungen verschickt, wenn sich die Top-Suchanfrage einer Domain ändert.

-

-

- So steht Google zu White Label Sites: In dem letzten Webmaster-Hangout hat John Mueller eine Nutzerfrage zu diesem Thema beantwortet. Das White-Label-Prinzip basiert generell darauf, dass ein Produkt oder ein Service von einem Anbieter auf einer Partnerseite platziert wird. Es ist üblich, dass die Inhalte sich in der Regel nicht großartig von den Inhalten der Partnerseite unterscheiden, sodass der Nutzer den Hersteller nicht wirklich identifizieren kann. Google beobachtet diese Vorgehensweise und nimmt sie sehr ernst. Gleichzeitig bestätigt Mueller, dass Google aber keine mustergültige Herangehensweise hat, wie mit Inhalten dieser Art umgegangen werden soll. Der Content der Partnerseite kann nicht als richtiger Spam bezeichnet werden. Auf der anderen Seite sagt Mueller, dass die Inhalte der Partnerseiten oft geringere Qualität haben als der Inhalt der originalen Seiten. Dies kann wiederum Auswirkungen auf die Qualitätsbewertung der jeweiligen Partnerseite haben. Google schaut sich dabei die Inhalte einer gesamten Domain an. Bevor Produkte oder Services auf einer Partnerseite platziert werden, solltet Ihr auf jeden Fall prüfen, ob die Hauptinhalte der Seite dazu passen.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Vermischtes

- LinkedIn überarbeitet seinen Algorithmus: Onlinemarketing.de berichtet über eine Anpassung des LinkedIn-Algorithmus. Demnach werden personalisierte Inhalte für Nutzer vorangestellt. Erfahrt in dem Artikel was sich konkret geändert hat. Zudem berichtet Search Engine Journal, dass CTA-Buttons nun in fünf unterschiedlichen Optionen angelegt werden können. Zudem gibt es neue Dashboards, mit denen Admins die Leistungswerte zu den CTA-Buttons besser analysieren können. Welche Änderung es noch gab, könnt Ihr ebenfalls im Artikel nachlesen.

- Werbeinvestitionen in sozialen Medien sinken stark: Dies berichtete der Digitalkindergarten und bezieht sich damit auf eine Studie des britischen Marktforschungs- und Beratungsunternehmens WARC.

- Deutsche Post veröffentlicht Dialogmarketing-Monitor: Die Studie zeigt, dass der Werbemarkt generell in Deutschland schrumpft. Der Bereich Suchmaschinen-Optimierung sei aber um 0,3 Mrd. Euro gewachsen und umfasst ein aktuelles Volumen von 4,2 Mrd. Euro. Ladet Euch die Studie herunter, um alle Insights lesen zu können.

- Yoast veröffentlicht Definition zu Soft-404-Fehler: Auf der einen Seite gibt es 404-Fehler. Diese Seiten sind nicht erreichbar und es wird der entsprechende HTTP-Statuscode vom Server an den Browser übermittelt. Bei dem 404-Soft-Fehler hingegen übermittelt der Server einen 200er HTTP-Statuscode. Der Google Bot ordnet der Seite aber einen 404-Statuscode zu. Dies kann passieren, wenn beispielsweise keine Inhalte auf der Seite vorhanden sind. In dem Yoast-Artikel wird auf den Unterschied im Detail eingegangen. Zudem wird berichtet, wie Ihr solche Soft-Fehler beheben könnt.

Unsere Tipps der Woche

- Neue Mythbusting-Folge zu Frameworks: Martin Splitt geht gemeinsam mit dem Senior Web Developer Jason Miller auf Herausforderungen zu diesem Thema ein und welche Auswirkungen Frameworks auf SEO haben können. Viel Spaß beim Ansehen!

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

- Feuerwerk in der Google-Suche: Welcher Mensch mag kein Feuerwerk?! Epic Fireworks twitterte, dass man mit der Suchanfrage „fireworks“ bei Google seine ganz private Feuerwerksvorstellung auf mobilen oder Desktopgeräten erleben kann. Viel Spaß dabei!

Eine Antwort

Fun fact, der Artikel vom Kopp-Verlag, das Google ach so böse ist, wurde mir im Google-Assistent angezeigt.

Ein bisschen belustigt auf deren Webseite rumgeklickt, nun meint Google ich interessiere mich dafür und zeigt mir Werbung von Rentrop, Kopp und Co an. Und böse wie ich bin klicke ich nun öfters mit Schadenfreude auf solche Werbung, finanziere damit die Blogs die ich lese und schädige die Alternativ-rechten-Aufklärer, eindeutig eine win-win-Situation 🙂