Für den heutigen Mittwoch haben wir uns überlegt, für all jene eine Einführung in die Webmaster-Tools von Google zu geben, die nicht mit auf die dmexco fahren konnten. Wer diese Grundlage beherrscht, beherrscht auch bald den Rest der SEO-Basics und ist im nächsten Jahr auf jeden Fall dabei! 🙂

Google bietet mit den Webmaster-Tools ein Werkzeug an, das jeder Webmaster nutzen sollte. Nicht nur, dass Google wertvolle Informationen zur Webseite ausgibt, es werden auch Probleme aufgezeigt, auf die der Google-Crawler beim Durchlaufen der Seite stößt. Mit Problemen meine ich beispielsweise Seiten, die nicht indexiert werden, oder Seiten, die einen 404er-Status zurückgeben.

Google-Webmaster-Tools: die ersten Schritte

Um die Webmaster-Tools nutzen zu können, wird ein Google-Benutzerkonto benötigt. Wer bereits über ein Google-Konto verfügt, kann direkt loslegen und seine Webseite zur Bearbeitung bzw. Analyse anlegen.

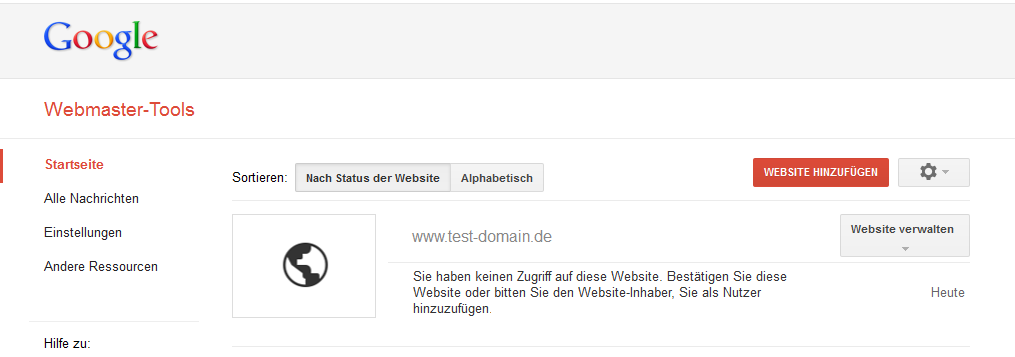

Auf der Startseite der Webmaster-Tools befindet sich ein Button, über den man seine Webseite hinzufügen kann.

![]()

Bevor jedoch sinnvolle Daten geliefert werden, muss zuerst die Inhaberschaft der Seite bestätigt werden. Ähnlich wie bei Google-Analytics bietet Google hier verschiedene Verfahren an:

- HTML-Datei muss auf den Webserver hochgeladen werden

- Meta-Tag muss zur Startseite hinzugefügt werden

- Google Analytics -> Sollte bereits ein Analytics-Konto für die Webseite bestehen, reicht dies zur Verifizierung aus

Nach erfolgreicher Verifizierung der Webseite kann es auch schon losgehen.

Webmaster-Tools: Dashboard

Nachdem wir unsere Webseite angelegt und erfolgreich verifiziert haben, gelangt man mit einem Klick auf den Domain-Namen direkt in das Dashboard der Webmaster-Tools.

Hier erhält man die wichtigsten Informationen zu der Webseite auf einen Blick. Besondere Beachtung haben hier die Nachrichten und kritischen Fehler verdient. Google informiert hier beispielsweise die Webmaster über Verstöße gegen die Google-Guidelines oder kritische Fehler. Nicht Beachtung kann dazu führen, dass die gesamte Seite oder auch einzelne Teile der Webseite nicht mehr indexiert werden. Man sollte die Nachrichten also stets im Blick haben, um auf eventuelle Nachrichten seitens Google schnell reagieren zu können.

TIPP: In den Konto-Einstellungen lassen sich auch E-Mail-Adressen eintragen, an die eine Meldung versendet wird, sollte eine neue Nachricht vorliegen.

Ebenso auf dem Dashboard befinden sich die Crawling-Fehler: Hier erhält man Details zu den URLs, die Google nicht erfolgreich crawlen konnte oder die einen http-Fehlercode zurückgeben.

Neben den Crawling-Fehlern liefert Google noch ein Linien-Diagramm zu den Impressionen bzw. Klicks der Suchanfragen in den letzten 30 Tagen.

Letzter Punkt auf dem Dashboard ist XML-Sitemaps: Hier wird angezeigt, wie viele der bereits eingereichten URLs sich im Google-Index befinden.

Webmaster-Tools: Konfiguration

Einstellungen:

In dem Bereich Einstellungen finden sich einige grundlegende Einstellungen, die mit wenig Aufwand abzuhaken sind.

Geografisches Ziel –>

Sollten die Inhalte eurer Webseite auf Nutzer einer bestimmten Region ausgerichtet sein, kann diese hier festgelegt werden. Google kann anhand der geografischen Ausrichtung die Inhalte in den Suchergebnissen verbessern. In der Regel ist eine Anpassung nur notwendig, wenn es sich um eine Domain mit einer neutralen Top-Level-Domain wie .com oder .org handelt. Ist keine Ausrichtung gewünscht, gibt es die Möglichkeit den Eintrag „Nicht gelistet“ zu wählen.

Bevorzugte Domain –>

Die Wahl einer bevorzugten Domain, sollte man auf keinen Fall ignorieren, auch wenn die Vorgehensweise etwas merkwürdig erscheint.

Bevor die Einstellungen an dieser Stelle anpasst werden können, müssen wir einen Schritt zurückgehen. Nämlich auf die Startseite, wo wir am Anfang die Domain eingetragen haben, diese erreicht man durch einen Klick auf „Webmaster-Tools“ oberhalb des Menüs.

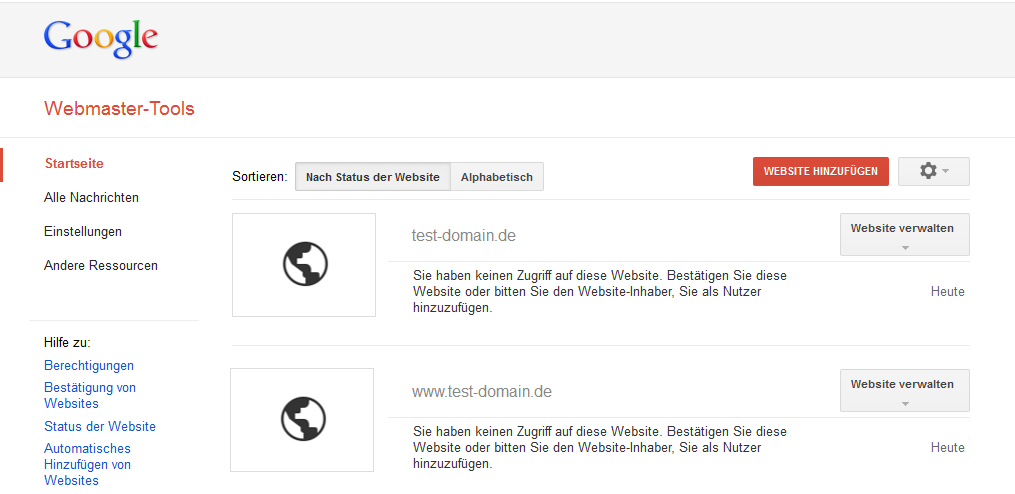

Um festlegen zu können, ob die Variante mit www. oder ohne www. unsere bevorzugte Domain ist, muss als nächstes die Variante ohne www angelegt werden. Sodass am Ende beide Varianten als Webseite erscheinen.

Dieser Schritt ist notwendig, da Google sichergehen will, dass beide Domains demselben Inhaber zugeordnet sind. Sind beide Domains angelegt, genügt wieder ein Klick auf den Domainnamen, um zum Dashboard zu gelangen. Zurück in den Einstellungen kann festgelegt werden, welche Variante die bevorzugte Domain ist. In der Regel verwendet man hier die Variante mit www. Durch die Angabe wird Google mitgeteilt, dass nur diese bevorzugte Domain in den Suchergebnissen auftauchen soll. Selbst, wenn der Crawler einen Link findet, der ohne www. auf http://test-domain.de/eine-Seite-die-noch-nicht-indexiert-ist/ verlinkt, wird Google dieser Seite automatisch das www. hinzufügen.

Crawling-Geschwindigkeit –>

Google gibt Webmastern hier die Möglichkeit, selbst zu bestimmen, mit welcher Crawling-Geschwindigkeit Google Anfragen an den eigenen Server sendet. Die Crawling-Geschwindigkeit lässt sich auf Root- oder Subdomain-Ebene ändern. Eine neue benutzerdefinierte Crawling-Geschwindigkeit ist dann 90 Tage lang gültig. Im Normalfall sollte man hier nichts verändern, sondern Google überlassen, wie schnell die eigene Webseite gecrawlt wird.

Sitelinks

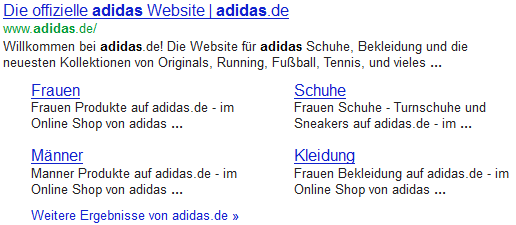

Wohl jeder hat die sogenannten Sitelinks schon mal gesehen. Google blendet Sitelinks nur ein, wenn sie als hilfreich für den Nutzer erachtet werden, beispielsweise um schneller an wichtige Informationen zu gelangen. Besonders häufig tauchen Sitelinks bei Brand-Suchanfragen auf, also bei der Suche nach einer bestimmten Marke, wie im obigen Beispiel „Adidas“. Die Webmaster-Tools bieten zwar nicht die Möglichkeit Sitelinks zu beantragen, aber sollten welche existieren können diese in einem gewissen Maße beeinflusst werden. Genauer gesagt können unpassende oder falsche Links abgewertet werden. Google versucht diese Angaben bei der Erstellung der Sitelinks zu berücksichtigen, es gibt jedoch keine Garantie, dass abgewertete URLs niemals als Sitelink angezeigt werden.

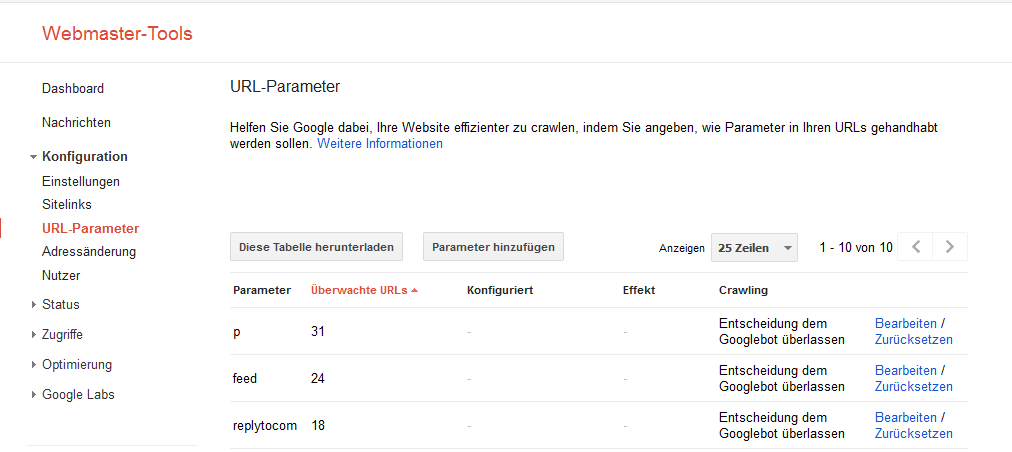

URL-Parameter

Durch die Verwendung von Parametern innerhalb der URL, wie beispielsweise einer Sitzungs-ID, können duplizierte Inhalte (Duplicate Content) entstehen. Treten duplizierte Inhalte im Google-Index auf, kann dies zur Folge haben, dass die Seite insgesamt in den Suchergebnissen schlechter abschneidet. Wenn Google beim Crawling duplizierte Inhalte findet, wie beispielsweise aufgrund von URL-Parametern entstandene Variationen, werden die doppelten URLs in einem Cluster gruppiert und es wird die URL ausgewählt, die nach Ansicht von Google am besten passt. Um dieses Verhalten zu beeinflussen, lassen sich bestimmte Angaben darüber machen, wie URLs mit bestimmten Parametern zu behandeln sind. An dieser Stelle ist Vorsicht angesagt, da eine falsche Angabe dazu führen kann, dass entsprechende Seiten nicht mehr indexiert werden.

Adressänderung

Mit dieser Option bietet Google den Webmastern eine bequeme und sichere Möglichkeit an, Google die neue Adresse mitzuteilen. Voraussetzung ist natürlich die Einrichtung der neuen Domain und deren Inhalte sowie eine korrekte Weiterleitung der alten auf die neue Domain. Zum Thema SEO-freundlicher Domain-Umzug gibt es auf seomoz eine sehr schöne Infografik.

Um die Adressänderung durchzuführen, muss zuerst die neue Domain als Webseite angelegt werden.

TIPP: Falls ihr eine bevorzugte Domain angegeben habt, sollte dies auch für die neue Website geschehen.

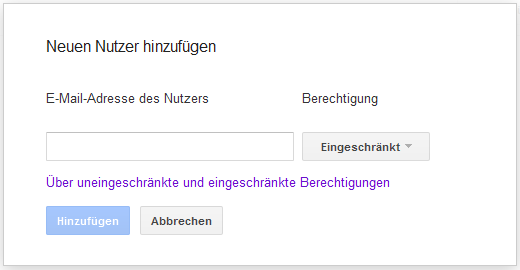

Nutzer

Sollten mehrere Personen an der Verwaltung einer Webseite beteiligt sein, bietet Google hier die Möglichkeit, weitere Benutzer hinzuzufügen. Dabei hat man die Option, zwei verschiedene Berechtigungsstufen („Eingeschränkt“, „Uneingeschränkt“) auszuwählen.

Die grundlegenden Konfigurationen der Webmaster-Tools sind jetzt abgeschlossen. Damit wir den Rahmen des Artikels nicht komplett sprengen, haben wir uns entschieden, an dieser Stelle einen Cut zu machen und noch einen zweiten Teil herauszubringen. Nachdem dieser Teil ausschließlich die grundlegende Konfiguration behandelt hat, wird es im zweiten Teil um die eigentlichen Funktionen und Informationen gehen, die man aus den Webmaster-Tools herausziehen kann.

Wenn ihr jetzt noch Lust auf mehr habt, dann schaut doch mal in den 2.ten und 3.ten Teil unserer Serie:

Webmaster-Tools – Eine kleine Einführung – Teil2

Webmaster-Tools – Eine kleine Einführung – Teil3

Mit den besten Grüßen

Phillip und die SEO Trainees

38 Antworten

Wow, sehr übersichtlich und detailliert. Hat mir sehr gut gefallen als Lektüre für den Einstig bei den Google Webmaster Tools. Schön wären u. U. noch ein paar kurze Tipps welche Tools ein Anfänger noch beachten sollte.

Hi,

da kann ich dir diesen Artikel ans Herz legen 😉

Wow, das ist eine gute Übersicht und das eine oder andere Tool kannte ich noch nicht. Danke.

Vielen Dank für deine kleine Einführung in die Webmaster Tools. Für mich war das bisher ein Buch mit sieben Siegeln. Mit dieser Anleitung weiß ich jetzt genau was ich zu tun habe und wofür die Webmaster Tools sehr nützlich sein können. Ich werde mich gleich an die Umsetzung machen und alles nach Ihrer Vorgabe einrichten. Wirklich geiler Blog.

Schöne Trilogie, im SEO Bereich wird ja viel sinnvolles und weniger sinnvolles geschrieben, aber das ist mal was Solides und Greifbares für Einsteiger in einer sonst eher auf Pinguin & Panda fixierten Bloglandschaft 😉

Ein sehr gut geschriebener Artikel. Sehr verständlich. Dankeschön.

Ich werde mir die 2 anderen auch mal anschauen.

mfg

Danke für diese ausführliche Einführung in die Webmaster-Tools. Die Einrichtung scheint ja relativ einfach zu sein. Ich werde das Ganze jetzt mal ausprobieren und nach eurer Anleitung einrichten.

Hi Timo,

schön das es dir gefallen hat, mein Kollege Andy hat das ganze im 2. und 3.ten Teil der Serie auch noch weiter ausgebaut.

Beste Grüße

Phillip

Hi Phillip,

Super Artikel. Ich wusste gar nicht, dass man auch andere Nutzer anlegen kann. Hab’s gleich mal in Analytics probiert und da geht das ja auch.

Super Sache, das kann ich wirklich gut gebrauchen.

Ich finde, es würde den Artikel noch verbessern, wenn im Artikel Links auf die beiden nachfolgenden Teile der Serie wären.

Hallo Christoph,

vielen Dank für deinen Hinweis, Links sind jetzt eingebaut. Freut mich, dass dir der Artikel gefallen hat.

Beste Grüße

Phillip

Hallo Phillip,

habe gerade erst gemerkt (durch einen Besucher auf meiner Webseite, der von hier kam), dass du mir schon geantwortet hattest.

Vielen Dank, dass du die Links eingebaut hast.

Ich wünsche dir schon mal einen schönen 3. Advent!

Christoph

Danke dafür, genau so eine Einleitung / Erklärung habe ich gesucht. Abschließende Frage, falls die Webmastertools eine Domain sowohl mit „www“ als auch ohne anzeigen aber eine Domainumleitung vorliegt via htacess, kann man bzw. sollte man dann aus den Webmastertools die Domain ohne „www“ löschen?

Hi Chris,

schön das dir der Artikel gefallen hat :).

Zu deiner Frage: Du solltest in jedem Falle beide Varianten in den Webmastertools anlegen, ganz egal ob du eine Weiterleitung via htaccess angelegt hast oder nicht. Wenn du eine der Varianten entfernst, entfällt auch die Möglichkeit Google eine bevorzugte Variante anzugeben und es kann passieren, dass beispielsweise durch falsche externe Verlinkungen URLs ohne „www“ indexiert werden. Ich hoffe ich konnte dir damit weiterhelfen.

Beste Grüße

Phillip

Danke für die gute Erklärung – Sehr gelungen !

Vielen Dank Robert! Hoffe du wirst den nächsten Teil auch durcharbeiten, da wirds noch etwas mehr ins Detail gehen.

Beste Grüße

Phillip

Gerade bei den „Sitelinks“ könnte/sollte erwähnt werden, dass diese auch nur in einer Zeile dargestellt werden können. Also optisch ganz anders aussehen können. Beispiel: Google-Suche „nordmarketing“

Moin, danke für die schöne Erklärung. Wir verwenden natürlich auch die wmt und haben hier doch noch das ein oder andere erfahren. Was mich wundert, ist die zeitliche Verzögerung (2-3 Tage) der wmt. Gerade bei Aufräumarbeiten (doppelte title tags/ crawling fehler) ist es nervig, dass (eigentlich abgearbeitete) Fehler noch Tage/ Wochen später angezeigt werden. Auch stimmt die Auswertung der externen Links nie mit anderen tools überein.

Eigentlich hätte ich von google real-time und Aktualität erwartet, aber vielleicht steckt auch Absicht dahinter (Erziehung zur Geduld).

Moin Tim,

die Zeitverzögerung ist mir auch schon aufgefallen, gerade bei den Crawling-Fehlern scheint Google sich manchmal extrem viel Zeit zulassen und erschwert somit die Fehlerbehebung.

Die Auswertung der Backlinks ist kaum brauchbar für eine ordentliche Analyse, hier werden bei Weitem nicht alle Links angezeigt, aber vermutlich immerhin ein paar für Google relevante Quellen. Für eine ordentliche Backlink-Analyse kommt man wohl nicht um ein kostenpflichtiges Tool herum, aber auch hier ist sollte man vorsichtig sein, denn nicht jedes Tool liefert brauchbar Daten.

Beste Grüße

Phillip

Danke Phillip für die gute Einführung in die Google Webmaster Tools. Schade, dass es den Yahoo Siteexplorer nicht mehr gibt 🙁 – Besonders die Backlinkanalyse war echt klasse

Gerne doch schön, dass es dir gefallen hat. RIP – Yahoo Siteexplorer.

Beste Grüße

Phillip

Hallo SEO Trainees,

ich verweise auch nochmal (wie ein paar Kommentare höher) an das Ebook von den Trustagents zum Thema GWT, das ist wirklich komplex und behandelt alle Punkte ausführlich.

Zur Einstellung der Crawlinggeschwindigkeit: Da glaube ich eher an den Osterhasen, als damn man Google hier Anweisungen geben kann, die dann auch tatsächlich befolgt werden. Das entspricht etwa dem alten MetaTag „revisit-after: 5 minuten“.

Beste Grüße,

Marcell

Hi Seodeluxe,

da ist natürlich was dran, vermutlich lässt sich Google hier keine Vorschriften machen. Ich denke allerdings, dass man zumindest die Möglichkeit hat, Google beizubringen, welche Seiten vielleicht häufiger gecrawlt und welche eben nicht so häufig gecrawlt werden sollten. Die Crawlinggeschwindigkeit wird dadurch vermutlich nicht beeinflusst. Aber ich würde hier auch, wie bereits im Artikel geschrieben, immer die Standardeinstellung empfehlen und diesen Job Google überlassen.

Beste Grüße

Phillip

Als Webdesigner redet man sich den Mund im Analytics begreich ja gerne fusselig ^^Das nächste mal schicke ich meiner Kundin den Link hier, das geht eindeutig fixer 🙂

Sehr schön erklärt auch für Webdesigner !

Schöner Artikel. Ich denke viele Webmaster kennen die GWT noch nicht, oder haben diese bisher kaum beachtet. Hier wird euer Artikel sicher weiterhelfen. Leicht geschrieben und viele nützliche Infos drin!

Sehr gut geschriebene Einführung. Kannte zwar schon alles, aber für einen Anfänger ist alles drinn, was man Wissen muss!

Danke für die Hinweise. Der Tipp mit der bevorzugte Domain hatte mir bislang immer gefehlt. Weiter so und vielen Dank!

Schön, dass Ihr das Thema Google Webmaster Tools aufgreift. Für die Leser des Artikels dürfte auch das Google Webmaster Tools E-Book interessant sein, über welches ihr kürzlich berichtet habt. Das gibt es unter http://www.trustagents.de/unternehmen/publikationen/google-webmaster-tools-e-book als Download

Danke Ralph, dass E-Book hatte ich ganz vergessen. Reinschauen lohnt sich auf jeden Fall.

Beste Grüße

Phillip

Wenn man bei uns z.B. bei URL Parameter die Entscheidung google überlässt sind es innerhalb kürzester Zeit das dreiche an Doppelte METAs…. wenn wir die Entscheidung von uns getroffen KEINE URLs sind es deutlich weniger….. Gibt es noch nen Tipp dafür?

Hallo Daniel,

bin mir nicht ganz sicher, ob ich dich richtig verstehe. Du meinst vermutlich, dass beispielsweise ein bestimmter Artikel mehrmals in den SERPS auftaucht, wenn du Google die Entscheidung mit den Parametern überlässt.

Teilweise kommt es vor, dass Google die Parameter in den URLs nicht richtig interpretieren kann und diese somit fälschlicherweise in die SERPS aufgenommen werden. Aus diesem Grund würde ich auf Nummer sicher gehen und dir empfehlen die Parameter, die du in deinen URLs verwendest, in den Webmaster-Tools anzulegen. Die Probleme sollten damit nach einer Weile behoben sein. Falls du etwas anderes gemeint hast, schreib gerne noch mal in die Kommentare, dann versuche ich darauf einzugehen.

Beste Grüße

Phillip

Schönes Intro 🙂

Wenn man eine neutrale Domain hat und nur einen bestimmten Suchmarkt bedienen möchte, sollte man sich das Geotargeting genauer anschauen.

Die Veränderungen sind zum Teil recht erstaunlich

Aber man sollte auch aufpassen, das Geotargetting wirkt nicht wie eine Länder-Tld. Es verstärkt zwar das Ranking in der gewählten Region, allerdings gibt es in anderen Regionen entsprechend stärkere Einbußen.

Ganz deutlich kann man das in unsrem sprachlichen 3-Ländereck .de .at .ch beobachten

Grüße

Maxim

Vielen Dank @Lars und @Maxim, schön das euch die kleine Einführung gefallen hat :)!

Danke auch für den Hinweis zum Geotargeting. Bei einer neutralen Top-Level-Domain macht es in bestimmten Fällen durchaus Sinn die Website mit einem bestimmten Standort zuverknüpfen, um die Suchergebnisse für geografische Anfragen zuverbessern. Aber wie du schon richtig sagst, dadurch hat man auch entsprechende Einbußen in anderen Regionen, man sollte sich hier vorher im klaren darüber sein, ob eine entsprechende geografische Trennung wirklich sinnvoll ist.

Beste Grüße

Phillip

Deine Erklärung ist wirklich gründlich und genau…danke